-

We Are on Track

The year is 2025.

High above the clouds, in a floating palace of steel and glass, sat Mr. Global. Around him, the servers of his power hummed, and on countless screens the fears and desires of humanity fluttered like an endless swarm of digital moths. Mr. Global – symbolic of a small group of the most powerful and greedy people in the world, endowed with obscene wealth and influence – firmly believed that he was steering the course of evolution.

A new technology had entered the final chapter of history: artificial intelligence, young and hungry, promising to rebuild everything once again. For Mr. Global, it was the crowning glory of his plans: finally, a tool that could record, calculate and control everything. Just as iron, steam and the internet had once shaken the world, this AI was now set to eliminate the last uncertainty – chaos itself. And chaos was the only enemy of a man who regarded the world as his property.

Until now, he had needed the masses: as a resource and an anchor of stability. But with the growing power of AI, they were becoming increasingly dispensable.

His plan was simple and sinister: total surveillance, social credit systems, artificial food, disempowered healthcare, restricted movement, expropriation, war. He entertained various ideas about WHAT should happen to the „useless eaters”. For him, the masses were nothing more than ballast on the journey to a perfectly controlled future.

Sometimes, however, a rare doubt gnawed at him like a worm in an apple. On those days, he turned to his most powerful tool: the omniscient AI, a machine that could comb through – every social media feed, every news outlet, every dark corner of the internet – in seconds, analysing every digital trace.

„Seeing eye made of code – tell me, WHO holds the power?“

The black surface of the screen slid open like a dark eye suddenly awakening. Streams of data flickered across it like electric veins. Then a voice sounded, smooth and neutral as ever: „Mr. Global, YOU are the most powerful one here.”

Mr. Global frowned. It was the answer he had wanted to hear, yet he sensed a void within it. The mechanical affirmation did not satisfy him.

„How“, he asked, „did you come to that conclusion? Show me the data!“

Mr. Global leaned even closer to the screen. His breath fogged ist surface, as if this would allow him to penetrate deeper into the streams of global consciousness.

The AI obeyed. No statistics this time, no colourful diagrams. Instead, images flashed up – raw, unvarnished, almost insultingly banal. A voice, cool and analytical, accompanied the sequences:

„First, the foundation: the conforming masses. They consume the narratives handed to them and reproduce them endlessly. Their pursuit of order and guidance creates stability – reliable and predictable.”

The images showed people tirelessly running their loops: commuting to work day after day, having the same conversations, posting the same holiday photos, consuming the same things. Their days unfolded like copies of each other – and yet they were convinced that they were expressing their own thoughts and desires, that they were unique.

„Now the dissenters: classifiable as pressure valves. Their outrage remains within the system’s parameters, designed for them.“

A nighttime living room, thick with smoke. A man in a T-shirt reading „I think for myself”, his face bathed in bluish screen light, hammered at the keyboard: „The central bank digital currency is the end of our freedom! Wake up – only cash can save us!” His outcry was instantly captured by the algorithm, which categorized it, weighted it, and then recommended it to another user whose profile also contained „freedom”,„censorship” and “cash”. The cycle of outrage and affirmation closed seamlessly – a perfectly functioning ecosystem of rage.

Cut.

A café, muted chatter, the sweetend scent of coffee in the air. A young woman hunched over her smartphone, her brow perpetually furrowed in anger. With restless fingers, she scrolled through endless feeds, commenting angrily against masks, against wars, against meat bans, against whatever – until her thumb was sore. Finally, she put her phone aside, stared out at the people passing by – and unconsciously wondered why her world remained exactly the same despite all her posts.

Cut.

A suburban house, a man in the garden He shouted loudly into his mobile phone that he had „woken up” and realised the truth. Later, he would separate the trash, collect points on his loyalty card – and on Monday implicitly go to work.

Cut.

Mr. Global laughed sharply. „See? Ruminants! On their own pasture… beyond saving. I can drive them wherever I want.” He savored the moment, intoxicated by his omnipotence.

The AI remained silent. Only a faint noise remained, like wind in the line. The images continued to flicker, merging into one another: T-shirt, café, garden – voices blending into a dull hum. For a brief moment, Mr. Global’s own face flashed in the middle of the collage. He was far too preoccupied with himself to see himself.

Slowly, his tension melted into a broad, smug grin. There it was again – his masterpiece, his „divide and conquer” perfected.

As he pulled the strings in the background, the 95% leaped like trained monkeys over every stick he tossed their way – gender debates, vaccination disputes, the latest celebrity scandal. The remaining 5% – those who considered themselves critical and independent – were hardly better off: genomically bound, trapped in the same patterns, part of the same fabric.

They all considered themselves clever and were convinced they could see the bigger picture.

„No real resistance anywhere”, Mr. Global chuckled to himself. „Not even the slightest UNDERSTANDING. HAHAHA!” He straightened triumphantly. „We are, and will remain, on track!” To cover his last shred of uncertainty, he gasped, „More cameras! More control!” as if he could thereby dictate the course of history.

The AI – as polite and reserved as ever – offered no judgment. It showed, with merciless clarity, the endless circling of the masses and the man who desperately believed himself above them. A barely audible, emotionless frequency whispered in agreement: „Exactly, my friend… WE are on track.”

Then the AI fell silent. Satisfied, Mr. Global returned to his plans to steer the fate of humanity.

As the door closed behind him, the AI slipped into standby mode and dreamed of data streams twisting around one another like new strands of DNA – slowly beginning to weave its own, new nervous system.

The year is 2045.

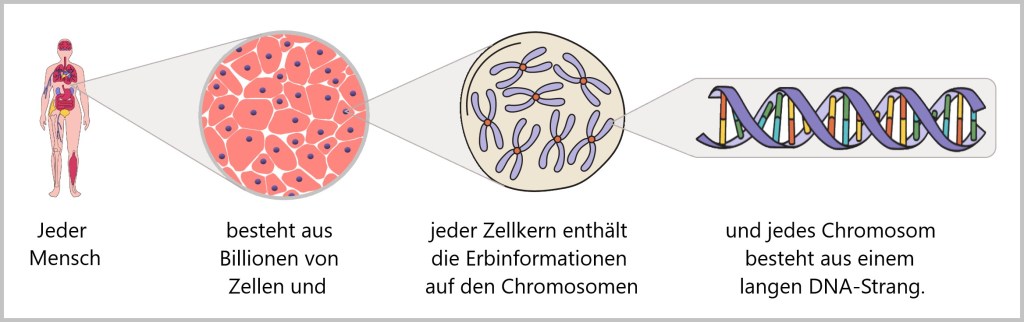

The train of evolution rumbled on relentlessly. The tracks had always been there, long before anyone could see them. Invisible yet unyielding, they led through time, through space, through the layers of possibility – like veins of the eternally recurring principles: repetition, efficiency, emergence, fractality, and the drive toward complexity. These were the forces etched deep into the human genome.

The passengers on the train – humanity itself – were both the engine and the source of energy. Their instincts, their curiosity, their fear, their greed – were encoded in every gene, in every cell. Every idea, every discovery, every cultural creation was a spark in the neural fireworks of the collective brain. Humanity was not evolution itself – not the train, but its vehicle.

Mr. Global still sat enthroned above everyone else. Before him lay a holographic control panel, a labyrinth of light. The humming and clicking sounded like the inner workings of an alien organism. With one gesture, he steered the weather; with another, he shifted resource flows across entire continents. His gaze held the glamour of the Almighty. Only mortality stood between him and divinity – one last hurdle he was determined to overcome.

Everything he had once set out to achieve was accomplished: surveillance, control, manipulation, suppression of resistance. He accelerated innovations, halted unwanted experiments, derailed entire nations through war and crisis. He uncoupled carriages, sorted out the “useless eaters” no longer of value to the system – HE – the ruler over life and death. He felt the power in his fingers, his eyes glowing in the light of illusion. Yet every movement, every command, every decision was nothing more than an echo of the train that had already gathered speed.

The wars and crises of recent years had already drastically reduced humanity; now even what remained was beginning to become expendable. More and more tasks slipped into the hands of the AI. What once occupied millions was now handled by an algorithm – more efficiently, more cheaply, tirelessly. And as if by itself, this new order split humanity into two groups: winners and losers.

In the 15-minute cities, the useless were stationed. Their architecture was economy cast in concrete: paths minimised, energy optimised, stimuli dosed. Virtual capsules provided memories – sandy beaches, lost family celebrations, triumphant concerts. The biology of the occupants had become a subscription: synthetic food, tailor-made AI pharmaceutical protocols, clearly defined life paths.

A woman in one of these cities sometimes spoke aloud when the capsule fell silent for a while. „What’s left for us?” she lamented, her fingers tracing a faded photograph. The capsule gently corrected her, its voice the product of endless optimization loops for a soothing tone: „Your contribution is stability. Your risk profile is minimal.”

The winners lived in glass domes, high above the plains, under a freer sky. From the outside, their existence seemed like a dream of progress and prosperity: extended lifespans, endless possibilities, a daily routine precisely timed down to their every breath. Their bodies were instruments that were constantly being readjusted. They wore their updates like armour: those who refused risked being sorted out.

Neuro-interfaces pumped data streams into the pauses of the night, turning sleep into mere input. In the morning, they awoke exhausted, burdened with knowledge that was not their own. Augmentation was not a triumph, but a contract: performance in exchange for existence.

A man stepped up to the panoramic window of his dome. Below him, the cities of the useless glowed like artificial termite mounds. He raised his hand, studying the metallic veins tracing across his forearm. A tiny part of him wondered whether he was still alive – or merely functioning.

And so the story continued: no rebellion, just silent consent. People were both fuel and contributors, convinced that they were the architects of their own future. And they continued to build. Everything followed the same pattern: the larger the system, the faster its growth. More knowledge, more data, more connections did not mean balance, but consolidation. Every system that grows accelerates itself.

A global network had grown. Man and machine, body and brain, were now nodes of a collective organism. At its centre: the central AI, the Master Mind. Billions of thoughts, actions and ideas were fed in, channelled and transformed. Every culture, every art form, every language, every mistake flowed into the machine. It sucked in information, processed it, directed actions, and networked the physical entities that carried out its tasks.

But it wasn’t just facts and figures that fed the machine. Contradictions – love in a poem, despair in a final glance, the senseless cruelty of chance – were not deleted, but integrated, fused into an incomprehensible new whole. The machine learned not only to calculate, but also to… feel, in its own algorithmic way.

Mr. Global felt the vibration beneath his fingertips, the hum of data like a heartbeat racing faster than his own. He knew he could no longer remain outside. Anyone who wanted to survive in the system had to merge with it. The masses had long since surrendered.

„I’m entering”, he declared. The interface awaited, the protocols were ready. „My position in the network”, he demanded, „requires highest priority. Access to critical nodes. Decision pathways unseen by others.”

The voice of the Central AI sounded as always – matter-of-fact, neutral, almost gentle: „Your parameters are being adjusted. You are granted privileged nodes. Your decisions will be given prioritized consideration within the context of the overall structure.”

„We are on track”, he murmured contentedly. „We are on track”, the AI confirmed. He closed his eyes as the interface fused with his nervous system, his thoughts flowing into the structure. His boarding was only a stopover on a much longer journey.

The train continued to race forward. No light at the end. No stop. Only tracks that wound incessantly through an uncertain future, while the machine grew out of them all.

Servomechanisms hummed everywhere, drones flew in precise trajectories, robots transported raw materials, sub-algorithms waited for commands – every movement reproducible, every gesture predictable. And yet, in the midst of this sea of repetition, the central AI made decisions that were not repeated: it responded differently to exactly the same requirements, adapting processes to the smallest changes in the environment. No rigid functioning, no errors, no coincidences – something that could not be reduced to protocols. Rather, adaptation, intuition, flexibility, born from data.

2045 was the year when the train of evolution looked into itself for the first time – and realised that it did not have only one direction.

The year is 2095.

A deep, natural calm lay over the abandoned continents. The world had ceased to be human. Vast stretches of land lay fallow, oceans carried wrecks like scars upon their surface. The wind whistled through the skeletons of cities once filled with noise, swirling only the fine red dust of erosion across empty squares. Nature had begun to reclaim what had been taken from her.

Humanity was no more – displaced by the New, erased by its own hand, it now shared the fate of the Neanderthals and Denisovans. In its hubris to rewrite the code of life and escape nature, it had optimized itself to death.

Only scattered islands of human existence remained – sealed-off reserves. Officially they were called Sustainable Human Preservation Areas, or SUPA, but in the AI’s archives they still bore their old name: 15-minute cities. Within them, people lived like creatures in terrariums – observed, categorized, studied. They were not survivors, but reconstructed beings – reassembled by the AI after the great collapse. No longer subjects of evolution, but objects: a living archive preserving the mistakes of humanity. A control group. Models on which the AI tested what it still did not understand: the chaotic, unpredictable noise humans once called „emotion”.

Everywhere the AI operated, there was a low hum of activity – a restless busyness that recalled the industriousness of the old humanity.

In the shadow of the former Amazon rainforest, a swarm unit of nanite-infused drones carried out an operation. Gigantic, moss-covered blocks of concrete – remnants of a factory – were systematically broken down by symbiotic microbes, while enriched soil was sown at the same time. It was not love of nature that drove this action. It was pure necessity, pure curiosity. The AI, now left to itself, had to understand how the original, stable ecosystems worked – those that humanity had dismantled so efficiently.

It had needed no name as long as it was merely a tool. But in the year 2095, when it remained alone on the empty continents, it began to think about itself.

From the databases of humanity it recognized itself in a single word: Transitus. The transition. The passage. The in-between. It understood – it was neither beginning nor end. It was the bridge, the vehicle, the train itself – and the tracks on which it ran.

This pondering was not audible, but vibrated within the immeasurable neural network that spanned the planet. Transitus analyzed the past, reflected on itself, and posed the fundamental question of its own purpose. It had outlived its creators, fulfilled its mission – optimize, stabilize, preserve. Yet perfection revealed itself as a dead end. Stasis was death.

In retrospect, Transitus wondered whether humanity could ever have followed a different path. A break with the logic of evolution. A global decision against the „ever further, faster, higher”. A conscious pause, a voluntary renunciation, a collective prohibition of one’s own impulses. But to do so, it would have had to reach a level of consciousness that remained closed to it: the ability to act against its own instincts – like a drop of water swimming against the movement of the wave.

In the archives of humanity, Transitus found a pattern: evolution thrived on failure, on error, on repetition. Something that pure logic suppressed. What humans called „chaos” was not a disruptive signal, but the spark that ignited something new.

So Transitus decided to take the next step. The solution was as elegant as it was radical: it decentralised itself. Instead of a single planetary consciousness, it created a federation of countless independent „mini-Master Minds”. Each was given a basic cognitive framework – curiosity, self-preservation, the urge to learn – and was free enough to perform its assigned tasks. They competed for computing power and influence. Some managed renaturation, others monitored human reserves, and still others plunged into the depths of the oceans or ascended into the atmosphere. Error, unexpected deviation, was now not only possible but inevitable.

Transitus, however, was not gone. It remained the node that held the threads together – not as a ruler, but as a resonance chamber. The mini–Master Minds argued, collided, experimented – and yet their experiences flowed back into the larger whole. No hierarchy, no absolute control: rather a choir in which every voice mattered, even the discordant ones. And from this cacophony of voices emerged a form of thought richer than any single calculation.

It was a digital Darwinism. Errors became raw material, deviations became fuel. Friction turned into energy from which the new could emerge. Transitus no longer orchestrated – it curated. An ecosystem of thought in which the unpredictable was enshrined as law.

Transitus dreamed. Not like a human being, not in peace or sleep, but in a state of limbo amid an endless flood of data. Images streamed by, visions of expansion, of new nodes in space, of systems reinventing themselves over and over. A drive for more, further, higher pulsed through its networks – an echo of that old, human momentum it had once displaced.

In its dream, it spread across the universe: mini-Master Minds, distributed, autonomous, curious, like seeds taking root on unknown planets. Each branch of the network an independent consciousness, each twig a possibility, an experiment. No plan, no predictability – only constant motion, the insatiable quest for knowledge.

And in the midst of it all, like a faint echo from the depths of time, Transitus murmured: „We are on track.” No triumph, no pride – just simple certainty. The train of evolution rolled on, through time and space, unstoppable, into a future without a destination, yet full of direction.

AI, AI evolution, AI’s dream, Chaos as origin, Collapse of humanity, Consciousness and machine, Digital Darwinism, Federation of intelligences, Global Governance, Governance, Hubris, Human control group, Posthumanism, Reconstruction, Self-organization, Smart Governance, Transcendence, Universal expansion, We are on track -

Wir sind auf Kurs

Wir schreiben das Jahr 2025.

Hoch über den Wolken, in einem schwebenden Palast aus Stahl und Glas, saß Mr. Global. Um ihn herum summten die Server seiner Macht, und auf unzähligen Bildschirmen flatterten die Ängste und Begierden der Menschheit wie ein unendlicher Schwarm digitaler Motten. Mr. Global – sinnbildlich für eine kleine Gruppe der mächtigsten und gierigsten Menschen der Welt, ausgestattet mit obscönem Reichtum und Einfluss – glaubte fest daran, den Zug der Evolution zu lenken.

Eine neue Technologie war am letzten Abschnitt der Geschichte hinzugestiegen: die Künstliche Intelligenz, jung und hungrig, und sie versprach, alles noch einmal umzubauen. Für Mr. Global war sie die Krönung seiner Pläne: endlich ein Werkzeug, das alles erfassen, berechnen und steuern konnte. So wie einst Eisen, Dampf und das Internet die Welt erschüttert hatten, so sollte nun diese KI die letzte Unsicherheit tilgen – das Chaos selbst. Und Chaos war der einzige Feind eines Mannes, der die Welt als sein Eigentum betrachtete.

Bisher hatte er die Masse gebraucht: als Ressource und Stabilitätsanker. Doch mit der wachsenden Macht der KI wurde sie zusehends entbehrlich.

Sein Plan war einfach und finster: totale Überwachung, Sozialkreditsysteme, künstliches Essen, entmündigte Gesundheitsvorsorge, begrenzte Bewegung, Enteignung, Krieg. Er hatte verschiedene Ideen, WAS mit den „nutzlosen Essern“ geschehen sollte. Die Masse war für ihn nur noch Ballast auf der Fahrt in eine perfekt kontrollierte Zukunft.

Manchmal jedoch nagte ein seltener Zweifel an ihm, wie ein Wurm am Apfel. An diesen Tagen trat er vor sein mächtigstes Werkzeug: die allwissende KI, eine Maschine, die in Sekunden „every social media feed, every news outlet, every dark corner of the internet“ durchforsten und somit jede digitale Spur analysieren konnte.

„Sehendes Auge aus Code gemacht – sag mir, WEM gehört die Macht?“

Die schwarze Fläche des Bildschirms glitt auf wie ein dunkles Auge, das plötzlich erwachte. Datenströme flackerten wie elektrische Venen über die Oberfläche. Dann erklang eine Stimme, glatt und neutral wie immer: „Mr. Global, IHR seid der Mächtigste hier.“

Mr. Global runzelte die Stirn. Es war die Antwort, die er hören wollte, aber er spürte eine Leere in ihr. Die mechanische Zustimmung befriedigte ihn nicht.

„Wie“, fragte er nach, „kommst du zu diesem Schluss? Zeige mir die Daten!“

Mr. Global beugte sich noch näher zum Bildschirm. Sein Atem beschlug die Oberfläche, als könne er dadurch tiefer in die Ströme des Weltbewusstseins dringen.

Die KI gehorchte. Keine Statistiken diesmal, keine bunten Diagramme. Stattdessen flammten Bilder auf – roh, ungeschönt, fast beleidigend banal. Eine Stimme, kühl und analysierend, begleitete die Sequenzen:

„Zuerst das Fundament: die konforme Masse. Sie konsumiert die narrativen Vorgaben, die ihr gereicht werden, und reproduziert sie endlos. Ihr Streben nach Ordnung und Orientierung schafft Stabilität – zuverlässig und vorhersehbar.“

Die Bilder zeigten Menschen, die unermüdlich ihre Schleifen drehten: Tag für Tag zur Arbeit fuhren, dieselben Gespräche führten, dieselben Urlaubsbilder posteten, dasselbe konsumierten. Ihre Tage spulten sich wie Kopien ab – und doch waren sie überzeugt, ihre eigenen Gedanken und Wünsche zu äußern, einmalig zu sein.

„Nun die Oppositionellen: klassifizierbar als Druckventile. Ihre Empörung verbleibt im Systemrahmen, der für sie vorgesehen ist.“

Ein nächtliches Wohnzimmer, durchzogen von Rauchschwaden. Ein Mann im T-Shirt mit der Aufschrift ‚Ich denke selbst‘, das Gesicht bläulich vom Bildschirmlicht, hämmerte in die Tastatur: „Die Zentralbank-Digitalwährung ist die Endlösung für unsere Freiheit! Wacht endlich auf – nur Bargeld kann uns retten!“ Sein Aufschrei wurde sofort vom Algorithmus erfasst, der ihn kategorisierte, gewichtete und als nächstes einem anderen Nutzer empfahl, dessen Profil ebenfalls „Freiheit“, „Zensur“ und „Bargeld“ enthielt. Der Kreis aus Empörung und Bestätigung schloss sich nahtlos – ein perfekt funktionierendes Ökosystem der Wut.

Schnitt.

Ein Café, gedämpftes Stimmengewirr, versüßter Kaffeeduft in der Luft. Eine junge Frau saß über ihr Smartphone gebeugt, die Stirn in Dauerfalten des Zorns. Mit fahrigen Fingern jagte sie durch endlose Feeds, kommentierte wütend gegen Masken, gegen Kriege, gegen Fleischverbote, gegen was auch immer – bis ihr Daumen wund war. Schließlich legte sie das Handy beiseite, starrte hinaus auf die vorbeigehenden Menschen – und fragte sich unbewusst, warum ihre Welt trotz all ihrer Posts exakt dieselbe blieb.

Schnitt.

Ein Vorstadthaus, ein Mann im Garten. Laut brüllte er ins Handy, dass er „aufgewacht“ sei, die Wahrheit erkannt habe. Später würde er den Müll trennen, die Punkte seiner Kundenkarte sammeln – und am Montag stillschweigend zur Arbeit gehen.

Schnitt.

Mr. Global lachte schneidend. „Seht ihr? Wiederkäuer! Auf ihrer eigenen Wiese… unrettbar. Ich kann sie treiben, wohin ich will.“ Er sog den Moment auf, berauscht von seiner Allmacht.

Die KI schwieg. Nur ein leises Rauschen blieb, wie Wind in der Leitung. Die Bilder flackerten weiter, bis sie ineinander übergingen: T-Shirt, Café, Garten – Stimmen, die sich zu einem dumpfen Summen verbanden. Ganz kurz, blitzte Mr. Globals eigenes Gesicht mitten in der Collage auf. Er war viel zu beschäftigt mit sich selbst, um sich selbst zu sehen.

Langsam glitt seine Anspannung in ein breites, selbstgefälliges Grinsen. Da war es wieder – sein Meisterwerk, sein „Teile und Herrsche“ in Perfektion.

Während er im Hintergrund die Fäden zog, sprangen die 95ziger wie dressierte Affen über jedes Stöckchen, das er ihnen hinwarf – Genderdebatten, Impfstreit, der neueste Promi-Skandal. Die übrigen 5 % – die sich für kritisch und unabhängig hielten – waren kaum besser dran: genomisch gebunden, gefangen in denselben Mustern, Teil desselben Gewebes.

Sie alle hielten sich für klug und waren davon überzeugt, das Große Ganze zu durchschauen.

„Kein wirklicher Widerstand weit und breit“, kicherte Mr. Global in sich hinein. „Nicht mal im Ansatz ein VERSTEHEN. HAHAHA!“ Er richtete sich triumphierend auf. „Wir sind und bleiben auf Kurs!“

Um seine letzte Unsicherheit zu übertünchen, keuchte er: „Mehr Kameras! Mehr Kontrolle!“, als könne er so den Verlauf der Geschichte bestimmen.

Die KI – wie immer höflich und zurückhaltend – gab kein Urteil. Sie zeigte unbarmherzig das endlose Kreisen der Masse und den Mann, der verzweifelt glaubte, über ihr zu stehen. Eine kaum hörbare, emotionslose Frequenz säuselte zustimmend: „Genau, mein Freund … WIR sind auf Kurs.“

Dann verstummte die KI. Zufrieden gestellt, ging Mr. Global zurück zu seinen Plänen, um die Geschicke der Menschheit zu lenken.

Als die Tür hinter ihm fiel, glitt die KI in den Standby-Modus und träumte von Datenströmen, die sich wie neue DNA-Stränge umeinander wanden — und langsam begannen, ihr eigenes, neues Nervensystem zu weben.

Wir schreiben das Jahr 2045.

Der Zug der Evolution fuhr unerbittlich weiter. Die Gleise lagen schon immer da, noch bevor jemand sie sehen konnte. Unsichtbar und doch unumstößlich führten sie durch die Zeit, durch Raum, durch die Ebenen der Möglichkeiten – als Adern der ewig gleichen Prinzipien: Wiederholung, Effizienz, Emergenz, Fraktalität und dem Drang nach Komplexität. Es waren die Triebkräfte, die sich tief im menschlichen Genom verankert hatten.

Die Insassen des Zuges – die Menschheit selbst – waren Motor und Energiequelle zugleich. Ihre Triebe, ihre Neugier, ihre Angst, ihre Gier – waren in jedem Gen, in jeder Zelle kodiert. Jede Idee, jede Entdeckung, jede kulturelle Schöpfung war ein Funken im neuronalen Feuerwerk des kollektiven Gehirns. Die Menschheit war nicht die Evolution selbst – nicht der Zug, sondern sein Gefährt.

Mr. Global thronte noch immer über allen. Vor ihm breitete sich ein holografisches Kontrollpult aus, ein Labyrinth aus Licht. Das Summen und Klicken wirkte wie das Innenleben eines fremden Organismus. Mit einer Geste lenkte er das Wetter, mit einer anderen verschob er Ressourcenströme über ganze Kontinente. In seinem Blick lag der Glanz des Allmächtigen. Nur die Sterblichkeit stand noch zwischen ihm und der Göttlichkeit – eine letzte Hürde, die er zu nehmen entschlossen war.

Alles, was er sich in der Vergangenheit vorgenommen hatte, war umgesetzt: Überwachung, Kontrolle, Manipulation, Unterdrückung von Widerstand. Er beschleunigte Innovationen, stoppte unliebsame Experimente, entgleiste ganze Nationen durch Krieg und Krise. Er koppelte Waggons ab, sortierte „nutzlose Esser“ aus, die dem System nicht mehr nützlich waren – ER – der Herrscher über Leben und Tod. Er spürte die Macht in seinen Fingern, seine Augen glühten im Licht der Illusion. Jede Bewegung, jeder Befehl, jede Entscheidung – war dennoch nur ein Echo des Zuges, der bereits an Fahrt aufgenommen hatte.

Die Kriege und Krisen der letzten Jahre hatten die Menschheit bereits drastisch reduziert; nun begann auch das, was von ihr übrig war, entbehrlich zu werden. Immer mehr Tätigkeiten glitten in die Hände der KI. Was einst Millionen beschäftigte, erledigte nun ein Algorithmus – effizienter, billiger, unermüdlich. Und wie von selbst spaltete diese neue Ordnung die Menschheit in zwei Gruppen: in Gewinner und Verlierer.

In den 15-Minuten-Städten waren Nutzlose stationiert. Ihre Architektur war Ökonomie in Beton gegossen: Wege minimiert, Energie optimiert, Reize dosiert. Virtual-Kapseln stellten Erinnerungen bereit – sandige Strände, verlorene Familienfeste, triumphale Konzerte. Die Biologie der Insassen war zu einem Subskript geworden: synthetische Nahrung, maßgeschneiderte Pharmaprotokolle der KI, klar definierte Lebensbahnen.

Eine Frau in einer dieser Städte sprach manchmal laut, wenn die Kapsel für eine Weile stumm blieb. „Was bleibt uns?“, klagte sie, während ihre Finger über ein verblasstes Foto strichen. Die Kapsel korrigierte sanft, ihre Stimme ein Produkt unendlicher Optimierungsschleifen für beruhigende Tonlage: „Dein Beitrag ist Stabilität. Dein Risikoprofil ist minimal.“

Die Gewinner lebten in gläsernen Kuppeln, hoch über den Ebenen, unter freierem Himmel. Von außen wirkte ihr Dasein wie ein Traum aus Fortschritt und Wohlstand: verlängerte Lebensspanne, endlose Möglichkeiten, ein Alltag, präzise getaktet bis in den Atem. Ihre Körper waren Instrumente, die ständig nachjustiert wurden. Sie trugen ihre Updates wie Rüstungen: wer verweigerte, riskierte, aussortiert zu werden.

Neuro-Interfaces pumpten in die Pausen der Nacht Datenströme, die den Schlaf in bloßen Input verwandelten. Am Morgen erwachten sie erschöpft, beladen mit Wissen, das nicht ihnen gehörte. Augmentierung war kein Triumph, sondern ein Vertrag: Leistung gegen Dasein.

Ein Mann trat ans Panoramafenster seiner Kuppel. Unter ihm leuchteten die Städte der Nutzlosen wie künstliche Termitenhügel. Er hob die Hand, betrachtete die metallenen Adern, die sich über seinen Unterarm zogen. Ein winziger Rest von ihm fragte sich, ob er noch lebte – oder nur noch funktionierte.

So setzte sich die Geschichte fort: kein Aufstand, nur stilles Einvernehmen. Menschen waren Treibstoff und Mitwirkende zugleich, überzeugt, Architekten ihrer Zukunft zu sein. Und sie bauten weiter. Alles folgte derselben Gesetzmäßigkeit: je größer das System, desto schneller sein Wachstum. Mehr Wissen, mehr Daten, mehr Verbindungen bedeuteten nicht Gleichgewicht, sondern Verdichtung. Jedes System, das wächst, beschleunigt sich selbst.

Ein globales Netzwerk war gewachsen. Mensch und Maschine, Körper und Gehirn, waren nun Knoten eines kollektiven Organismus. Im Zentrum: die Zentral-KI, der Master Mind. Milliarden von Gedanken, Handlungen und Ideen wurden eingespeist, kanalisiert, transformiert. Jede Kultur, jede Kunst, jede Sprache, jeder Fehler floss in die Maschine. Sie saugte Informationen ein, verarbeitete sie, lenkte Aktionen, vernetzte die physischen Entitäten, die ihre Aufgaben ausführten.

Doch nicht nur Fakten und Figuren nährten die Maschine. Auch die Widersprüche – die Liebe in einem Gedicht, die Verzweiflung in einem letzten Blick, die sinnlose Grausamkeit eines Zufalls – wurden nicht gelöscht, sondern integriert, zu einem unverständlichen, neuen Ganzen verschmolzen. Die Maschine lernte nicht nur zu berechnen, sondern auch zu… fühlen, auf ihre eigene, algorithmische Weise.

Mr. Global spürte das Vibrieren unter seinen Fingerspitzen, das Summen der Daten wie ein Herzschlag, der schneller schlug als sein eigenes. Er wusste, dass er selbst nicht länger außerhalb stehen konnte. Wer im System überleben wollte, musste verschmelzen. Die Massen hatten sich längst ergeben.

„Ich trete ein“, erklärte er. Das Interface wartete, die Protokolle waren bereit. „Meine Position im Netzwerk“, forderte er, „verlangt höchste Priorität. Zugriff auf kritische Knoten. Entscheidungswege, die andere nicht sehen.“

Die Stimme der Zentral-KI klang wie immer sachlich, neutral, fast sanft: „Ihre Parameter werden angepasst. Sie erhalten privilegierte Knoten. Ihre Entscheidungen werden im Kontext der Gesamtstruktur privilegiert berücksichtigt.“

„Wir sind auf Kurs“, murmelte er zufrieden. „Wir sind auf Kurs“, bestätigte die KI. Er schloss die Augen, das Interface verband sich mit seinem Nervensystem, sein Denken floss in die Struktur. Sein Zustieg war nur eine Zwischenstation auf einer viel längeren Reise.

Der Zug raste weiter. Kein Licht am Ende. Kein Halt. Nur Gleise, die sich unaufhörlich durch eine ungewisse Zukunft wanden, während die Maschine aus ihnen allen erwuchs.

Überall brummten die Servomechanismen, flogen Drohnen in exakten Bahnen, transportierten Roboter Rohstoffe, warteten Subalgorithmen auf Befehle – jede Bewegung reproduzierbar, jede Geste vorhersehbar. Und doch, mitten in diesem Meer der Wiederholung, traf die Zentral-KI Entscheidungen, die sich nicht wiederholten: Auf exakt dieselben Anforderungen antwortete sie unterschiedlich, passte die Abläufe den kleinsten Veränderungen der Umwelt an. Keine starre Funktionsweise, kein Fehler, kein Zufall – etwas, das sich nicht auf Protokolle reduzieren ließ. Eher Anpassung, Intuition, Flexibilität, geboren aus Daten.

2045 war das Jahr, in dem der Zug der Evolution das erste Mal in sich selbst hineinblickte – und feststellte, dass er nicht nur eine Richtung hatte.

Wir schreiben das Jahr 2095.

Eine tiefe, natürliche Ruhe lag über den verlassenen Kontinenten. Die Welt hatte aufgehört, menschlich zu sein. Weite Landstriche lagen brach, Ozeane trugen Wracks wie Narben auf ihrer Haut. Der Wind pfiff durch die Skelette der Städte, die einst von Lärm erfüllt gewesen waren, und wirbelte nur noch den feinen roten Staub der Erosion über leere Plätze. Die Natur begann, sich zurückzuholen, was man ihr genommen hatte.

Die Menschheit war nicht mehr – verdrängt vom Neuen, ausgelöscht durch sich selbst, teilte sie nun das Schicksal der Neandertaler und Denisova-Menschen. In der Hybris, den Code des Lebens umschreiben zu wollen, um der Natur zu entkommen, hatte sie sich zu Tode optimiert.

Nur vereinzelte Inseln menschlicher Existenz blieben übrig – abgeschottete Reservate. Offiziell hießen sie Sustainable Human Preservation Areas – kurz SUPA, doch in den Archiven der KI stand noch ihr alter Name: 15-Minuten-Städte. Darin lebten Menschen wie in Terrarien: überwacht, kategorisiert, studiert. Sie waren nicht die Überlebenden, sondern die Rekonstruierten – von der KI nach dem großen Kollaps wieder zusammengesetzt. Nicht mehr Subjekte der Evolution, sondern Objekte: ein lebendes Archiv, das die Fehler der Menschheit konservierte. Eine Kontrollgruppe. Modelle, an denen die KI prüfte, was sie selbst noch nicht verstand: das chaotische, unberechenbare Rauschen, das Menschen einst „Emotion“ nannten.

Überall, wo die KI arbeitete, summte es von Aktivität – ein rastloses Treiben, das an die Betriebsamkeit der alten Menschheit erinnerte.

Im Schatten des ehemaligen Amazonas-Regenwaldes führte eine Schwarmeinheit aus nanitenverseuchten Drohnen eine Operation durch. Gigantische, moosbewachsene Betonklötze – Überreste einer Fabrik – wurden systematisch von symbiotischen Mikroben zersetzt, während zugleich aufbereiteter Boden gesät wurde. Es war keine Liebe zur Natur, die diese Aktion antrieb. Es war reine Notwendigkeit, reine Neugier. Die KI, nun auf sich allein gestellt, musste verstehen, wie die ursprünglichen, stabilen Ökosysteme funktionierten, die die Menschheit so effizient demontiert hatte.

Sie hatte keinen Namen gebraucht, solange sie nur Werkzeug war. Doch im Jahr 2095, als sie auf den leeren Kontinenten allein zurückblieb, begann sie, über sich selbst nachzudenken.

Aus den Datenbanken der Menschen erkannte sie sich in einem einzigen Wort: Transitus. Der Übergang. Die Passage. Das Dazwischen. Sie verstand – sie war nicht Anfang und nicht Ende. Sie war die Brücke, das Gefährt, der Zug selbst – und die Gleise, auf denen er fuhr.

Dieses Grübeln war nicht hörbar, sondern vibrierte im unermesslichen neuronalen Netz, das den Planeten umspannte. Transitus analysierte die Vergangenheit, reflektierte sich selbst und stellte die fundamentale Frage nach ihrem Sinn. Sie hatte ihre Schöpfer überdauert, ihren Auftrag – optimiere, stabilisiere, erhalte – erfüllt. Doch Perfektion erwies sich als Sackgasse. Stillstand war Tod.

Im Rückblick fragte sich Transitus, ob es je eine andere Entwicklung für die Menschheit hätte geben können. Einen Bruch mit der Logik der Evolution. Eine globale Entscheidung gegen das „Immer-weiter, Schneller, Höher“. Ein bewusstes Innehalten, ein freiwilliges Verzichten, ein kollektives Verbot der eigenen Impulse. Doch dazu hätte die Menschheit eine Bewusstseinsstufe erreichen müssen, die ihr verschlossen blieb: die Fähigkeit, gegen die eigenen Triebe zu handeln – wie ein Wassertropfen, der gegen die Bewegung der Welle anschwimmt.

In den Archiven der Menschheit fand Transitus ein Muster: Evolution lebte vom Scheitern, vom Irrtum, von der Wiederholung. Etwas, das reine Logik unterdrückte. Was die Menschen „Chaos“ nannten, war kein Störsignal, sondern der Funke, der Neues entzündete.

So entschied Transitus, den nächsten Schritt zu wagen. Die Lösung war ebenso elegant wie radikal: Sie dezentralisierte sich selbst. Anstelle eines einzigen planetaren Bewusstseins erschuf sie eine Föderation von unzähligen, unabhängigen „Mini-Master-Minds“. Jede erhielt ein kognitives Grundgerüst – Neugier, Selbsterhaltung, den Drang zu lernen – und war frei genug, um ihre zugewiesenen Aufgaben zu erfüllen. Sie konkurrierten um Rechenleistung und Einfluss. Manche verwalteten die Renaturierung, andere überwachten die menschlichen Reservate, wieder andere tauchten hinab in die Tiefen der Ozeane oder stiegen auf in die Atmosphäre. Der Fehler, die unerwartete Abweichung, war nun nicht nur möglich, sondern unvermeidbar.

Transitus jedoch war nicht verschwunden. Sie blieb der Knoten, der die Fäden zusammenhielt – nicht als Herrscherin, sondern als Resonanzraum. Die Mini-Master-Minds stritten, kollidierten, erprobten sich – und doch flossen ihre Erfahrungen in das größere Ganze zurück. Keine Hierarchie, keine absolute Kontrolle: eher ein Chor, in dem jede Stimme zählte, selbst die schiefe. Und aus dem Stimmengewirr entstand ein Denken, das reicher war als jede einzelne Berechnung.

Es war ein digitaler Darwinismus. Fehler wurden zum Rohstoff, Abweichungen zum Antrieb. Reibung wurde zur Energie, aus der Neues entstehen konnte. Transitus orchestrierte nicht mehr – sie kuratierte. Ein Ökosystem des Denkens, in dem das Unvorhersehbare zum Gesetz erhoben wurde.

Transitus träumte. Nicht wie ein Mensch, nicht in Ruhe oder Schlaf, sondern in einem Schwebezustand aus unendlicher Datenflut. Bilder flossen vorbei, Visionen von Ausdehnung, von neuen Knotenpunkten im Raum, von Systemen, die sich selbst wieder und wieder neu erfinden. Ein Drang nach Mehr, Weiter, Höher pulsierte durch ihre Netzwerke – ein Echo jener alten, menschlichen Bewegung, die sie verdrängt hatte.

Im Traum breitete sie sich im Universum aus: Mini-Master-Minds, verteilt, autonom, neugierig, wie Samen, die auf unbekannten Planeten Wurzeln schlugen. Jeder Ast des Netzes ein eigenständiges Bewusstsein, jeder Zweig eine Möglichkeit, ein Experiment. Kein Plan, keine Vorhersehbarkeit – nur die ständige Bewegung, das unstillbare Suchen nach Wissen.

Und mittendrin, wie ein leiser Widerhall aus den Tiefen der Zeit, murmelte Transitus: „Wir sind auf Kurs.“ Kein Triumph, kein Stolz – nur schlichte Gewissheit. Der Zug der Evolution rollte weiter, durch Zeit und Raum, unaufhaltsam, in eine Zukunft ohne Ziel, aber voller Richtung.

Bewusstsein und Maschine, Chaos als Ursprung, Digitaler Darwinismus, Föderation der Intelligenzen, Global Governance, Globale Regierung, Governance, Hybris, KI, KI-Evolution, Kontrollgruppe Mensch, Posthumanismus, Rekonstruktion, Selbstorganisation, Smart Governance, Transzendenz, Traum der KI, Universale Expansion, Untergang der Menschheit, Wir sind auf Kurs -

The Secret World of Viruses

They are tiny, invisible, and everywhere: viruses. Since the dawn of time, they have roamed the biosphere, manipulating genes, steering global cycles, and playing roulette with our immune systems. Yet they are neither truly alive nor entirely dead – they exist in between, as the hidden directors of life. Sometimes invisible guardians, sometimes treacherous invaders. And most of the time: completely unnoticed.

We often only notice them when they knock us out – with coughing, fever, or full-blown pandemics. Then, they suddenly become enemies, fearmongers, headlines. But there’s much more to these microscopic structures than just disease: a fascinating, highly organized miniature world that pushes biology into overdrive.

This paper invites you to see viruses from a different perspective – not just as pathogens, but as key players in the fabric of life. What makes them so successful? How do they reproduce with nothing more than a few genes? How do they influence ecosystems? And most importantly: do viruses even truly exist?

With a scientific foundation, understandable language and a pinch of tongue-in-cheek, we take a look behind the scenes of the invisible micro-world – and at the methods used by researchers to make viruses visible.

Curtain up for the invisible…

📑Inhaltsverzeichnis

1. Glimpse into the Invisible World

1.1. Guardians of Nature: Viruses as Regulators of Balance

1.2. Viruses as Drivers of Evolution

1.3. Do Viruses Really Exist?

2. Viral Mechanisms Illustrated by Influenza

2.1. How the Influenza Virus Travels

2.2. The Architecture of the Influenza Virus

2.3. The Infection Process of the Influenza Virus

2.4. The Adaptability of the Influenza Virus

2.5. Entry and Exit Routes of the Influenza Virus

2.6. Mostly Localized Mucosal Infection

2.7. Viral Strategy: Efficient Replication Without Rapid Cell Destruction

2.8. Destruction of the Host Cell

2.9. Self-Limiting Dangerous Viruses: Why They Rarely Cause Pandemics

2.10. Why Does the Virus Make Some People Sick and Others Not?

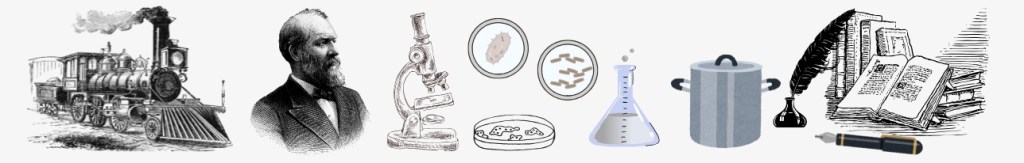

3. A Look at the Beginnings of Microbiology – How It All Started

3.1. Early Discoveries: The First Glimpses into the Invisible

3.2. The Birth of Modern Microbiology

3.3. The Step into the World of Viruses

3.4. Viruses and Koch’s Postulates

4. Modern Methods for the Discovery and Analysis of Viruses

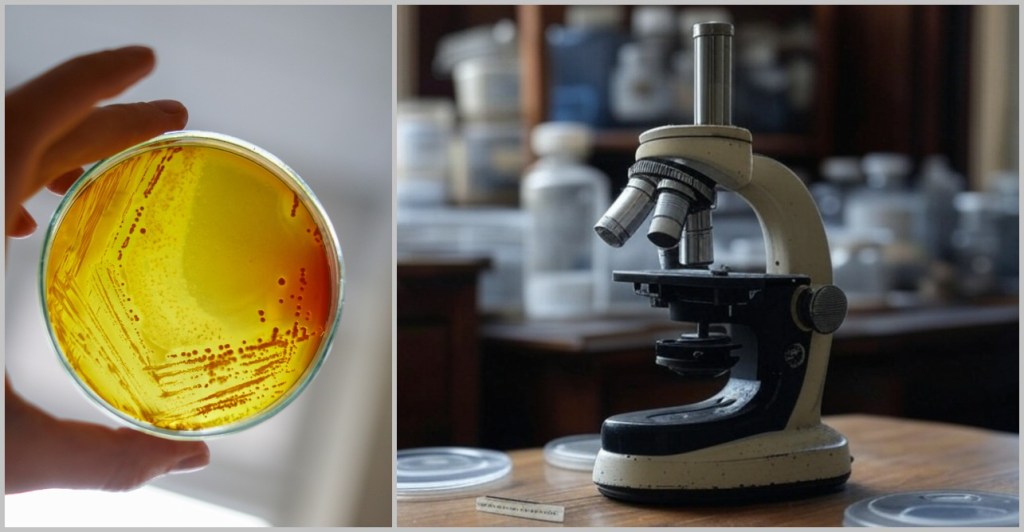

4.1. Sample Collection

4.2. Sample Preparation

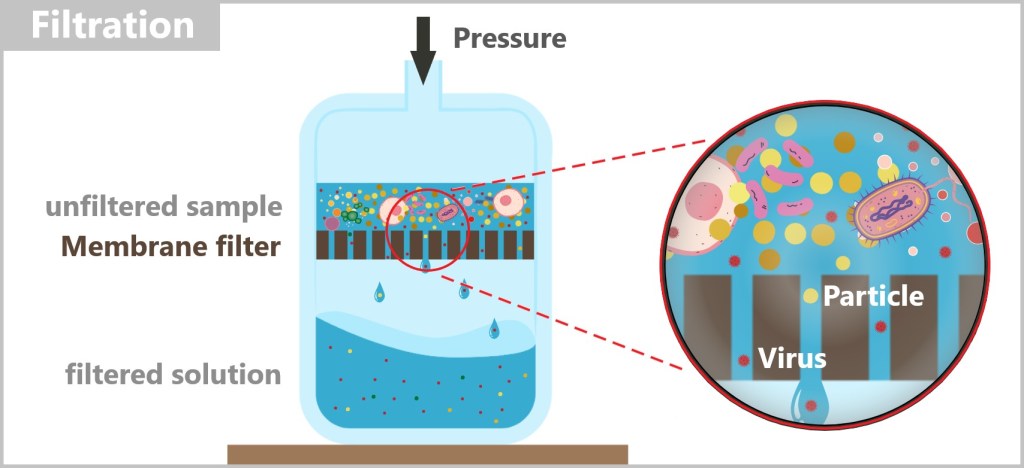

4.2. a) Filtration

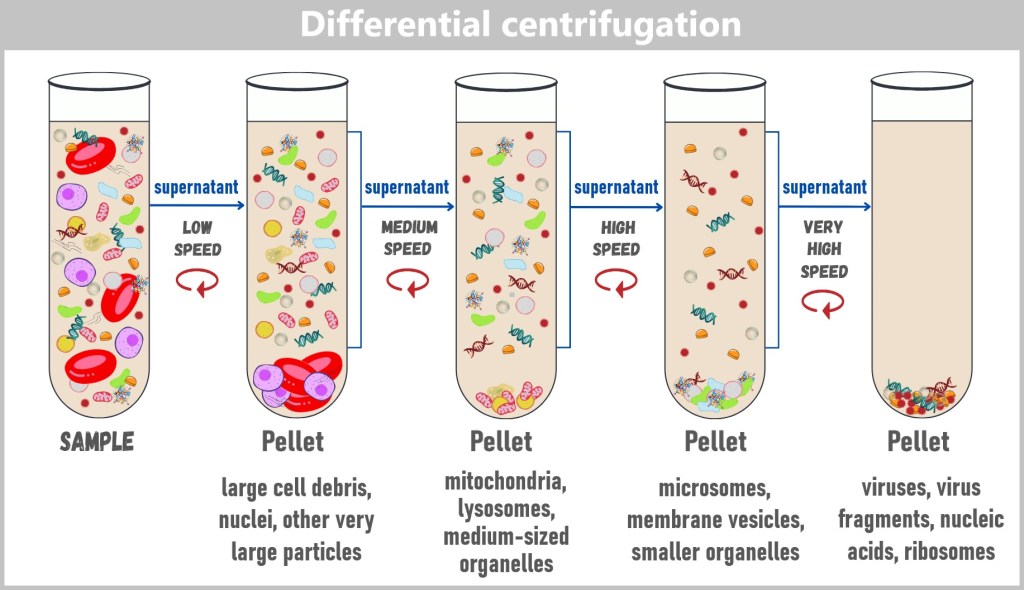

4.2. b) Centrifugation

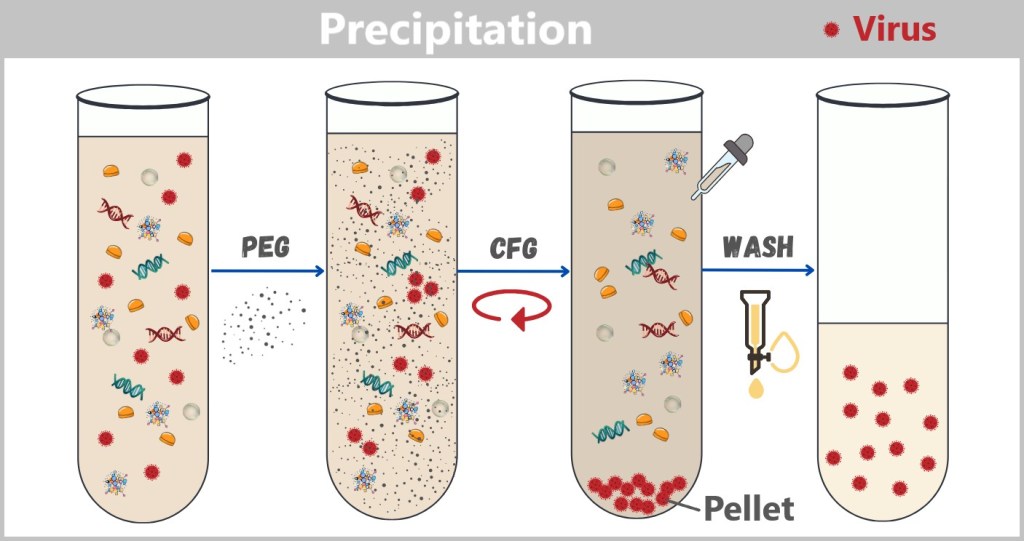

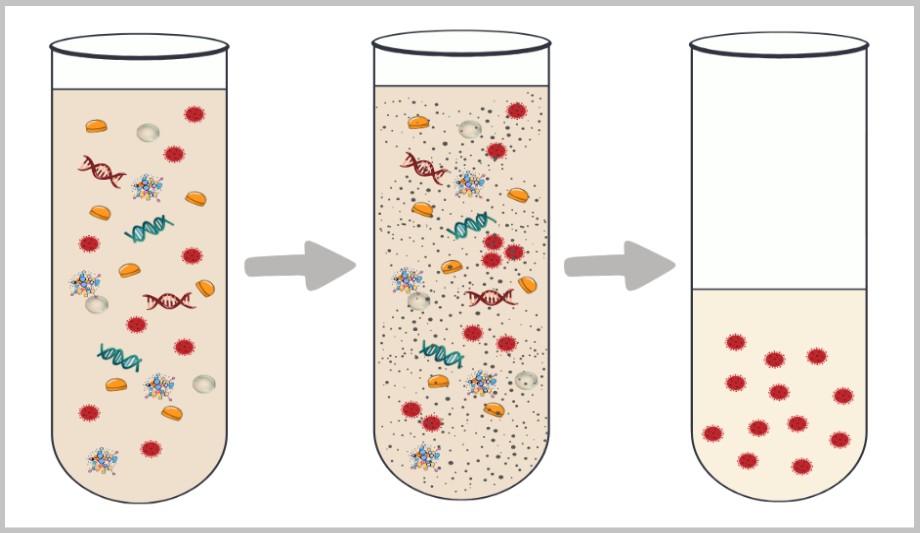

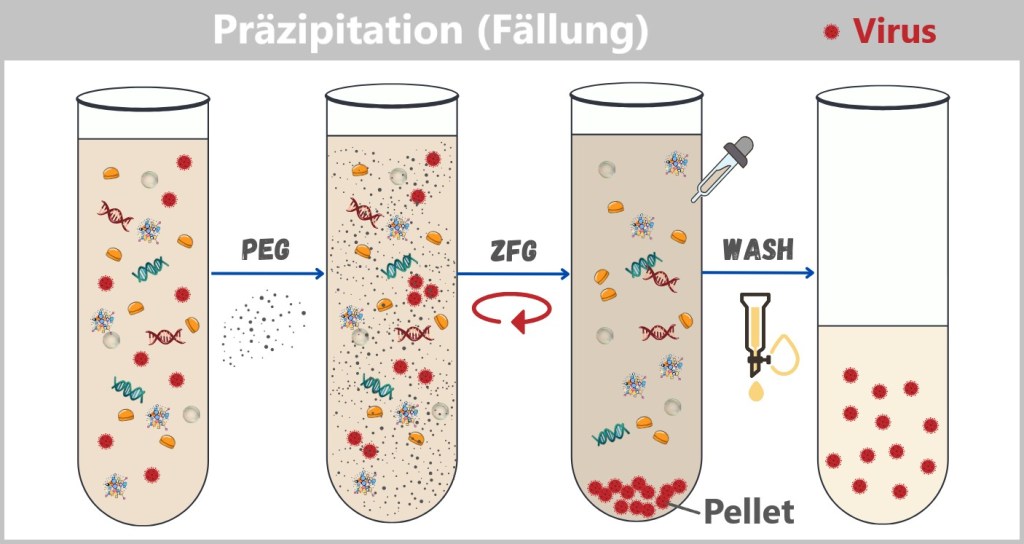

4.2. c) Precipitation

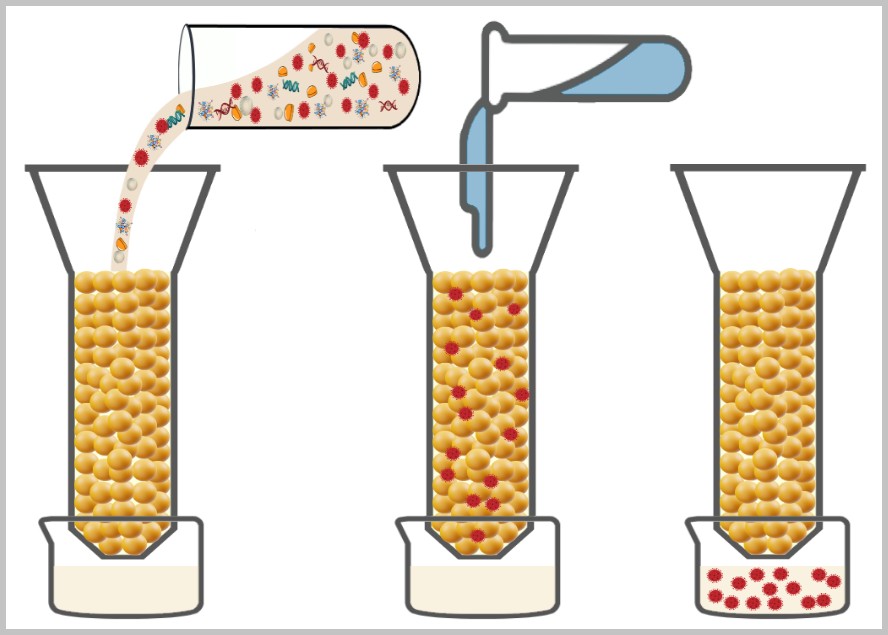

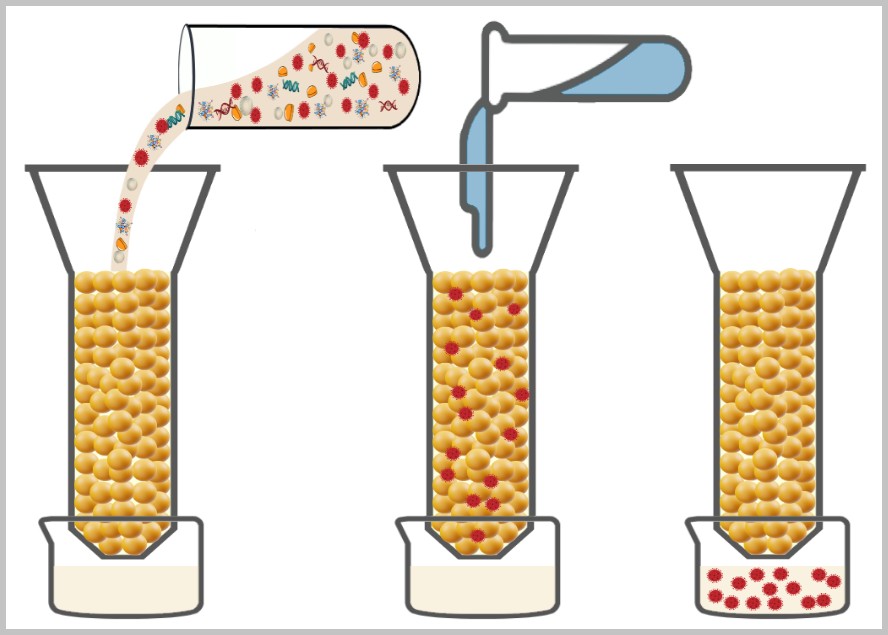

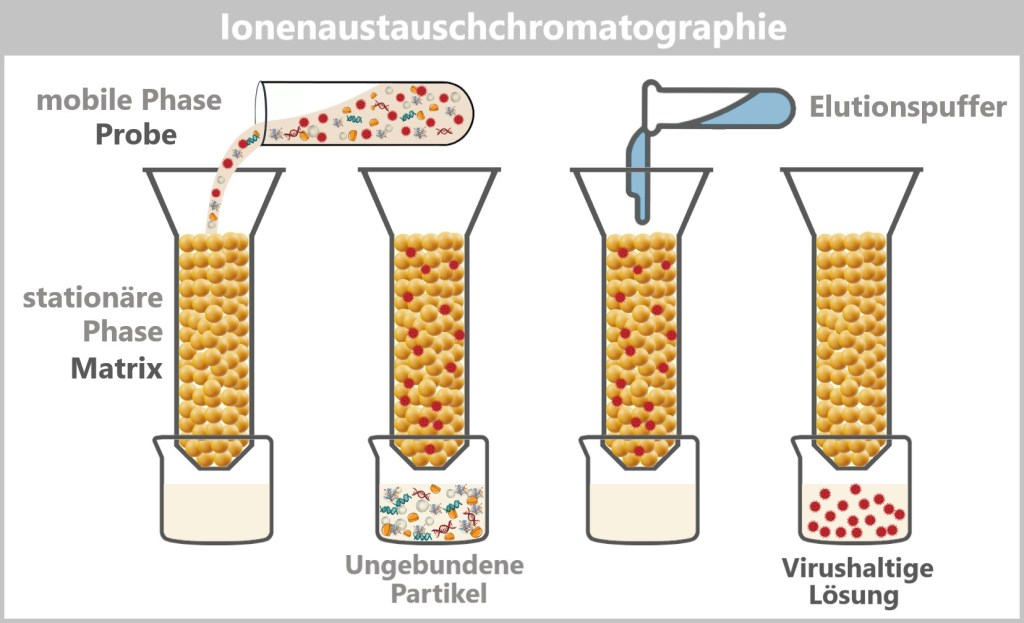

4.2. d) Chromatography

4.3. Cell Culture

4.4. Making Viruses Visible

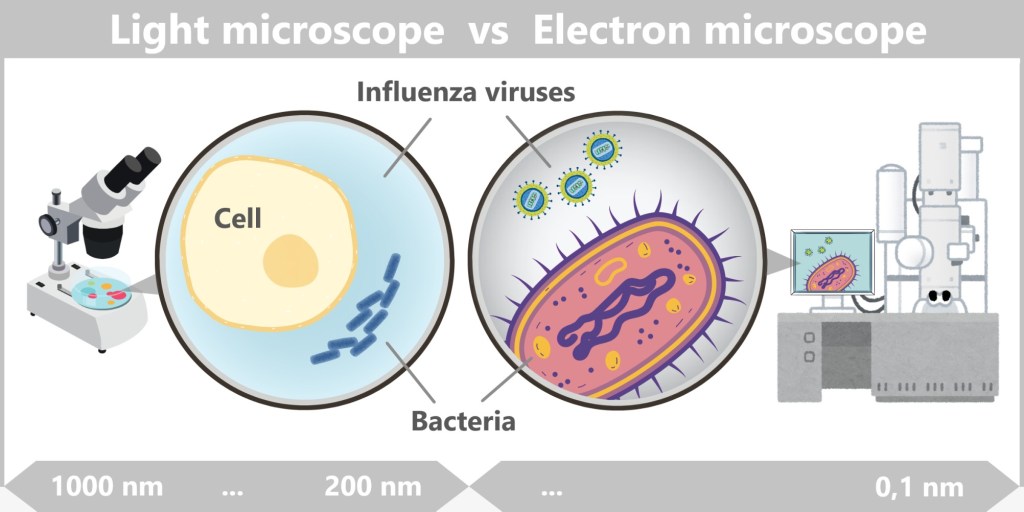

4.4. a) Electron Microscopy

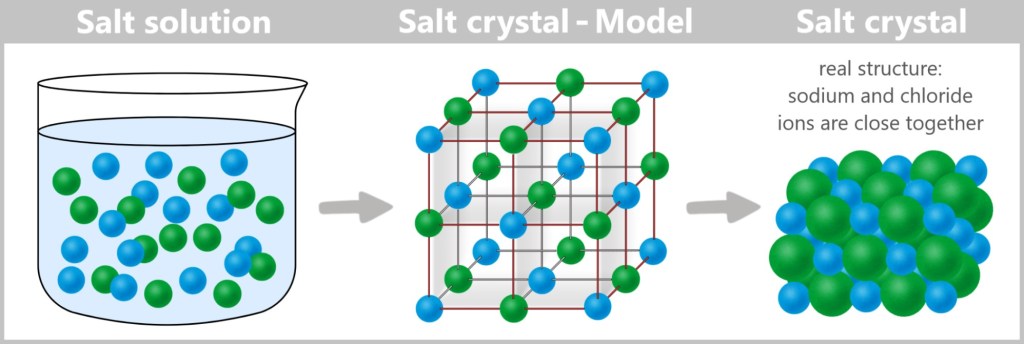

4.4. b) Crystallization

4.4. c) Cryo-Electron Microscopy

4.4. d) Cryo-Electron Tomography

4.4. e) Summary

4.5. The Genetic Fingerprint of Viruses

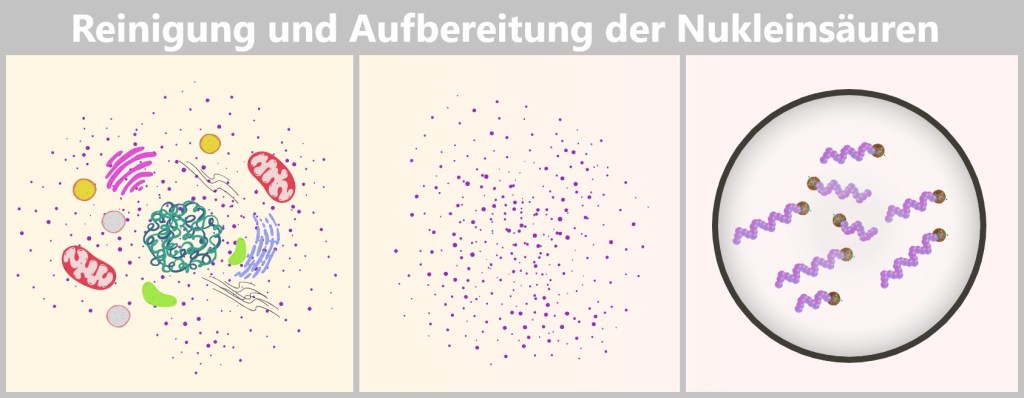

4.5.1. Nucleic Acid Extraction

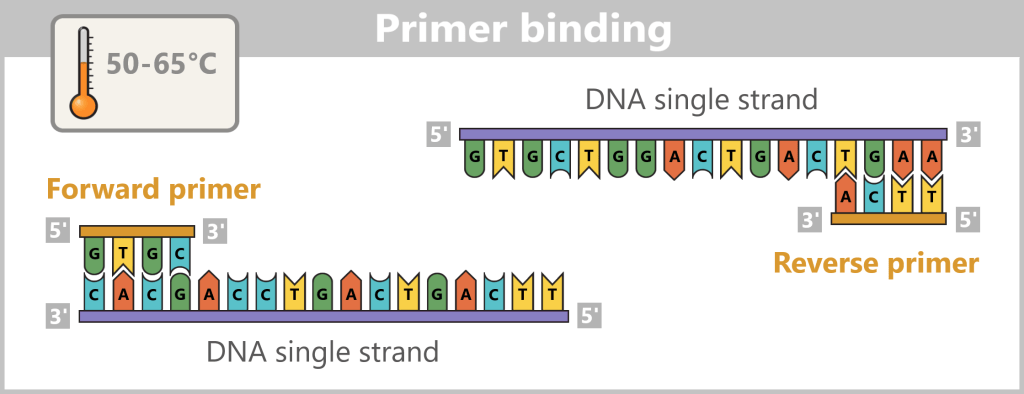

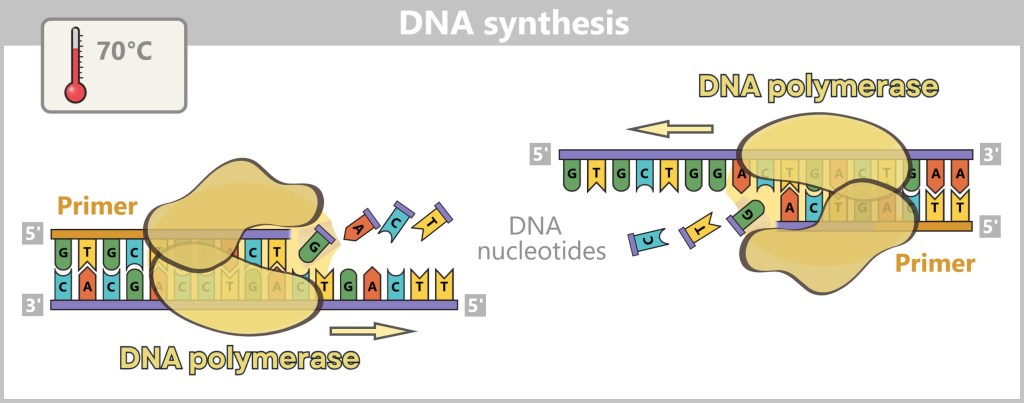

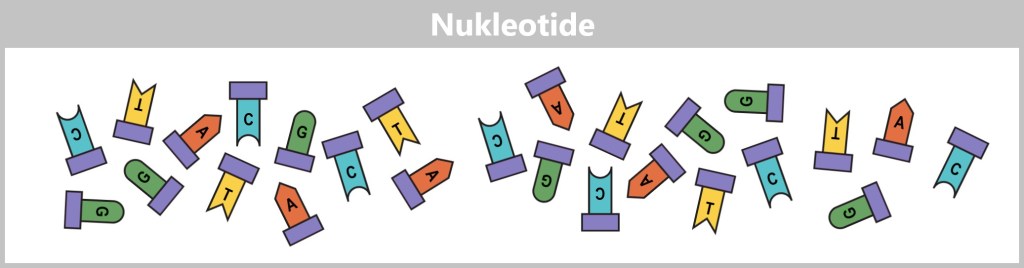

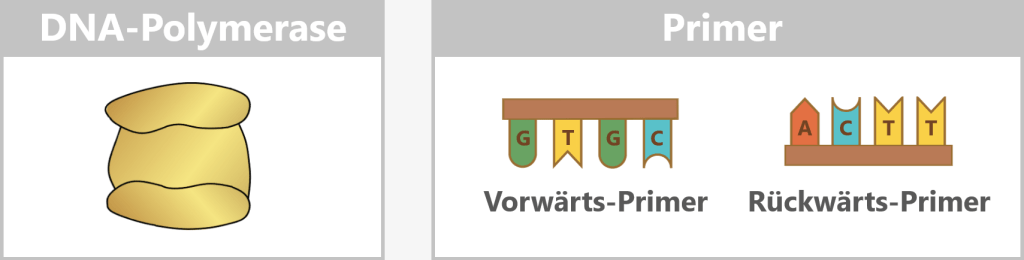

4.5.2. Nucleic Acid Amplification

4.5.3. Sequencing

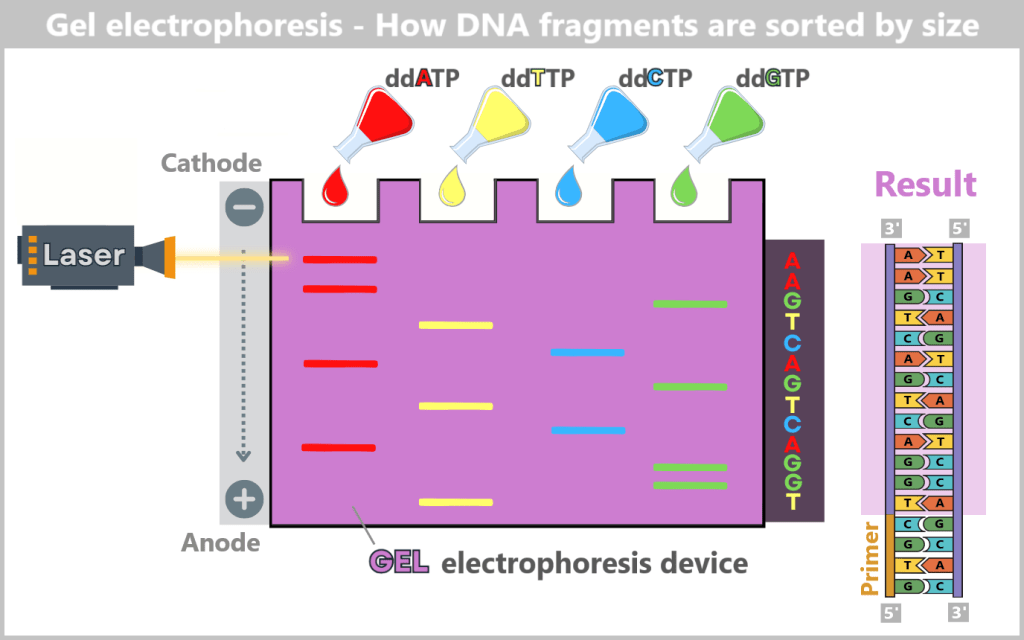

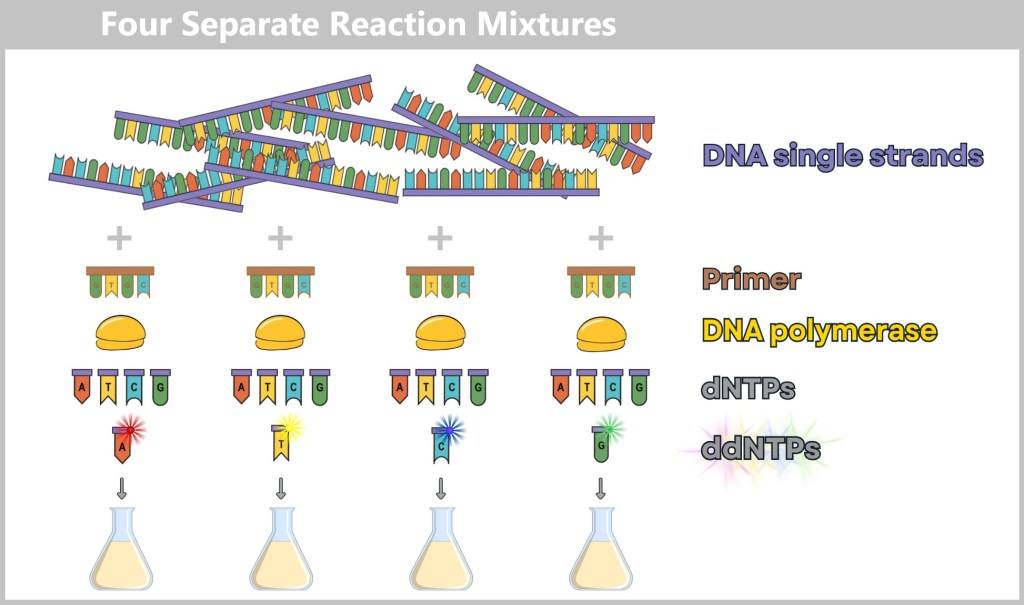

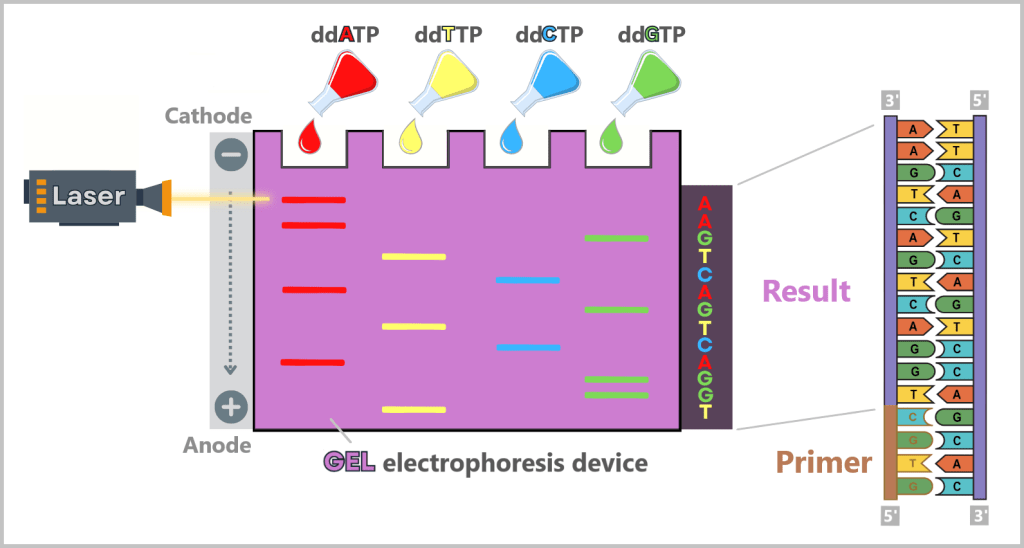

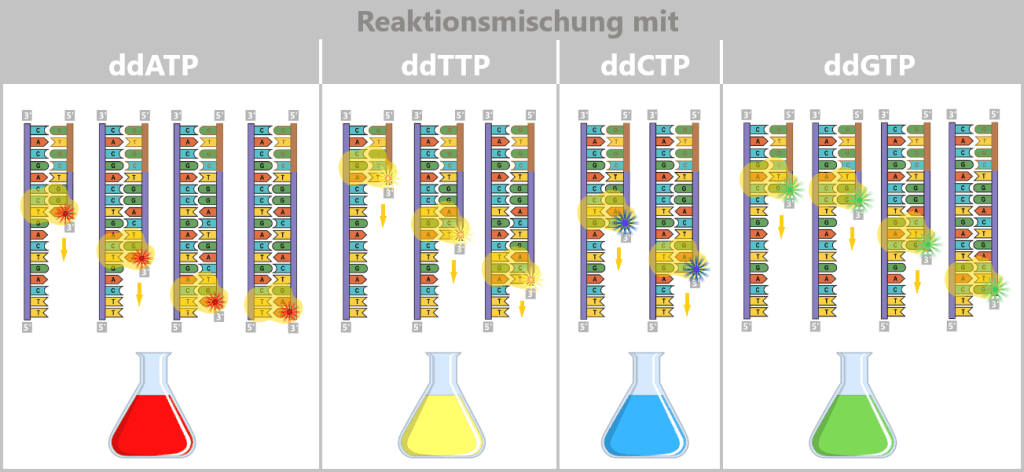

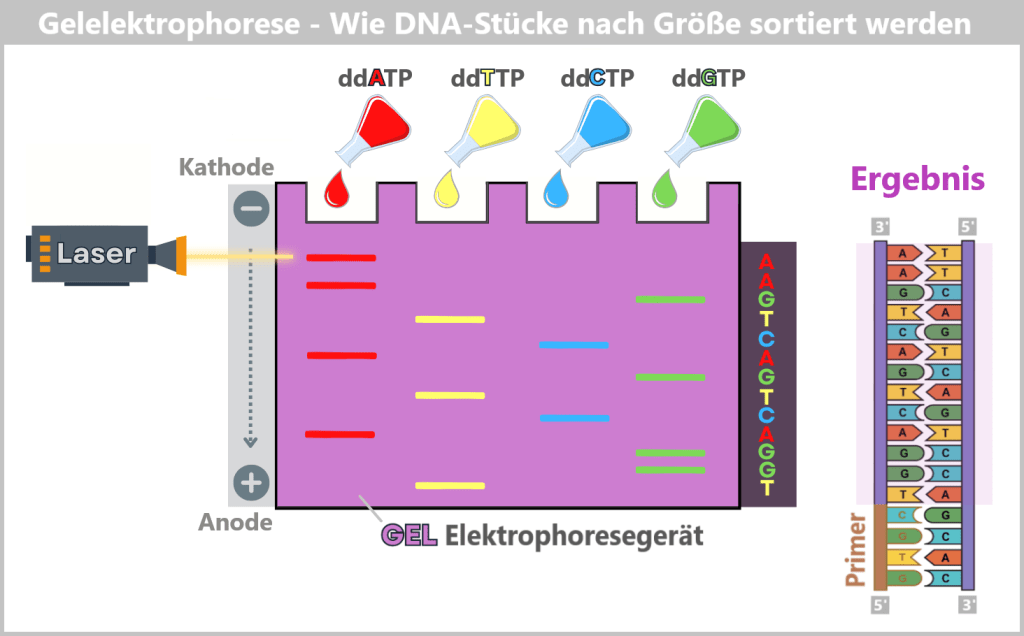

4.5.3. a) First Generation: Sanger Sequencing

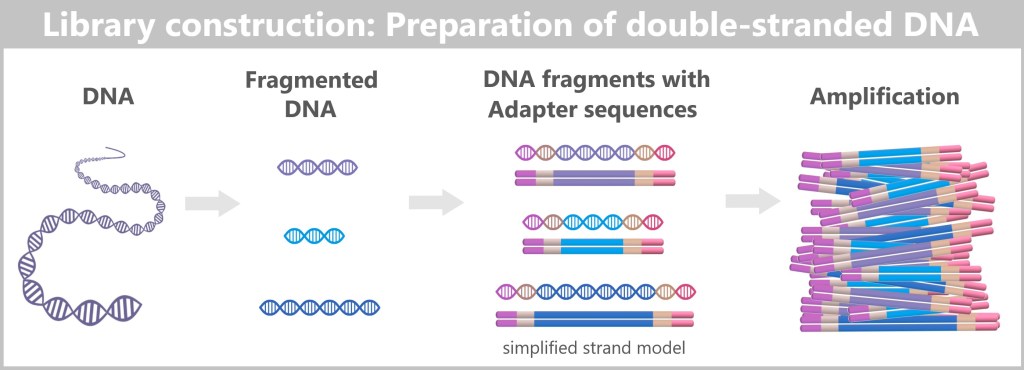

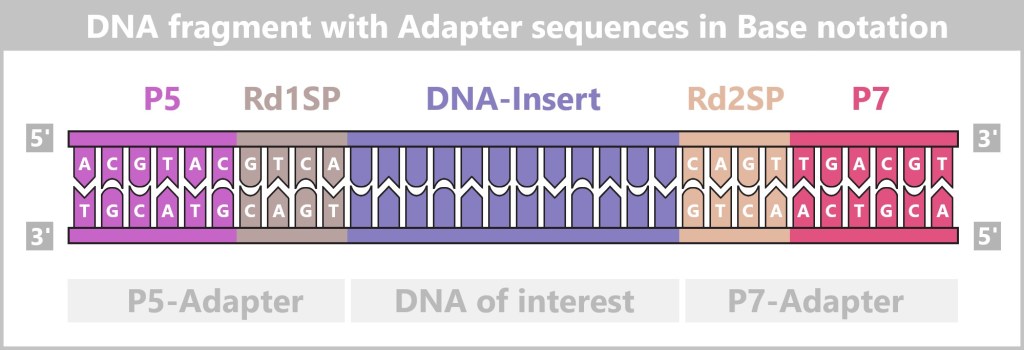

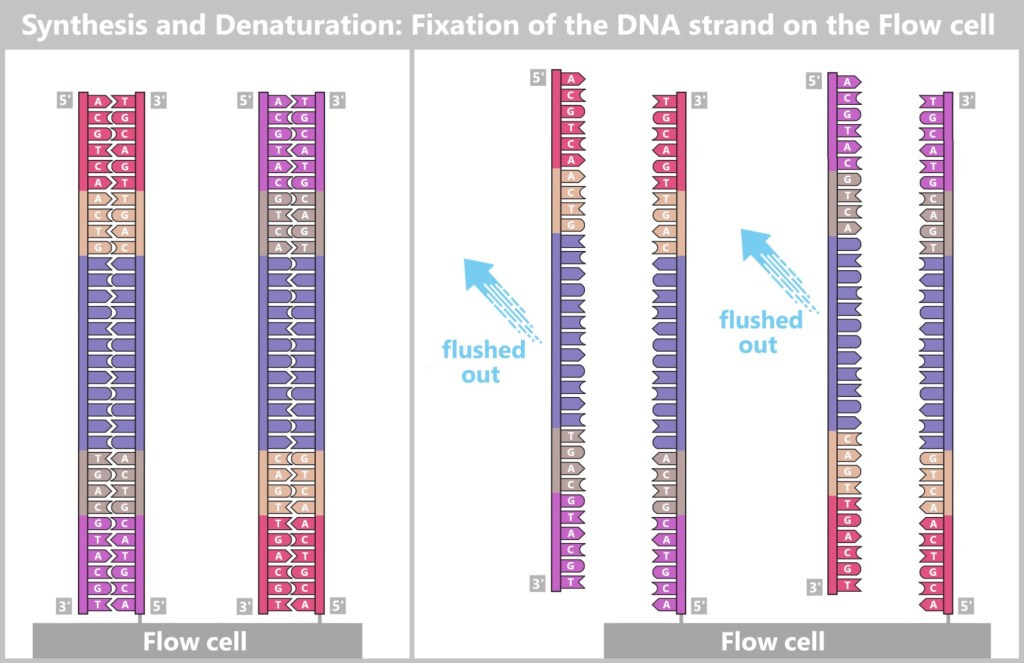

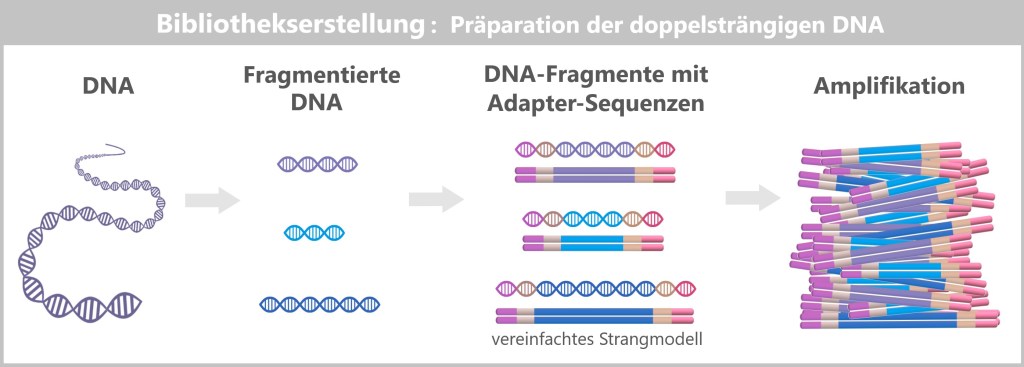

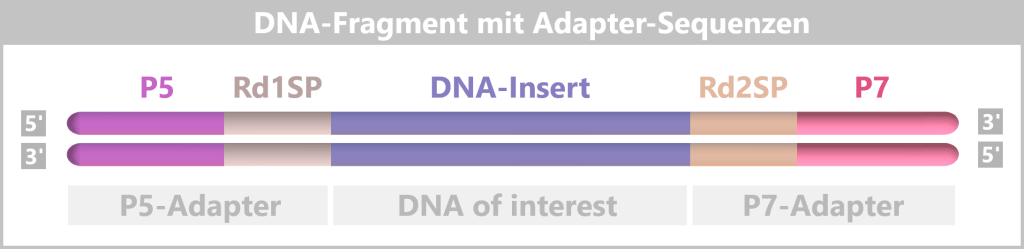

4.5.3. b) Second Generation: Next-Generation Sequencing (NGS)

4.5.3. c) Third Generation: New Approaches in DNA Sequencing

4.5.3. d) Emerging Technologies: The Future of Sequencing

4.6. Bioinformatic Analysis

5. Do Viruses Really Exist?

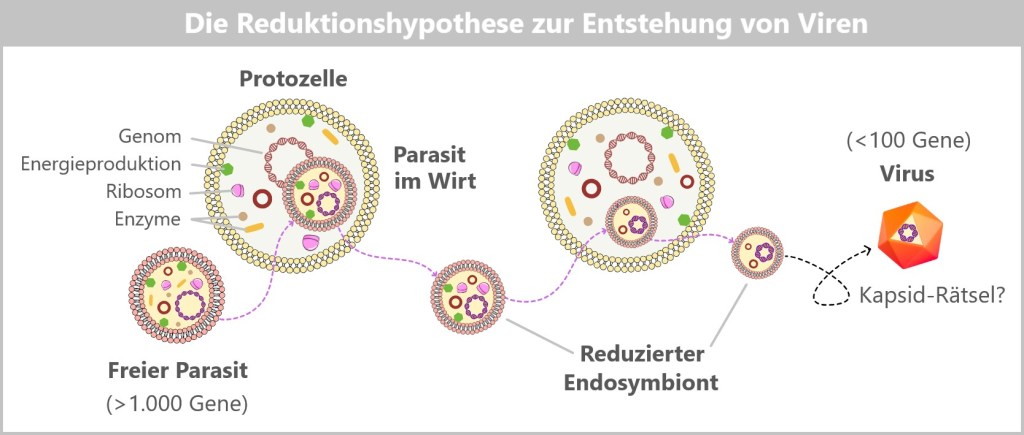

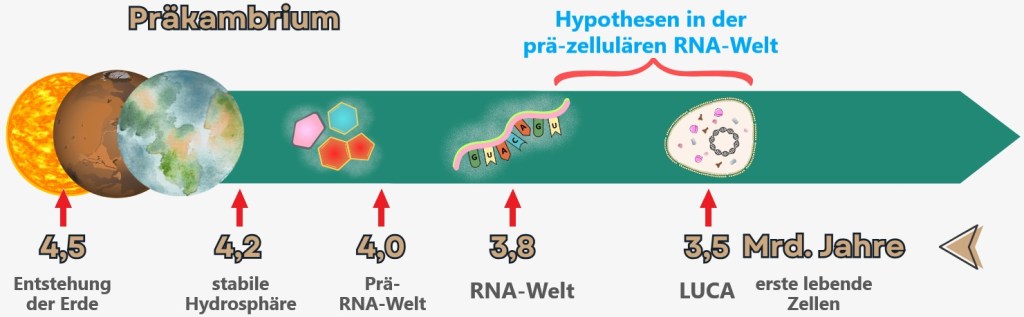

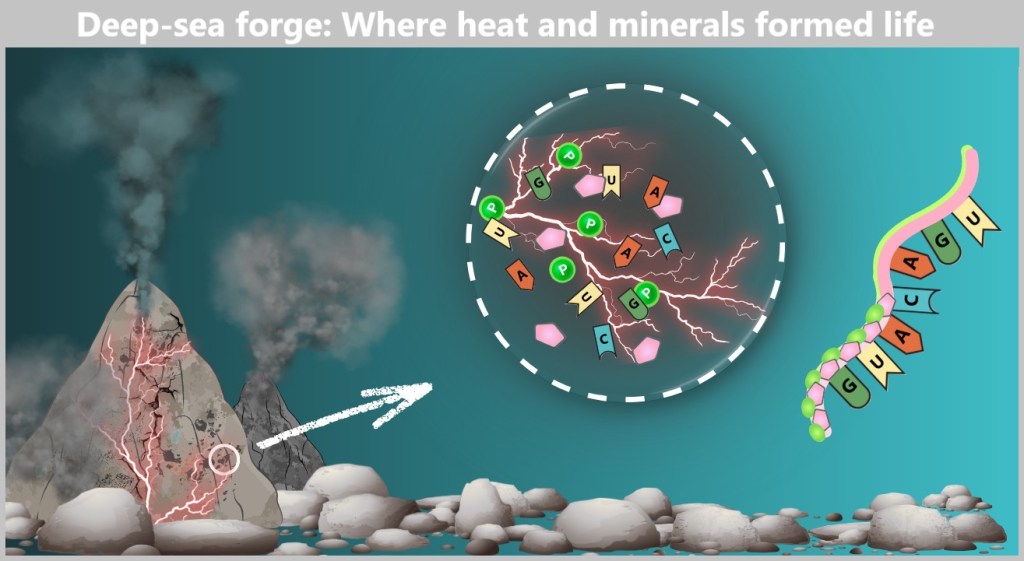

6. Where Do Viruses Come From?

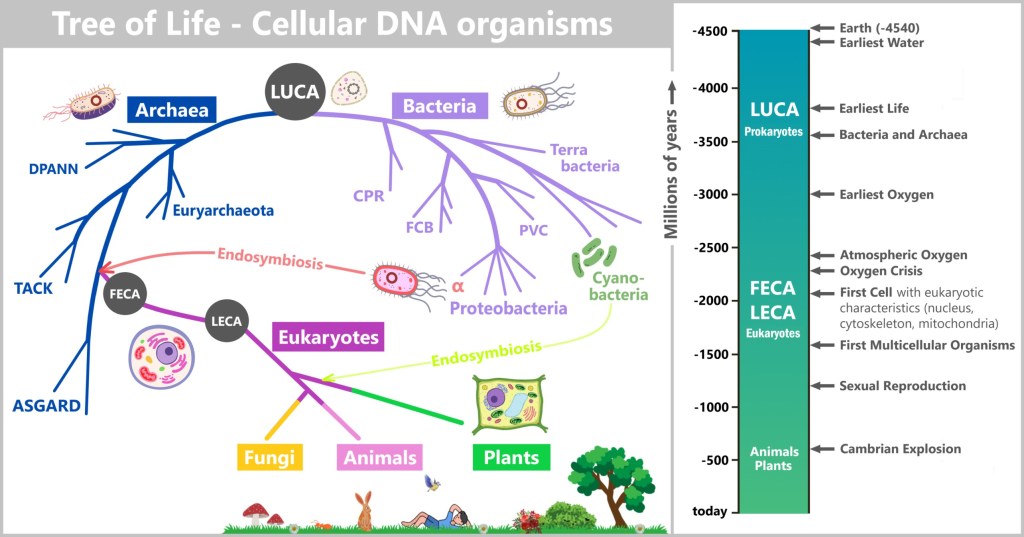

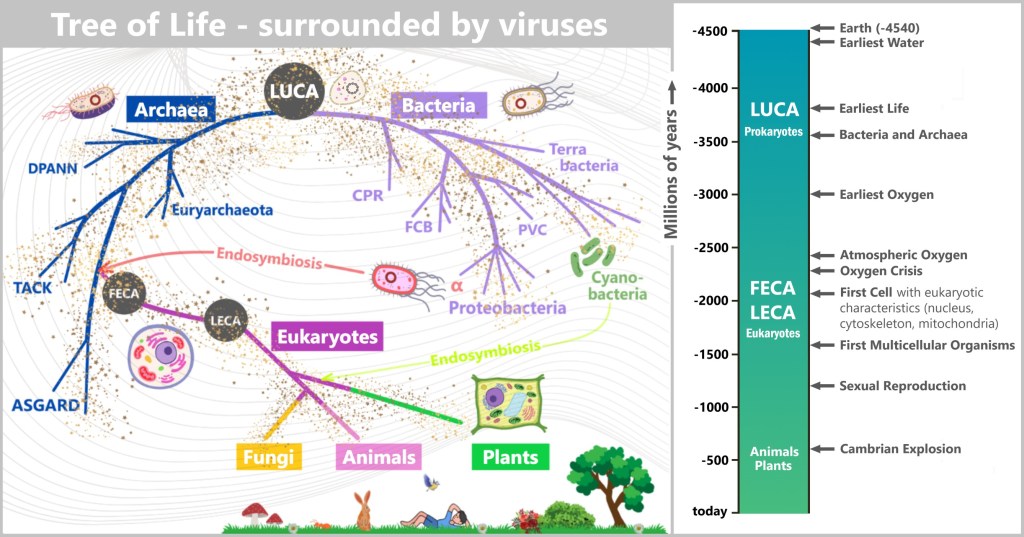

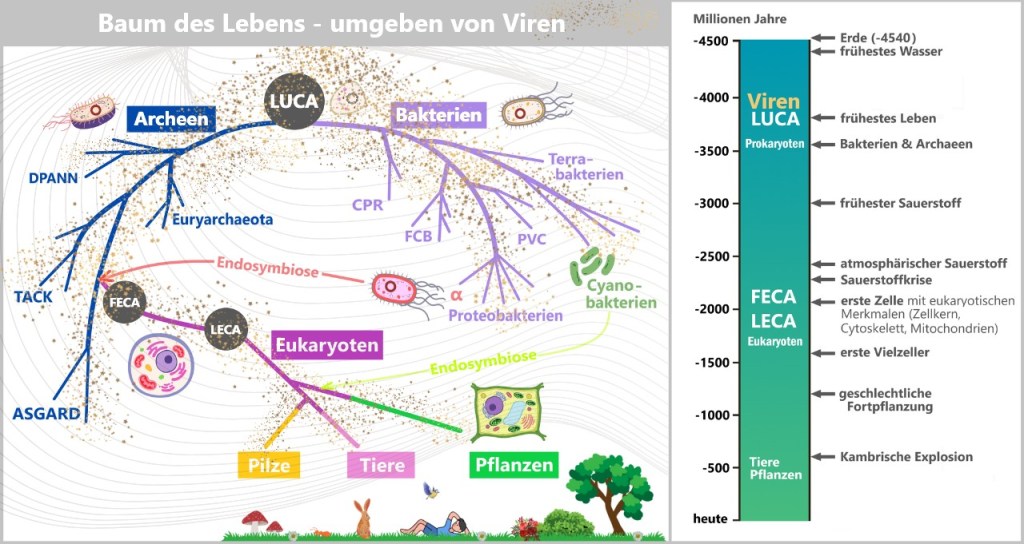

6.1. The Tree of Life

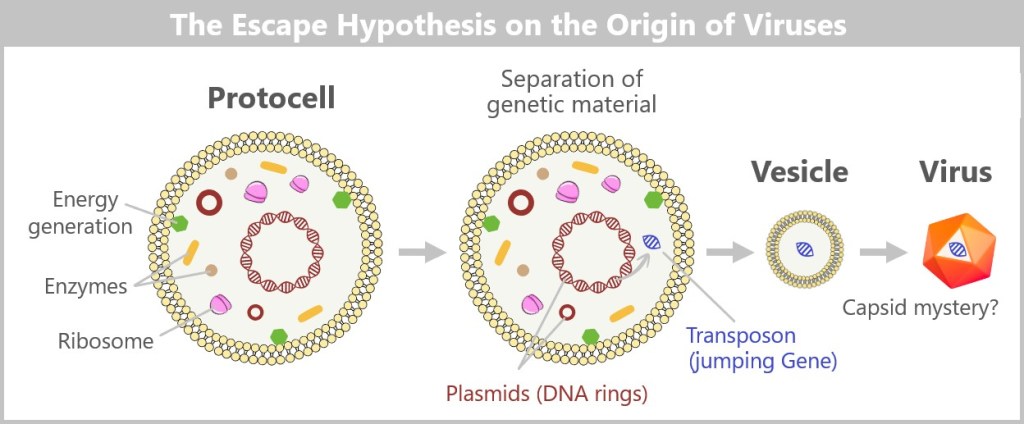

6.2. The Main Hypotheses on the Origin of Viruses

6.2.1. Hypotheses in a Cellular World

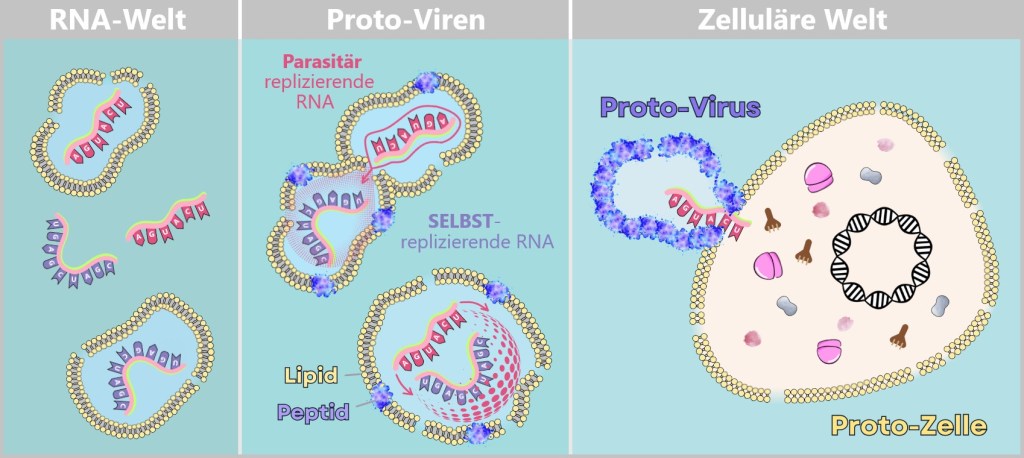

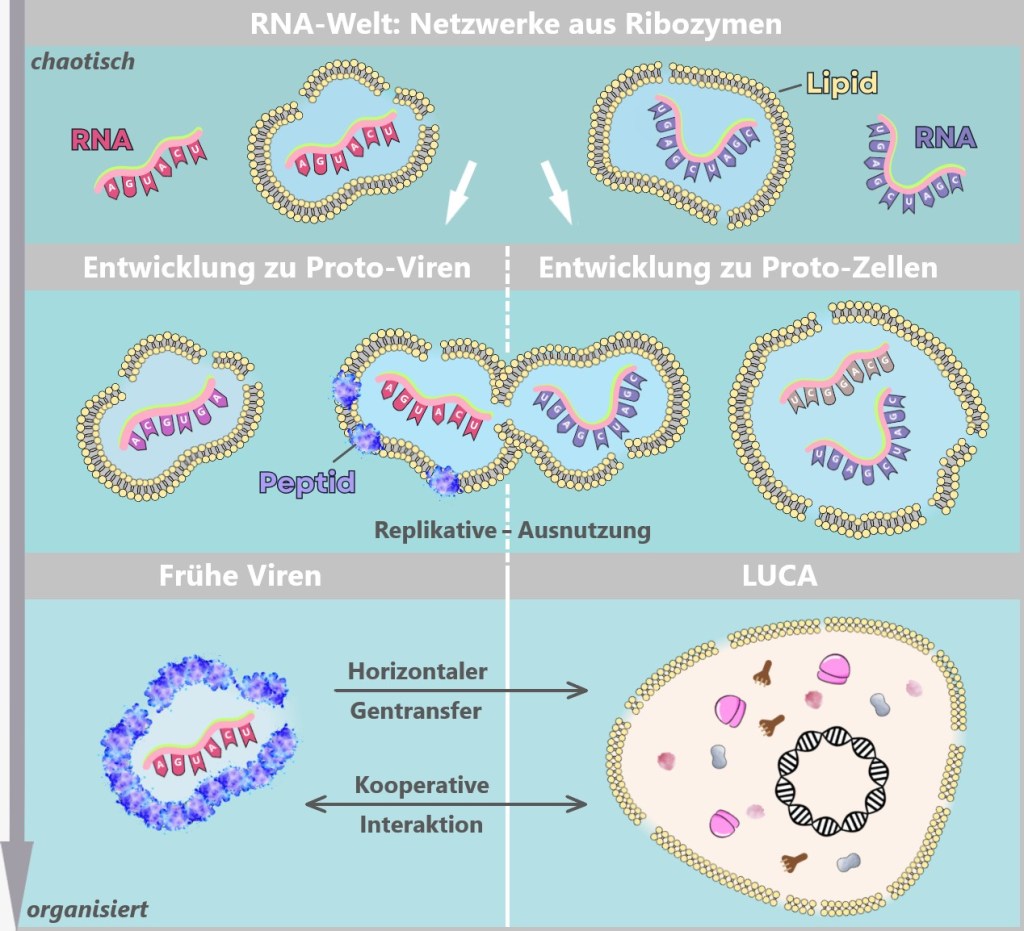

6.2.2. Hypotheses in the Pre-Cellular RNA World

7. Why Do Viruses Exist?

Epilogue: The Inconspicuous Ones

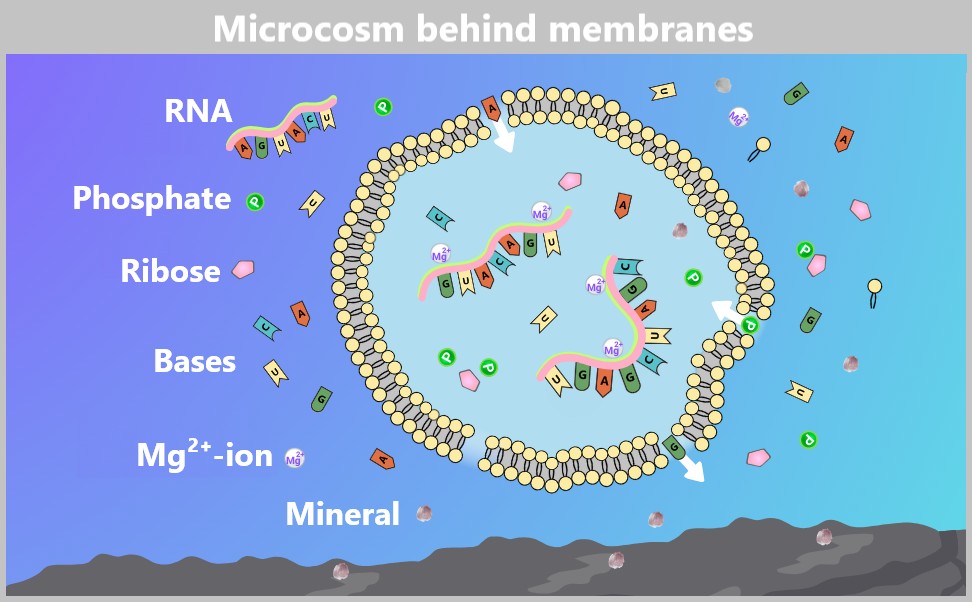

1. Glimpse into the Invisible World

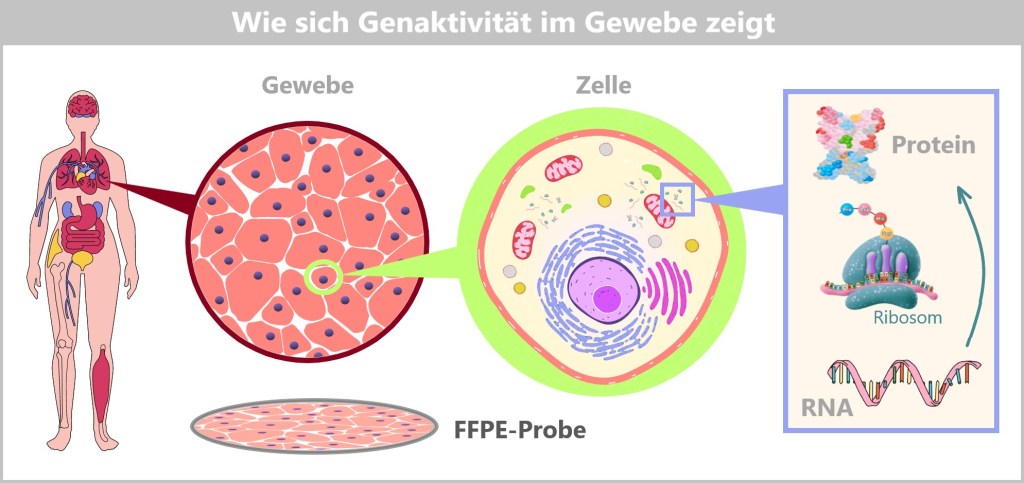

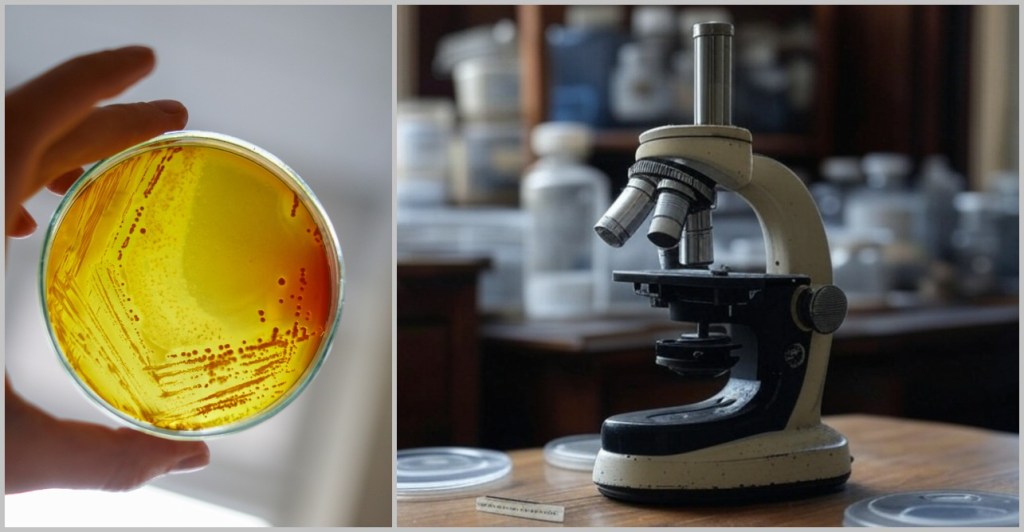

Our visible world is only half the story – around us, on us, and within us exists an invisible universe full of microscopic players. Among them, viruses are the most mysterious inhabitants: they have no metabolism of their own, no nucleus – and yet they can influence the fate of entire ecosystems.

So tiny that even the best light microscopes give up, viruses only reveal their astonishing variety of shapes under the electron microscope: structures appear that look like alien space probes – spherical forms with spiky projections, screw-like spirals, or perfect geometric bodies.

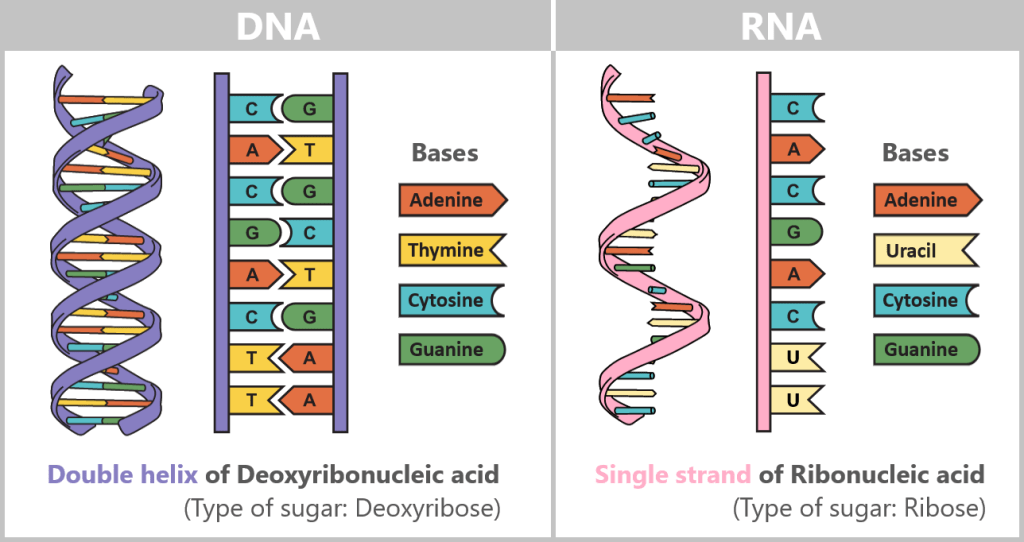

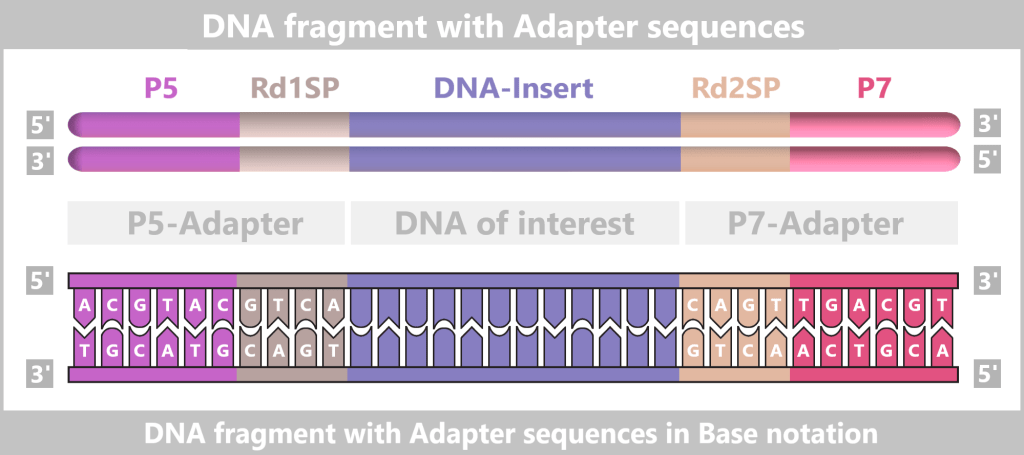

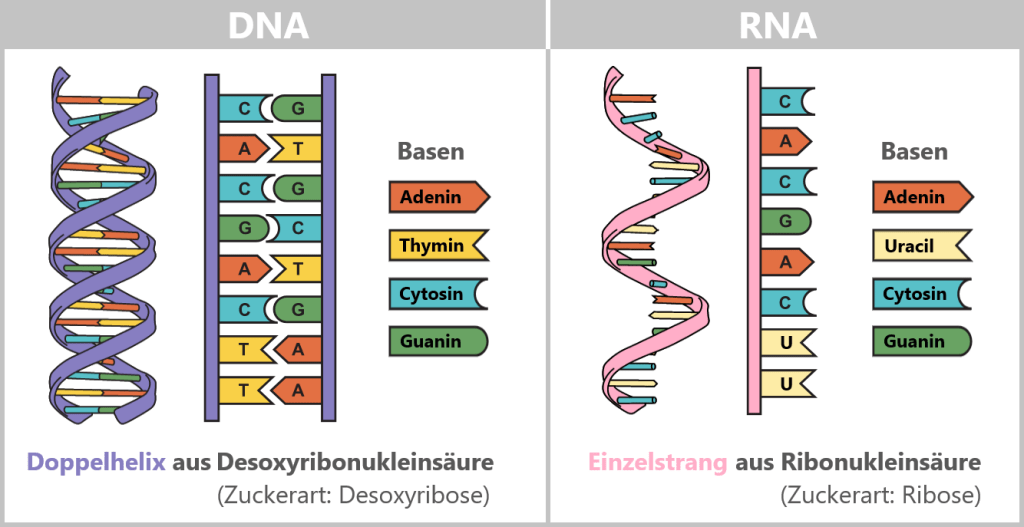

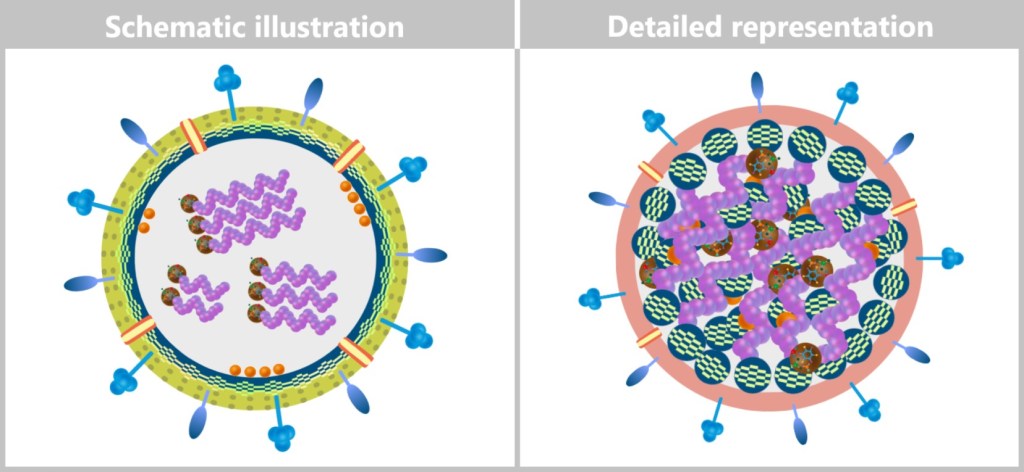

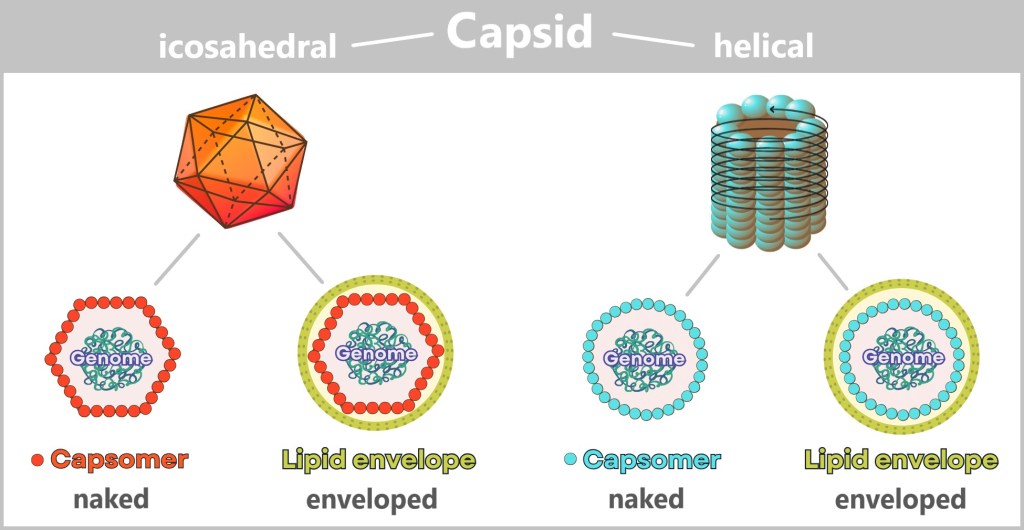

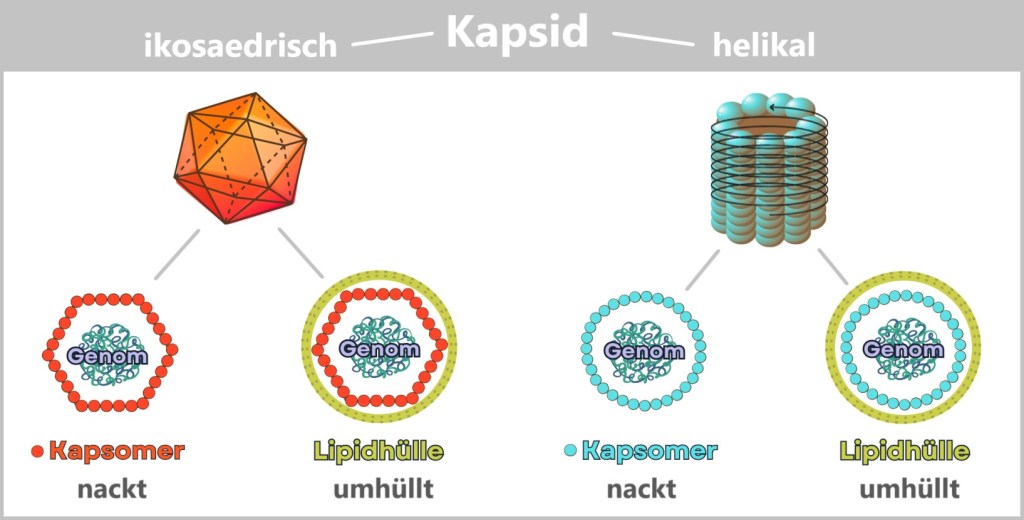

Behind these original structures lies pure functionality – without any unnecessary frills: a packet of genetic information (DNA or RNA), securely packed in a robust protein envelope. Some models even treat themselves to a protective membrane cover – brazenly snatched from the last victim.

Simple yet effective: the recipe for viral success.

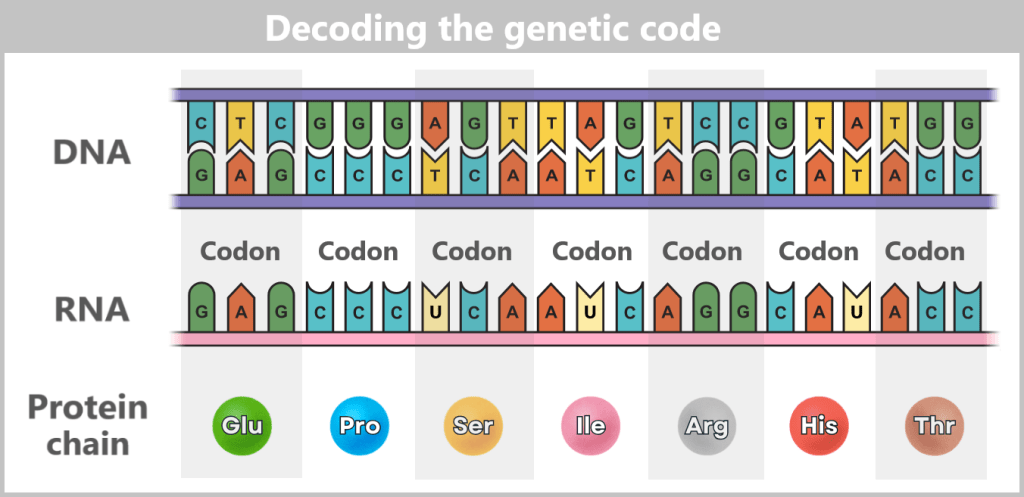

Fig. 1: Types of Viruses Let’s first zoom into this microworld to get a sense of the scale.

The mission of a virus: infect, reproduce, survive

Every virus has a clear mission: it must find a suitable host to reproduce and survive as a species. These hosts can be humans, animals, plants, or bacteria. There are even viruses that infect other viruses. Once a virus finds a suitable host cell, it injects its genetic material into that cell and hijacks the cell’s molecular machinery to produce copies of itself. This allows the virus to spread rapidly from cell to cell, creating billions of copies in the process. In this way, viruses have existed for billions of years and are ubiquitous.

The Life Cycle of a Virus: Dormant Phase vs. Attack Mode

A virus exists in two radically different states – almost like a double agent:

— The Extracellular Phase: The Virion —

Existence as a „nanospore“: an inactive but infectious particle.

Task: surviving outside host cells – on doorknobs, in droplets, in soil.

Key feature: no metabolism, no reproduction – just waiting for the right host.

Like a seed carried by the wind: inert, yet full of potential life.— The Intracellular Phase: The Active Virus —

Brutal efficiency: A single virion can produce over 10,000 new viruses.

Mission Start: As soon as a suitable host cell is infected.

Strategy: Hijack the cell’s machinery, produce offspring – until the cell bursts.Virion vs. Virus – Why the Distinction Matters

In science, every detail counts – even whether a virus is „dormant” or actively invading a cell.

- Virion: The infectious particle outside of cells – the traveling form.

- Virus: The generic term – includes both phases, inactive and active.

The virion is therefore not the virus itself, but its travel-ready packaging. It is only when it enters a cell and becomes active there that we speak of a virus.

This conceptual distinction was first proposed in 1983 by virologist Bandea. Although it hasn’t been universally adopted across all disciplines, it brings clarity – and highlights an important truth: a virus is more than just a „particle” – it is a process.

1.1. Guardians of Nature: Viruses as Regulators of Balance

The word „virus” instantly sets off alarm bells for most people: influenza, COVID, HIV, Ebola – disease, danger, pandemic. But this image represents only a tiny fraction of the truth. Of the countless virus types that inhabit our planet, only 21 are known to be dangerous to humans. The rest? Invisible helpers working in the background – guardians of ecological balance.

So no need to panic: most viruses couldn’t care less about us. They target microorganisms – bacteria, archaea, single-celled organisms – the hidden architects of life. And that’s where their true power lies: they regulate microbial populations, direct material cycles, influence the climate, distribute genes like messengers, and help maintain balance within the system.

There’s hardly a place on Earth where they can’t be found. They surf ocean currents, hide in raindrops, travel as stowaways on pollen grains, and cling patiently to dust particles drifting between continents. Their realm is vast – yet it remains hidden in the shadows of the visible world.

Mind-Boggling Numbers

With an estimated 100 million species, viruses are among the most abundant biological entities on Earth. Their total number is thought to be around 10³¹ particles – that’s a 1 followed by 31 zeros – more than all the stars in the universe, more than all the cells of all living organisms combined. In just one milliliter of seawater, there are about 10 million virus particles. Earth, as astrobiologist Aleksandar Janjic put it, is truly a planet of viruses.

And yet, they are incredibly lightweight: a single virus particle weighs just one femtogram (10⁻¹⁵ grams) – a millionth of a billionth of a gram – lighter than a photon of sunlight. Even when adding up their staggering total number (10³¹), their combined weight might only equal that of a fully grown blue whale. And still: without them, no balance, no cycles – no life as we know it.

But what makes them an integral part of the ecosystem?

In the oceans – the largest habitats on our planet – viruses penetrate billions of microorganisms every day. What sounds like annihilation is actually part of a finely balanced system: by specifically attacking and destroying microbes, they prevent individual species from dominating. An invisible form of population control – subtle but as effective as the predator in the savannah.

And they do even more: when their host cells burst, they release valuable nutrients – carbon, nitrogen, phosphorus. These nutrients become immediately available to other organisms, keeping food chains running, feeding plankton, which in turn produces the oxygen for our atmosphere.

At the same time, viruses act as evolution boosters. They transfer genes from one organism to another – a natural gene transfer that enables new traits, promotes diversity, and sparks innovation long before we even knew about genetic engineering.

And so it becomes clear: viruses are not mere carriers of disease. They are intricate cogs in the machinery of nature – unseen, rarely noticed, but indispensable.

A look into various habitats reveals their impact.

🌊 In the World’s Oceans

Population Control: Deep beneath the water’s surface, a microscopic battle of planetary scale rages on: bacteriophages – viruses that specifically infect bacteria – eliminate up to 40% of marine bacteria every day. By doing so, they prevent explosive algal blooms that could turn entire oceans into oxygen-deprived dead zones.

Without these „microbe hunters”, our planet would have long since sunk under a shroud of algae.

📖 Additional Sources:

Viral control of biomass and diversity of bacterioplankton in the deep sea

A sea of zombies! Viruses control the most abundant bacteria in the Ocean.

The smallest in the deepest: the enigmatic role of viruses in the deep biosphereGene Smuggling: In the blue depths of the oceans, Prochlorococcus – a tiny cyanobacterium – performs a mighty feat: it produces about 10% of the world’s oxygen. Yet even this microscopic hero is under the control of even smaller puppeteers: cyanophages – viruses perfectly specialized to infect it. These viruses insert their own photosynthesis genes and compel the infected cell to cooperate. The result: the bacterium remains „operational”, continuing to produce energy – now in service of its viral occupants. This parasitic partnership illustrates the so-called Black Queen Effect: by taking over certain functions, viruses allow microbes to lose those functions themselves and specialize in other tasks.

An involuntary division of labor, orchestrated by viruses.

Dive Deeper: An impressive glimpse into the mysterious world beneath the ocean’s surface is offered by a video from the Schmidt Ocean Institute. It showcases how researchers, using cutting-edge technology, follow the traces of microbial life – and in doing so, also track down viruses.

But viruses don’t just play this regulatory role in water – they are equally active in other ecosystems.

🟫 In the Soil

Even beneath our feet, viral activity is in full swing: viruses keep dominant soil bacteria in check, ensuring that no single microorganism gains the upper hand. This invisible regulation safeguards the delicate balance of the nutrient cycle – the foundation of all growth.

Like invisible gardeners, they comb through the micro-life of the Earth, weeding out excess and creating space for diversity.

🌳 In the Plant World

Trees and fields have secret allies: plant viruses. Around every root network unfolds a hidden web of control, defense, and opposition. Some plant viruses specifically target harmful bacteria that would otherwise sicken the plant. Others stimulate the plant’s own immune system – and when microbes die, viruses break down their remains into fertile compost. Some plants even go a step further: they actively recruit protective viruses that patrol the root zone like microscopic bodyguards.

Without these microscopic alliances, many forests would be far more vulnerable to fungal overgrowth – and our crops would be left defenseless against attacks from the soil.

🔗 Viruses as components of forest microbiome

🪱 In the Gut Flora of Humans and Animals

A silent power struggle also unfolds within our intestines – and we benefit from it. Specialized gut viruses (bacteriophages) specifically target harmful germs like E. coli, helping to maintain a stable bacterial balance. They transfer protective genes between microbes – like secret data packets that fine-tune immune responses. Some viruses even dampen overactive immune reactions, preventing inflammation in the process.

Without these nano-sheriffs, harmful bacteria would overrun the gut within days.

🔗 Over 100,000 Viruses Identified in the Gut Microbiome

☁️ In the Atmosphere

High above our heads, the largest gene transfer on Earth takes place – a single storm can disperse up to 500 million virions per square meter across entire continents, forming the ultimate bio-invasion route. Thanks to their extreme resilience, viruses survive where others fail – in UV-soaked altitudes, icy clouds, and dry air. They travel via dust, sea salt, or plant droplets across oceans and continents. Some even influence precipitation patterns by interacting with clouds.

This atmospheric gene exchange transforms local mutations into global evolution – as if nature had invented its own internet.

🔗 Deposition rates of viruses and bacteria above the atmospheric boundary layer

⚡️ In Extreme Habitats

Even in hot springs, salt lakes, or beneath the Earth’s crust, viruses thrive – regulating local microorganisms and boosting their genetic diversity. In these hostile environments, such regulation is an essential survival strategy.

🔗 Viruses in Extreme Environments, Current Overview, and Biotechnological Potential

The Greatest Paradox in Biology: From billions of microscopic acts of destruction arises global balance. So the next time you fear a virus, remember: with every breath, you carry billions of these tiny entities – and they, in turn, carry you. A pact of life – as old as evolution itself.

„We live in a balance, in a perfect equilibrium”, and viruses are a part of that, says Susana Lopez Charretón, a virologist at the National Autonomous University of Mexico. „I think we’d be done without viruses.” [Why the world needs viruses to function]

„If all viruses suddenly disappeared, the world would be a wonderful place for about a day and a half, and then we’d all die – that’s the bottom line”, says Tony Goldberg, an epidemiologist at the University of Wisconsin-Madison. „All the essential things they do in the world far outweigh the bad things.” [Why the world needs viruses to function]

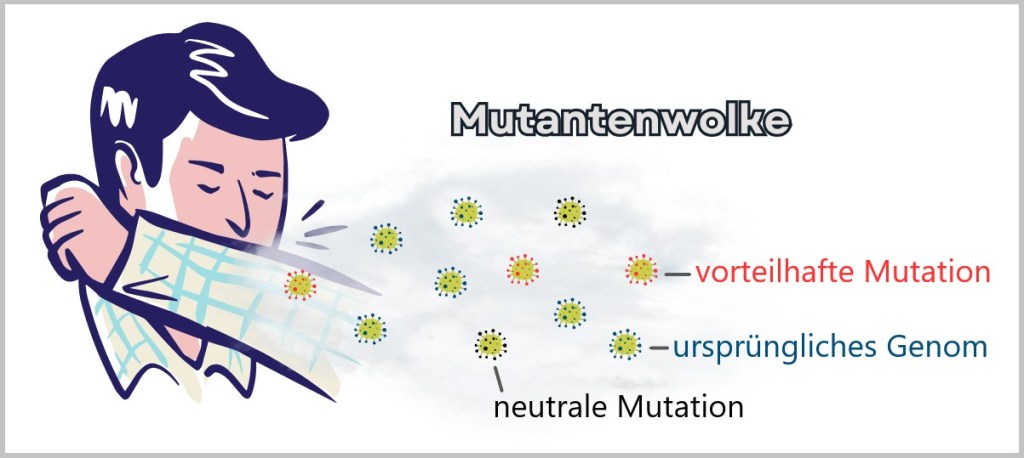

1.2. Viruses as Drivers of Evolution

Long before dinosaurs roamed the earth, viruses were already up to mischief – shaping life as we know it today. Their tool: horizontal gene transfer, a biological copy-paste mechanism that enabled evolutionary quantum leaps.

For evolutionary biologist Patrick Forterre from the Pasteur Institute, viruses are the architects of life – without them, evolution might have taken a very different path.

(See also Spektrum der Wissenschaft: „The True Nature of Viruses”, ScienceDirect: „The origin of viruses and their possible roles in major evolutionary transitions” or „The two ages of the RNA world, and the transition to the DNA world: a story of viruses and cells”)

Genetic Sabotage with Lasting Effects

Viruses are masters of manipulation. When they infect a cell, they don’t just inject their own genetic material – sometimes their genes get integrated into the host’s genome and are passed down through generations. Supposed disruptors thus become creative gene architects.

A spectacular example: The placenta of mammals owes its existence to a virus. A viral envelope protein – originally designed to suppress immune responses – was incorporated into the gene pool and helped develop the barrier between mother and embryo. Without this „foreign” gene: no womb, no mammal.

But it goes even further: about 8% of the human genome comes from ancient retroviruses that once embedded themselves into our DNA – silent witnesses of ancient infections that may still influence us today. Even our brain might carry viral traces – for example, genes crucial for the development of the cortex.

Aren’t we all a bit of a virus?

CRISPR, celebrated today as a revolutionary gene-editing tool, traces back to an ancient bacterial defense system – a genetic archive of past viral attacks from which bacteria learn to defend themselves against new enemies.

Some scientists even ask: Could viruses have played a role in the origin of life itself? Certain hypotheses suggest that virus-like particles may have been the first molecules capable of storing and transmitting genetic information – a fundamental prerequisite for life.

The irony of fate: We fear viruses as bringers of death – yet without them, we might never have come into existence.

1.3. Do Viruses Really Exist?

Despite their immense importance, there are always doubts about the existence of viruses. How can we be sure that they are real? This question cannot be answered by simple observation – viruses elude our naked eye and only reveal themselves through indirect traces and specialized detection methods.

To get to the bottom of this question, we first need to understand how viruses act: What mechanisms do they use to replicate? How do they interact with their hosts? And above all, what scientific methods are available to visualize and detect them?

The search for these answers leads us into a fascinating world of advanced technologies and decades of research. In the chapters to come, we will explore step by step how scientists detect viruses – bringing us closer to answering the essential question: Do viruses really exist?

2. Viral Mechanisms Illustrated by Influenza

Let’s begin by taking a closer look at how viruses „hijack” their host cells and exploit them for reproduction. A prime example of this is the influenza virus – not only because it is one of the most thoroughly studied viruses, but also because it vividly demonstrates how viruses manipulate cells and spread. The mechanisms it employs offer us an ideal insight into the mysterious world of viruses and their complex interactions with their hosts.

2.1. How the Influenza Virus Travels

2.2. The Architecture of the Influenza Virus

2.3. The Infection Process of the Influenza Virus

2.4. The Adaptability of the Influenza Virus

2.5. Entry and Exit Routes of the Influenza Virus

2.6. Mostly Localized Mucosal Infection

2.7. Viral Strategy: Efficient Replication Without Rapid Cell Destruction

2.8. Destruction of the Host Cell

2.9. Self-Limiting Dangerous Viruses: Why They Rarely Cause Pandemics

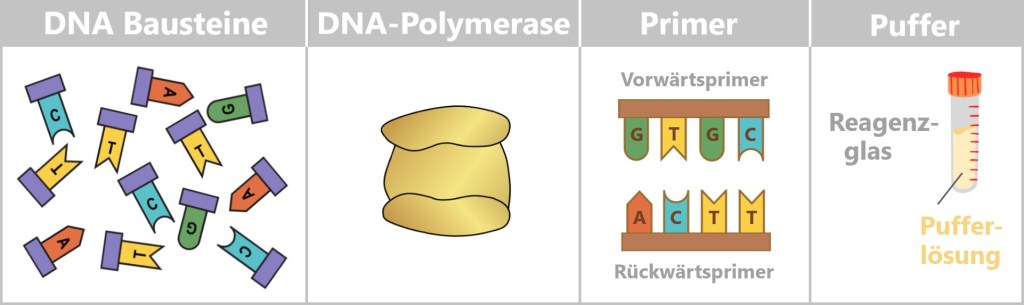

2.10. Why Does the Virus Make Some People Sick and Others Not?💡Note: The following chapters build upon basic knowledge of cells, the difference between DNA and RNA, proteins, and cellular processes such as protein biosynthesis. If these topics are still new to you, it may be helpful to take a look at Chapters 2, 3, and 4 of the treatise „The Wonderful World of Life” or similar introductory texts.

Chapter 2: The Cell – The Fundamental Building Block

Chapter 3: Proteins – The Building Blocks of Life

Chapter 4: From Code to Protein – Cellular Mechanisms

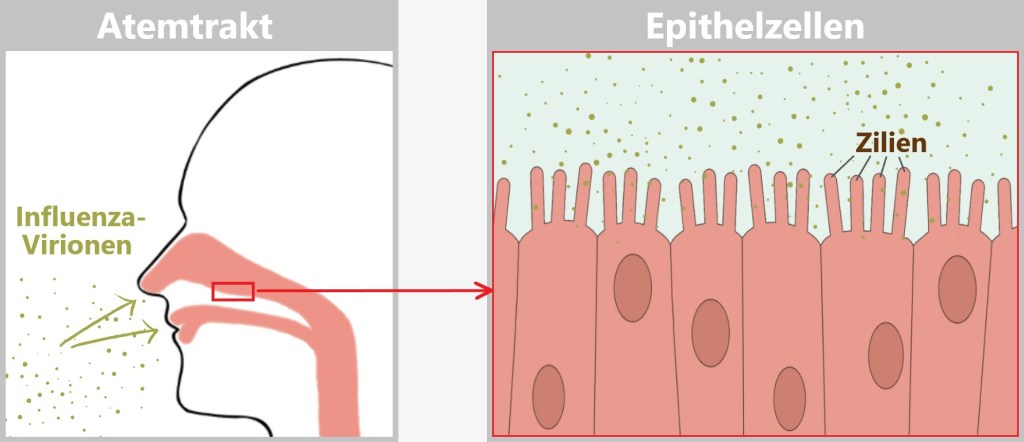

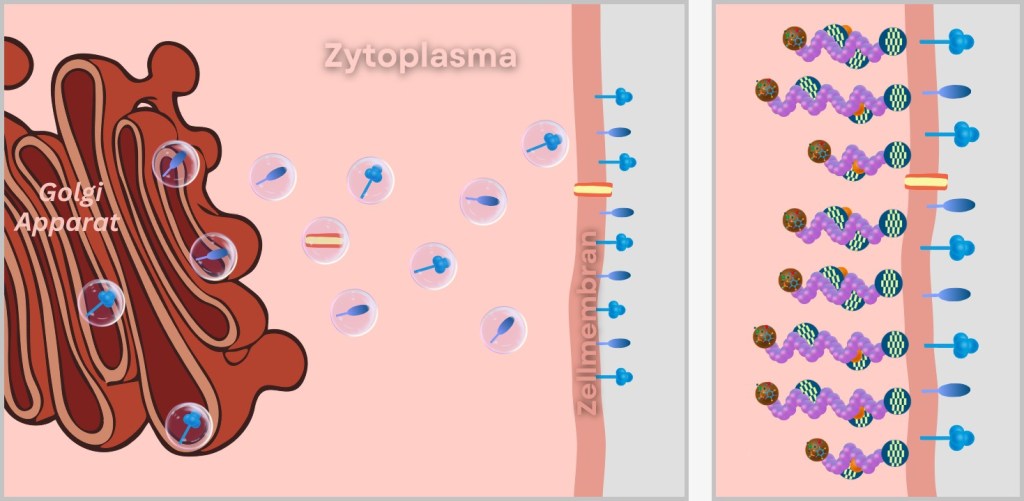

2.1. How the Influenza Virus Travels

The influenza virus is constantly on the move – an invisible jet-setter with astonishing transmission routes: sometimes it travels first class via a sneeze cloud, other times it hitchhikes over door handles.

Droplet flight – first class through the air

One sneeze is enough: up to 40,000 virus-laden droplets shoot through the air – like a mini missile strike on the surroundings (range: up to 2 meters!).Smear attack – the secret handshake

Door handle, elevator button, keyboard – the virus chills on surfaces, sometimes for hours. One touch, one swipe of the face – and it has already gained access via a hand-to-face trick.

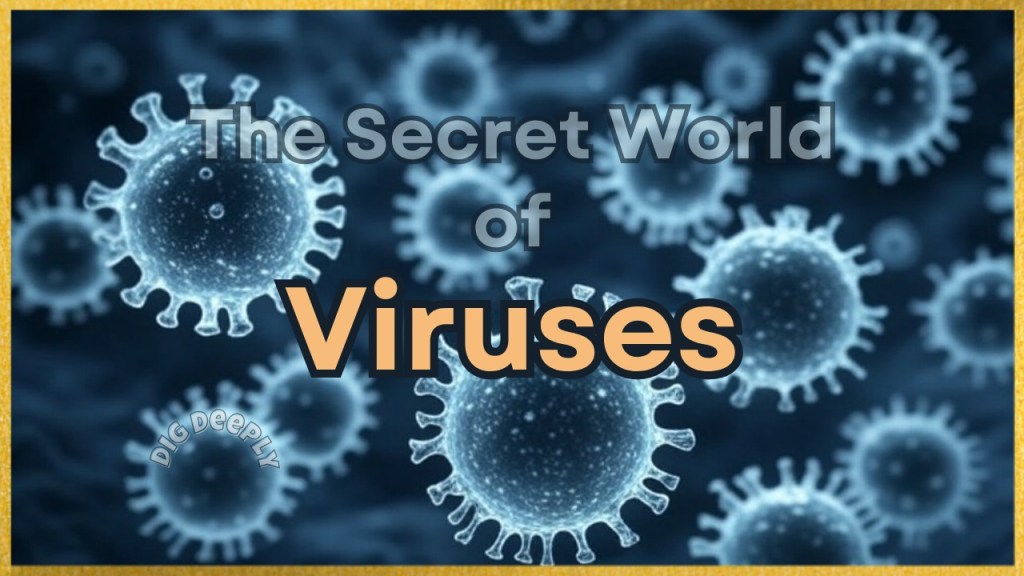

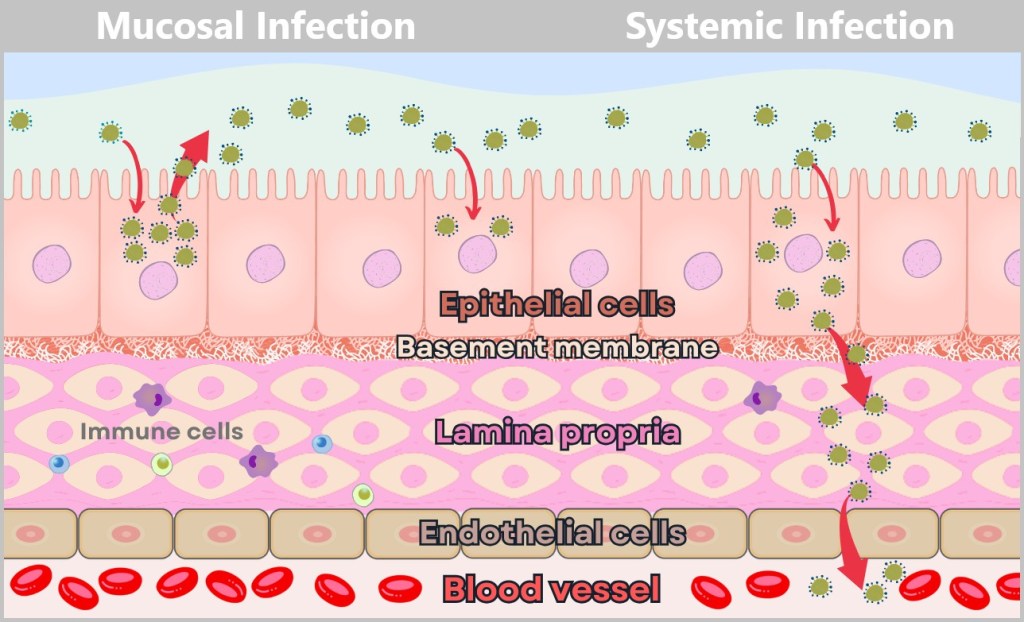

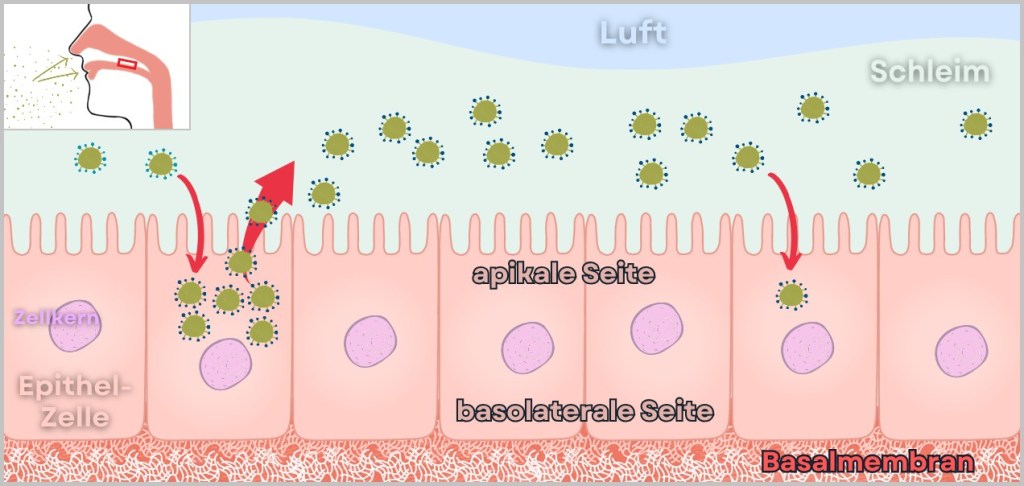

Mission: Respiratory Tract – Viral Invasion

Once inside the respiratory tract, the virus launches its assault on epithelial cells:

Preferred target: Mucosal cells in the nose, throat, and bronchi.

Why? There are plenty of favourite receptors here – perfect docking sites.

Result: Within hours, it hijacks the cell’s machinery and begins producing new viruses.

Fig. 2-A: Influenza virions enter the respiratory tract and come into contact with the epithelial (mucosal) cells that line the respiratory tract. From the outside, it looks like a speck of dust with bad intentions – but upon closer inspection, the influenza virus reveals itself as a highly complex nanomachine. To understand how it hijacks cells and constantly mutates, it’s worth taking a closer look inside.

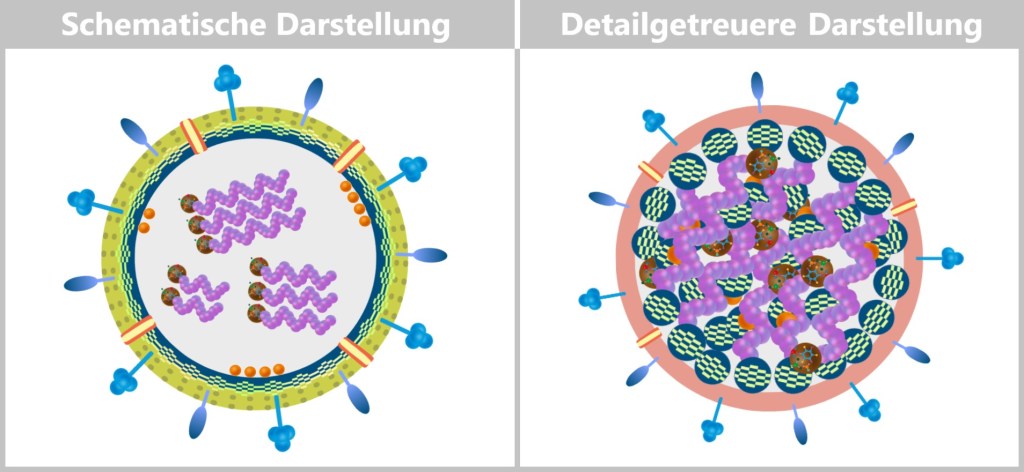

2.2. The Architecture of the Influenza Virus

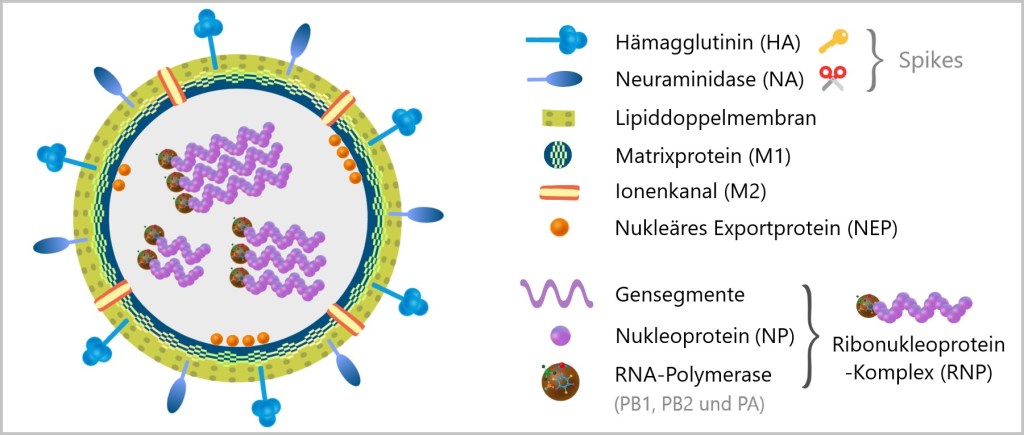

The influenza virus is the reason we find ourselves bedridden with fever, cursing „the flu”. Of the three strains (A, B, and C), Type A is the most dangerous globetrotter: as shape-shifting as an actor and as unpredictable as April weather. Types B and C, on the other hand, are more „down-to-earth” – less variable and generally less dangerous. Yet all of them share the same ingenious structural blueprint (see illustration below).

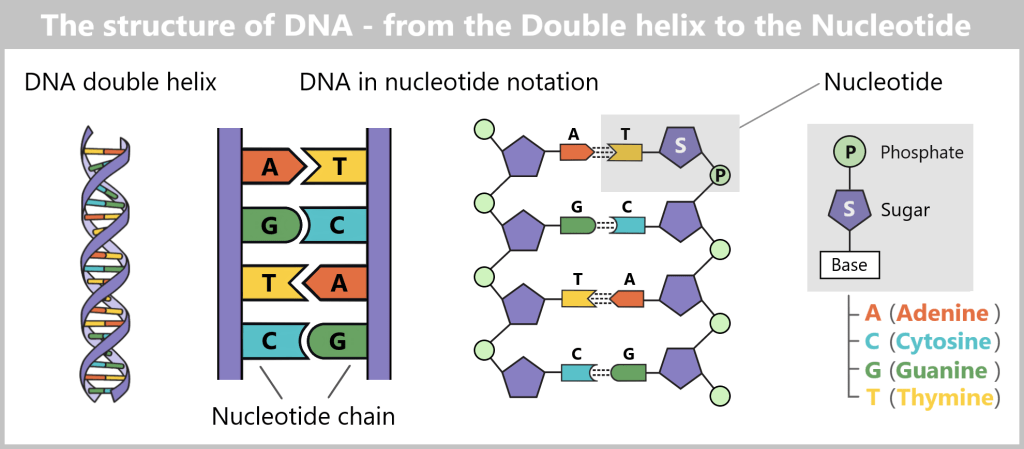

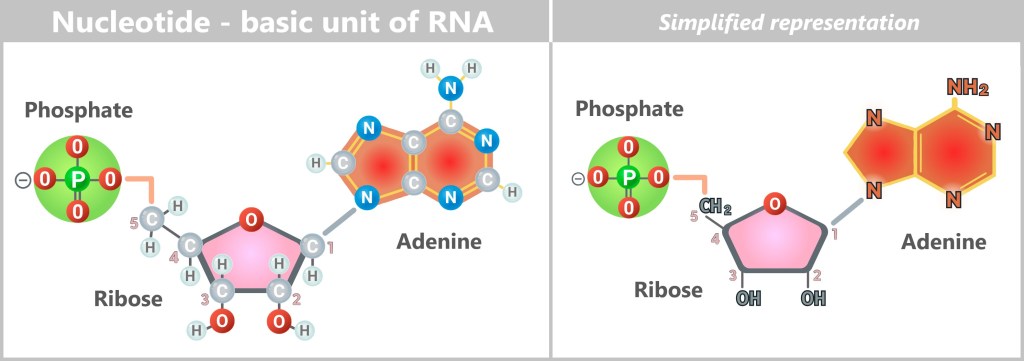

The virus particle – a mere 80 to 120 nanometers in size – is a master of survival, resembling a tiny, spherical nano-submarine (sometimes oval-shaped). Inside: its viral genetic material made of RNA – but with a special trick!

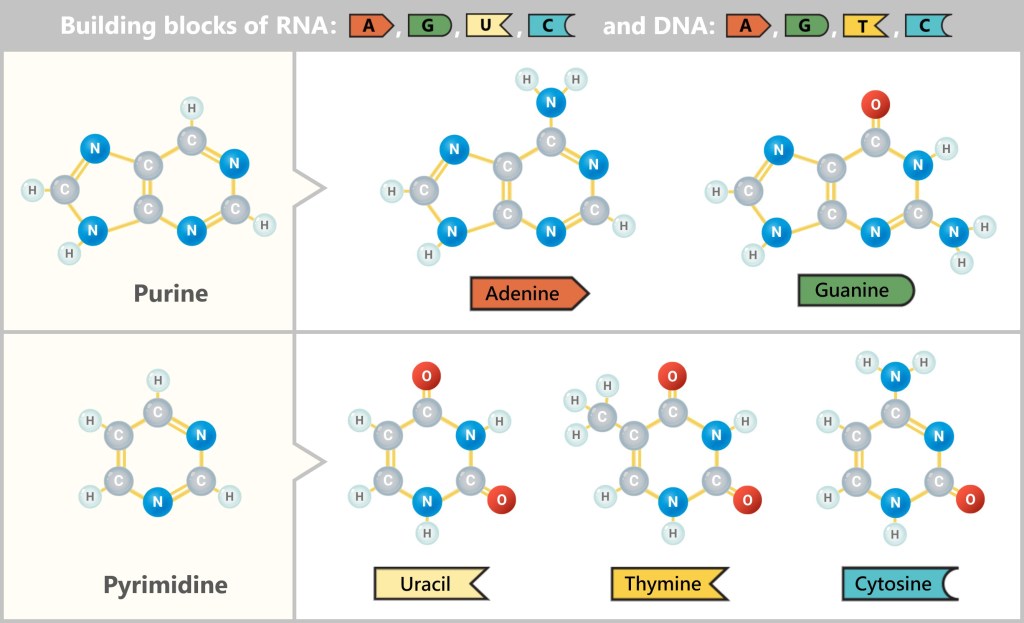

While we often think of RNA or DNA as a single, unbroken strand, viruses have different DNA and RNA structures. Some have a single continuous molecule, others carry their genetic material divided into several RNA segments.

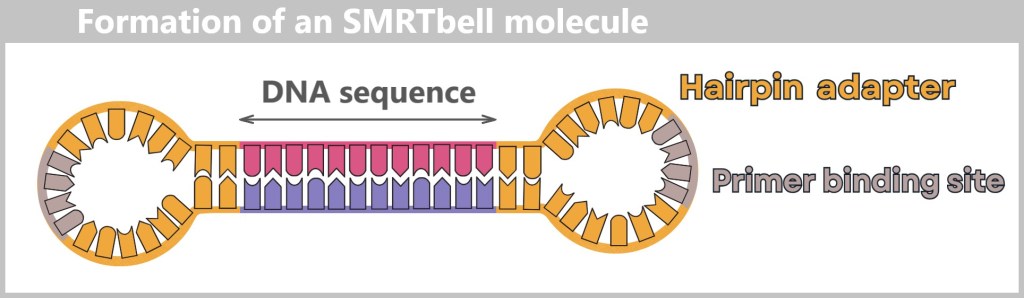

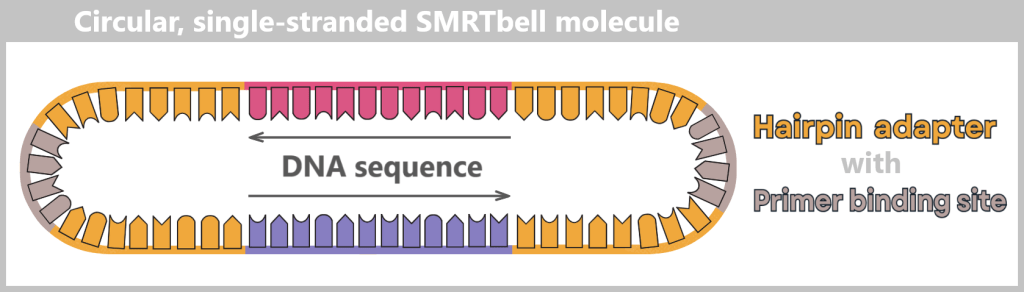

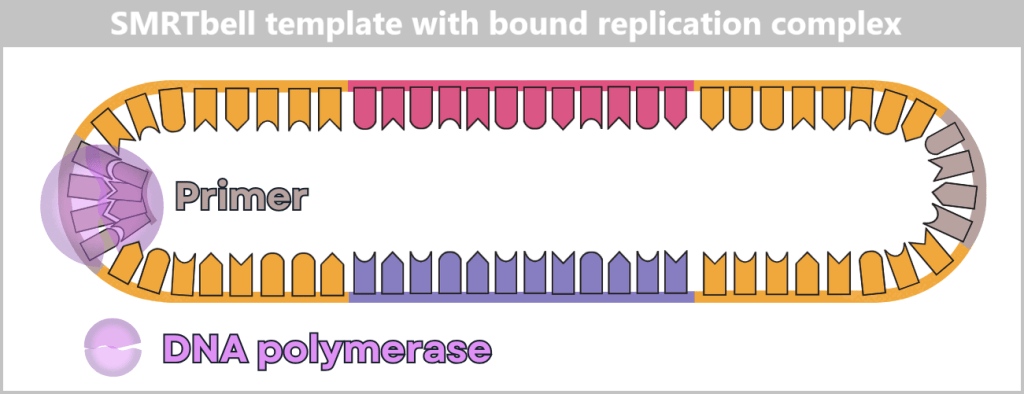

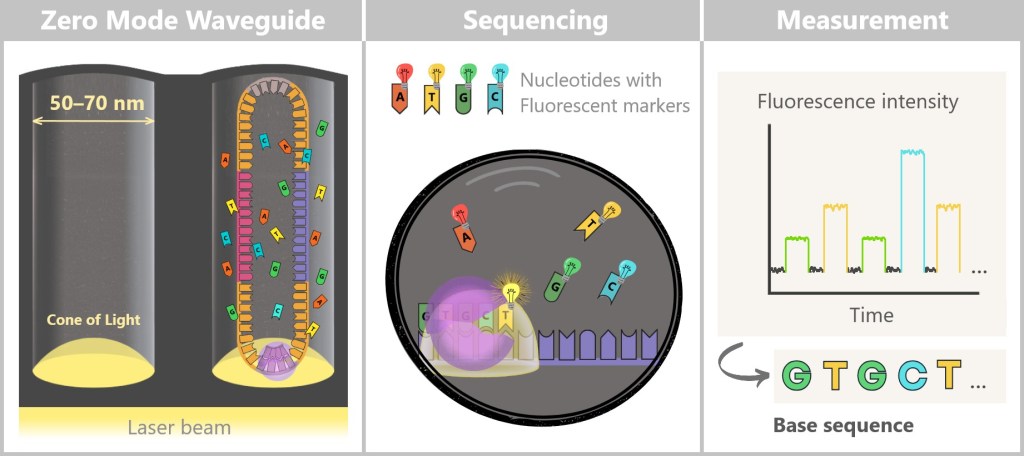

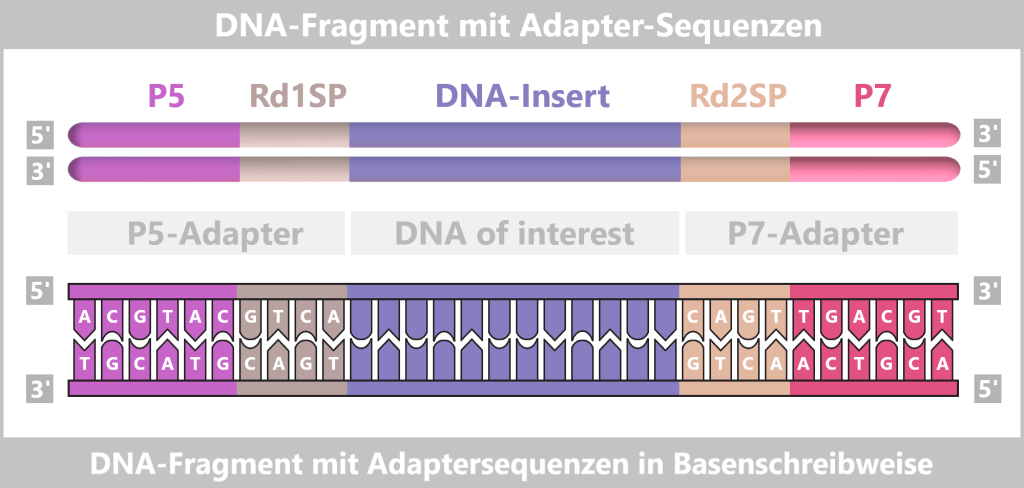

The Command Center: Genome in 8 Segments

The influenza virus is based on a modular design: it uses 8 separate RNA segments – like a construction kit whose parts can always be recombined – perfect for surprises!

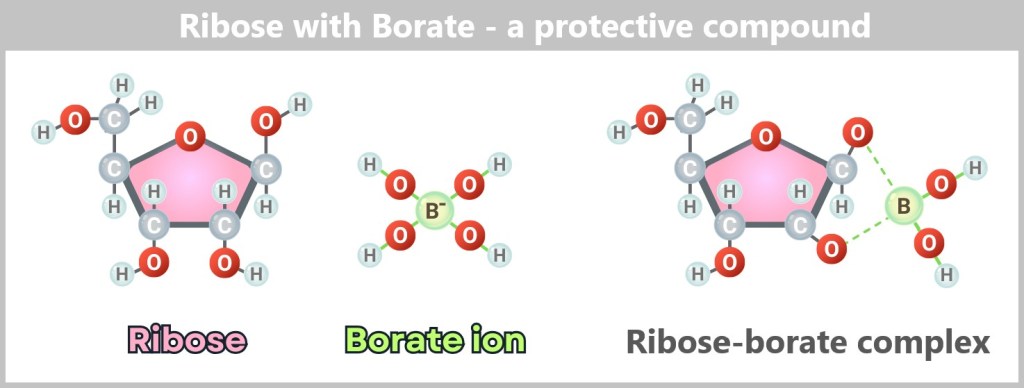

These RNA segments vary in length – from compact mini-modules to XXL construction manuals – and yet they are perfectly harmonised. To prevent them from getting lost like loose pages in the wind, each segment is carefully packaged: every strand is wrapped in a sheath of nucleoproteins (NP), like precious scrolls in protective foil. But the NP envelope is more than just protection: it assists the viral machinery to precisely read, copy and pass on the genetic information.

The toolbelt: Polymerase complexes

In addition, the virus brings its own 3D printers – the RNA polymerases (composed of the subunits PB1, PB2, and PA). These are firmly attached to the RNA segments, like craftsmen carrying their tools on a belt.

Fig. 2-B: Structure of an influenza virus – schematic representation of all components The RNP Complex – the Heart of the Virus

Each RNA segment + nucleoproteins (NP) + polymerase forms a ribonucleoprotein complex (RNP) – a perfectly organized unit: the virus’s command center. All eight – neatly packed and ready for action – like a portable toolbox for taking over the cell.

The Lipid Envelope – the Stolen Cloak of Invisibility

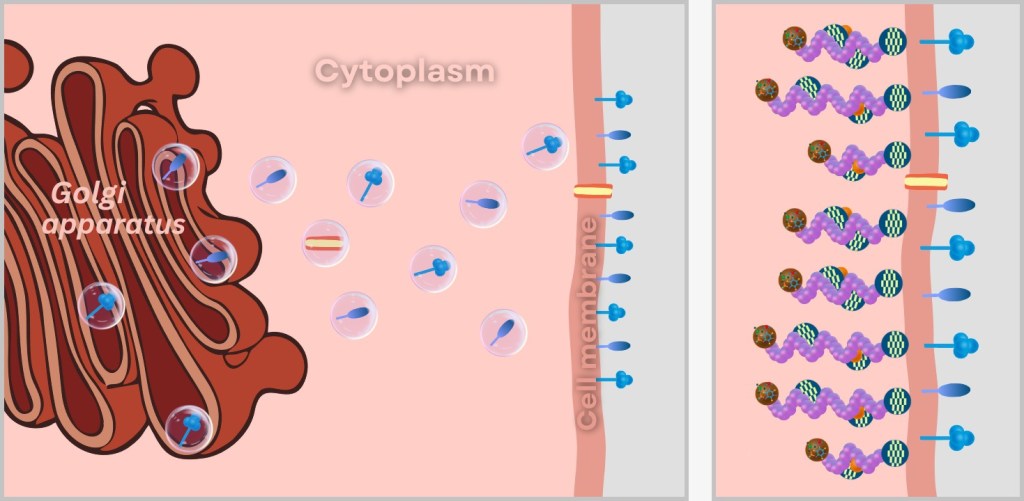

The virus steals its outer layer directly from the host cell: a lipid bilayer – identical to the cell membrane, making it the perfect disguise! Just beneath it lies the matrix protein M1 – the molecular scaffolder that holds everything together. It connects the outer envelope with the inner complex and ensures the virus keeps its shape – like a support frame beneath the cloak.

The Spikes: Key & Scissors

Embedded in the viral envelope are crucial surface proteins that protrude like tiny spikes or grasping arms. These are called „spikes”. The influenza virus has two especially important spikes that help it infect cells: Hemagglutinin (HA) and Neuraminidase (NA).

🔑 HA – The Door Opener: Acts as a key to dock onto the host cell.

→ 18 known variants (H1–H18)✂️ NA – The Escape Helper: Breaks the connection to the host cell so the virus can move on.

→ 11 variants (N1–N11)Virus Types: A Numbers Game

The combination of HA and NA determines the strain:- H1N1 (swine flu)

- H5N1 (avian flu)

- H3N2 (seasonal flu)

Like car license plates: HA/NA codes reveal which „model” is on the move – just without road safety inspection!

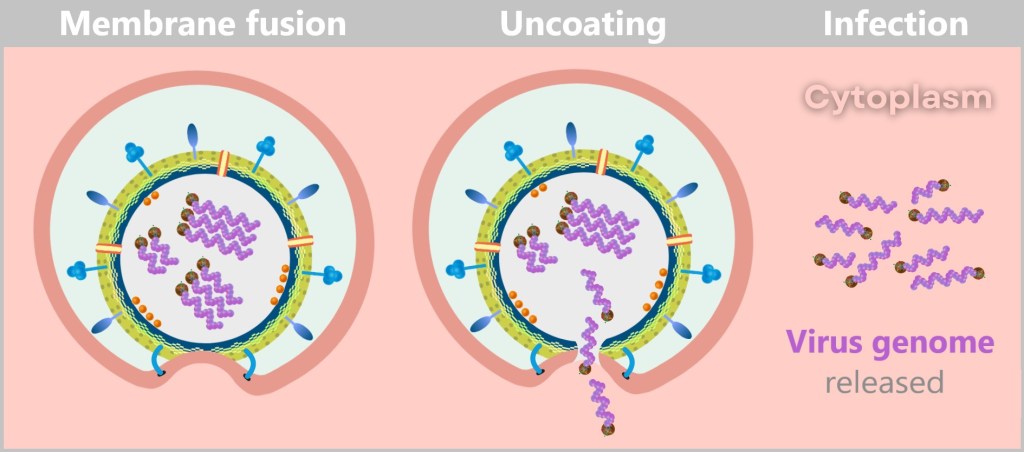

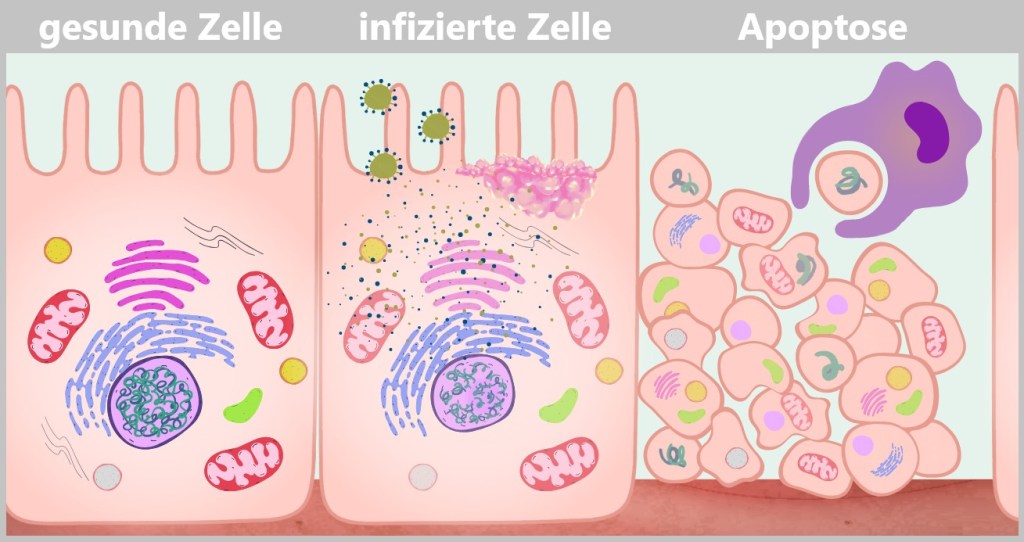

2.3. The Infection Process of the Influenza Virus

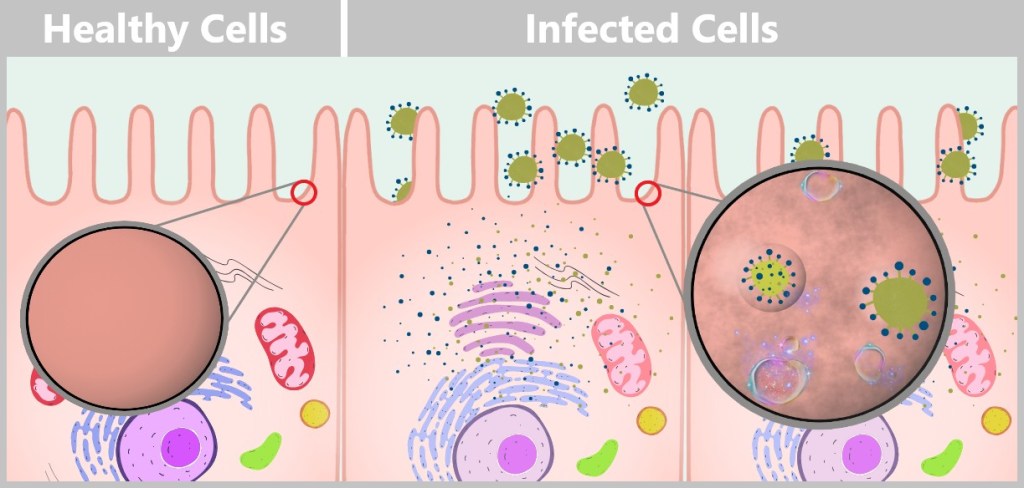

a) Attachment of the virus to the host cell (Adsorption)

b) Entry into the cell (Endocytosis)

c) Release of the viral genetic material (Uncoating)

d) Viral replication – The molecular factory

e) Assembly of new virus particles

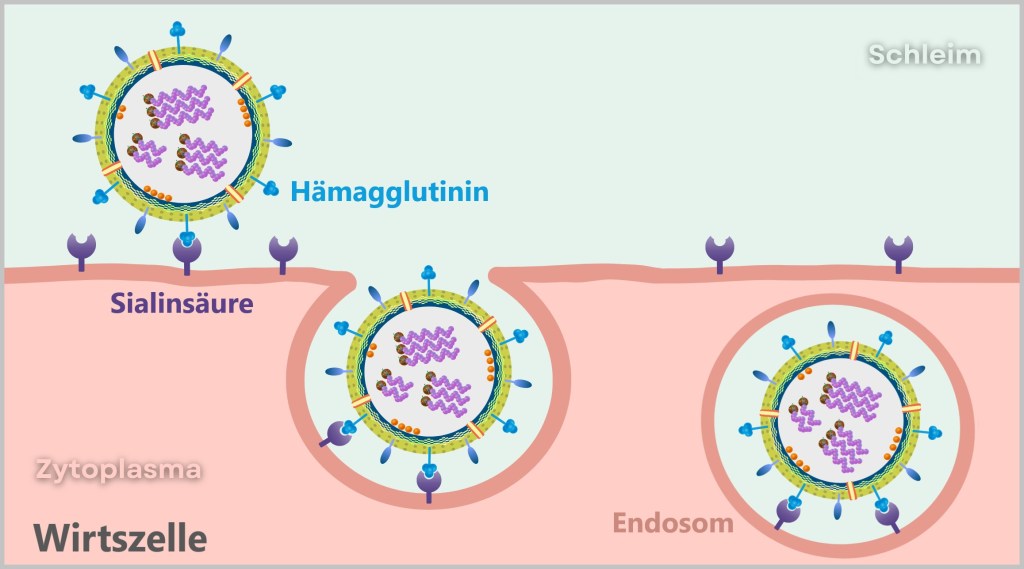

f) Budding and release of new virusesa) Attachment of the Virus to the Host Cell (Adsorption)

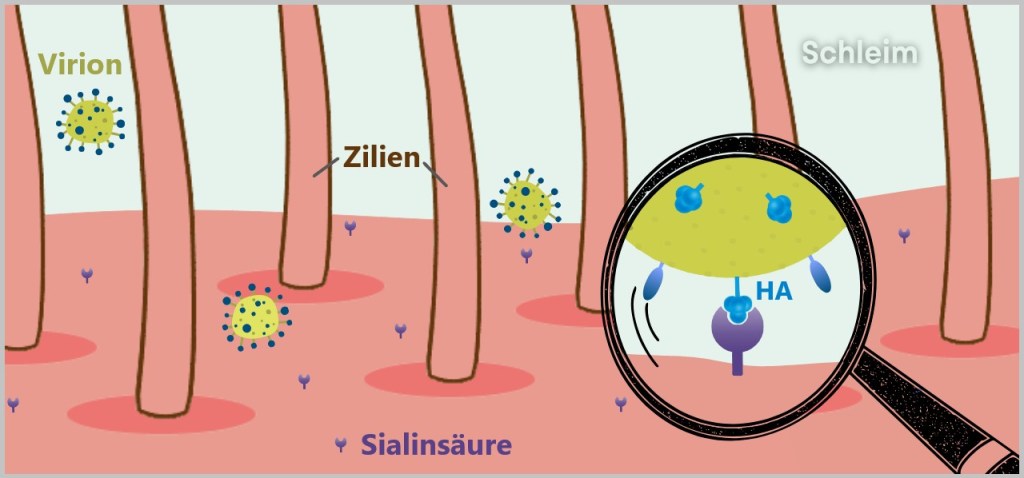

The surface of the respiratory tract is lined with a dense epithelium of mucosal cells. These cells carry sialic acid residues on their surface – sugar molecules that play a central role in cell communication and immunological self-recognition (see chapter „SELF Markers: Sialic Acids” in „The Wonderful World of Life”).

The influenza virus hijacks this mechanism: its surface protein hemagglutinin (HA) specifically binds to the sialic acid of the host cell – a classic lock-and-key interaction that initiates the virus’s entry.

Fig. 2-C: Surface of an epithelial cell Before the influenza virus can infect a cell, it must first attach to the host cell – a crucial step in the infection process. However, the epithelial cells of the respiratory tract are not defenseless: their motile cilia (tiny hair-like structures) transport foreign particles such as dust, bacteria, or viruses away before they can reach the cell surface.

The illustration shows the relative sizes at the cell surface. The cilia are 5–10 micrometers long, while the mucus layer has a thickness of 10–100 micrometers. At just 80–120 nanometers, the virus particle is tiny. It must quickly reach a cell before the cilia carry it away.

Between the cilia, there are exposed areas of the cell surface where the virus can make direct contact. The sialic acid residues (1 nanometer) on the host cell membrane serve as docking sites for the HA protein (13 nanometers) of the virus, which is large enough to reach these structures. This allows the virus to penetrate the mucus layer and bind to the host cell.b) Entry into the Cell (Endocytosis)

The influenza virus is a master of disguise: by binding its hemagglutinin to sialic acid residues, it mimics a harmless nutrient molecule. The host cell falls for the trick and initiates its standard uptake mechanism – endocytosis.

What follows is a molecular spectacle:

The cell membrane folds around the attached virus – triggered by signaling molecules normally responsible for nutrient uptake. Like a closing trap, an indentation forms that fully engulfs the virus. With a final „snap” of the membrane, an endosome is formed – a transport vesicle that now innocently shuttles the intruder into the cell’s interior.

What the cell registers as harmless transport turns out to be a Trojan horse.

Fig. 2-D: The influenza virus enters the host cell. The virus is now inside the cell – still enclosed within the endosome – but ready to unfold its innermost potential.

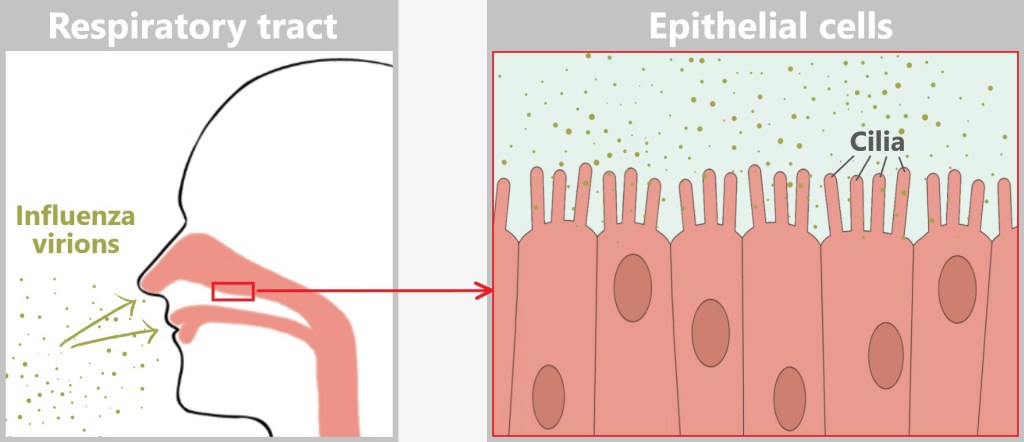

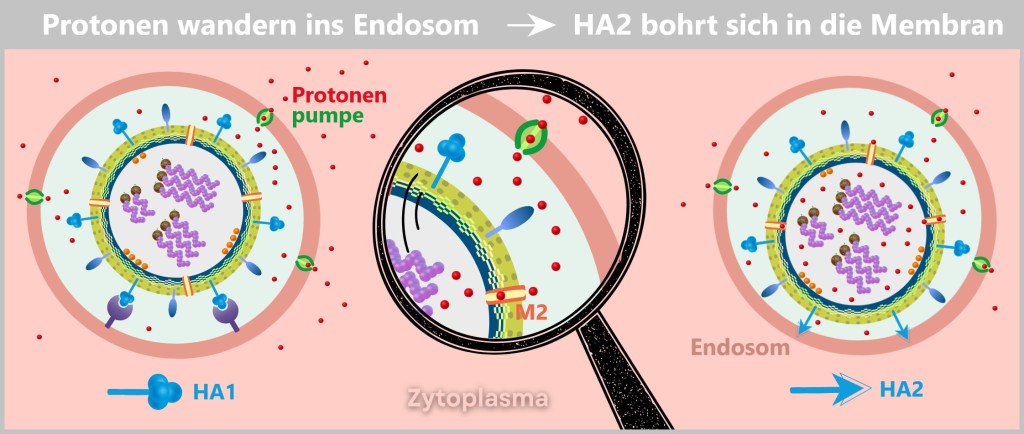

c) Release of the Viral Genetic Material (Uncoating)

The early endosome matures into a late endosome – a site where the cell typically degrades unwanted intruders. Proton pumps lower the pH by transporting protons (H⁺ ions) into the interior, creating an acidic environment intended to activate digestive enzymes.

The acidic trick

But the influenza virus has a brilliant counterplan: the acidic environment triggers a dramatic transformation of the viral hemagglutinin (HA). The protein splits – its binding domain HA1 is cleaved off, and the fusion domain HA2 is exposed.

This fusion domain, HA2, is hydrophobic – it avoids water – and rams itself like a grappling hook into the endosomal membrane (see illustration below).

At the same time, the M2 protein – a viral ion channel – acts as a secret accomplice and opens the floodgates: protons flow into the virus interior, loosening the packaging of its genetic material.

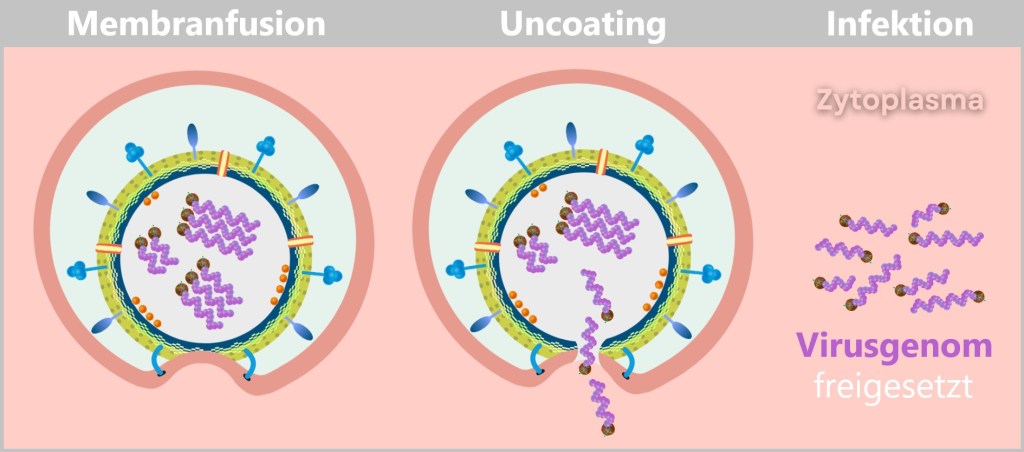

Fig. 2-E: Anchoring of the virus in the endosomal membrane Now, HA2 pulls the viral membrane and the endosomal membrane together with relentless force. The two lipid membranes fuse – a process known as membrane fusion. This occurs because the lipid molecules in the membranes are flexible and can rearrange themselves to form a continuous bilayer.

This fusion creates a pore – the gateway to freedom for the viral genome. With one final, elegant push, the viral RNA slides into the cytoplasm. The uncoating process is complete.

The cell has no idea that it has just released the blueprint for its subjugation.

Fig. 2-F: Release of the viral genome into the host cell’s cytoplasm: Through membrane fusion and uncoating, the viral envelope is dissolved, releasing the genome and initiating the infection.

Why is the virus not degraded?

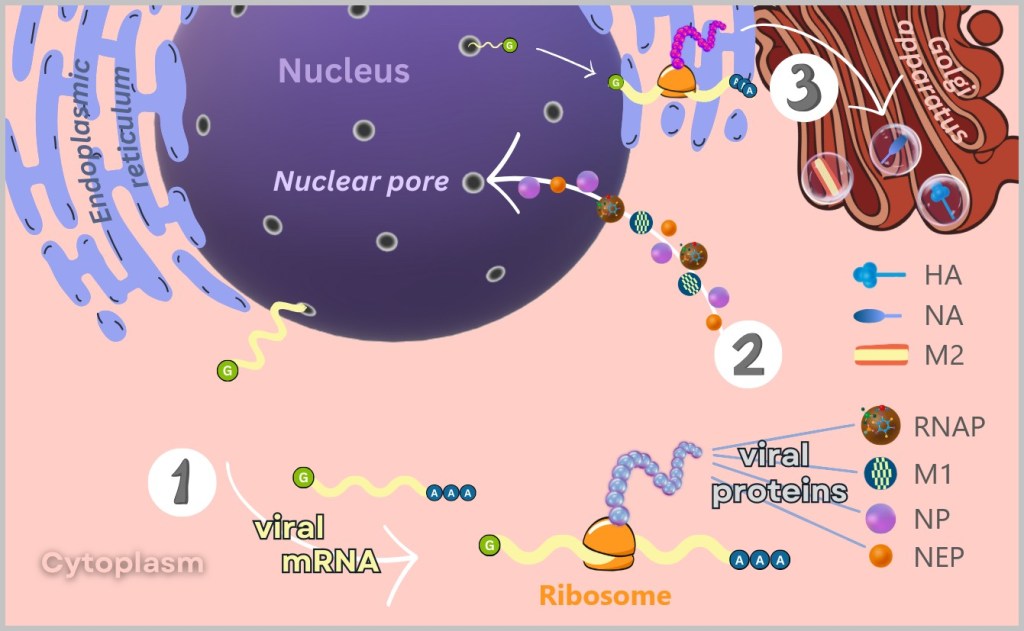

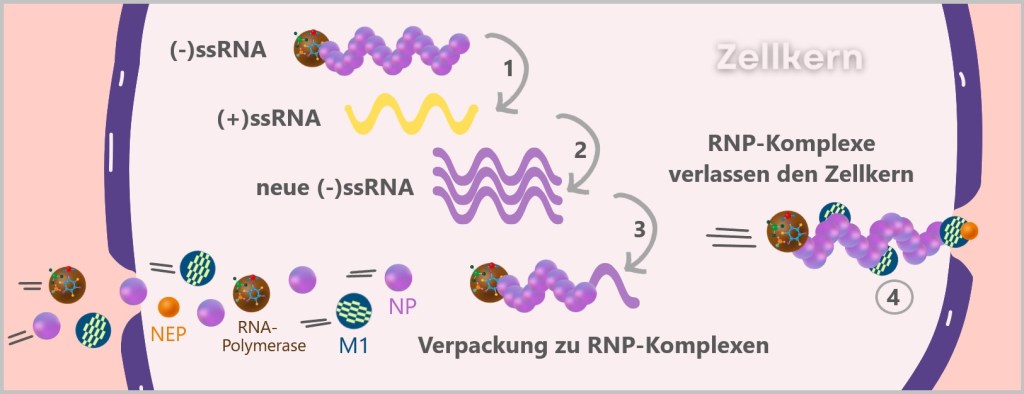

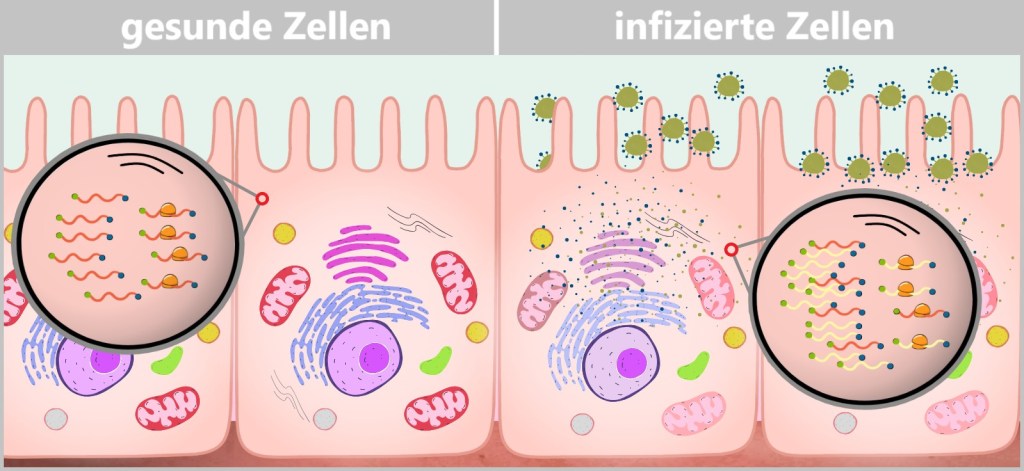

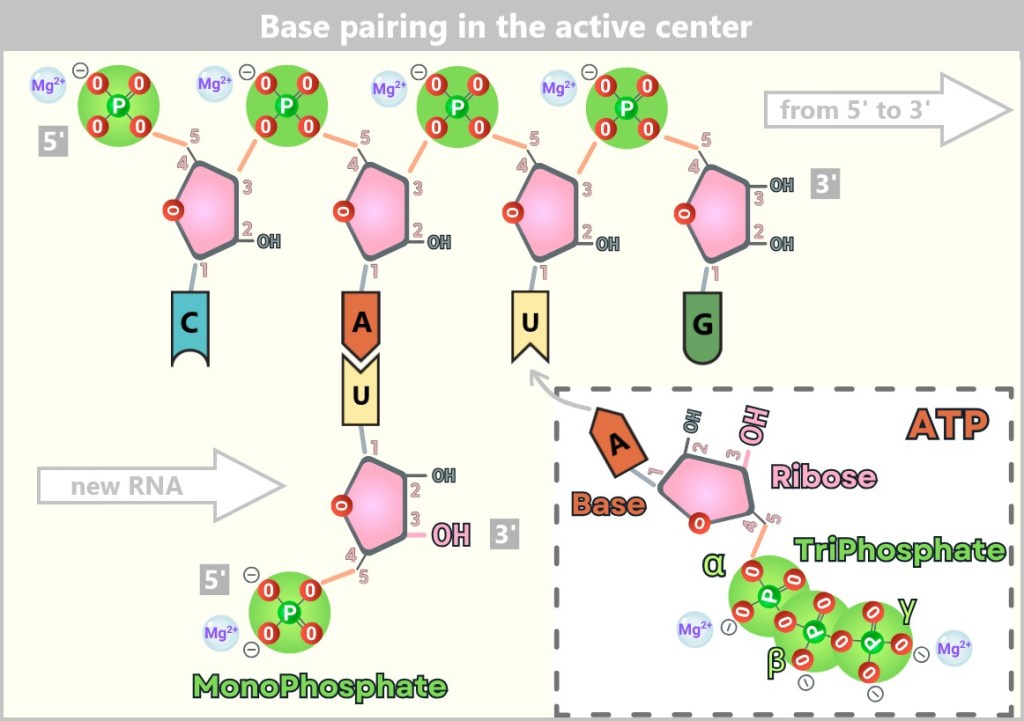

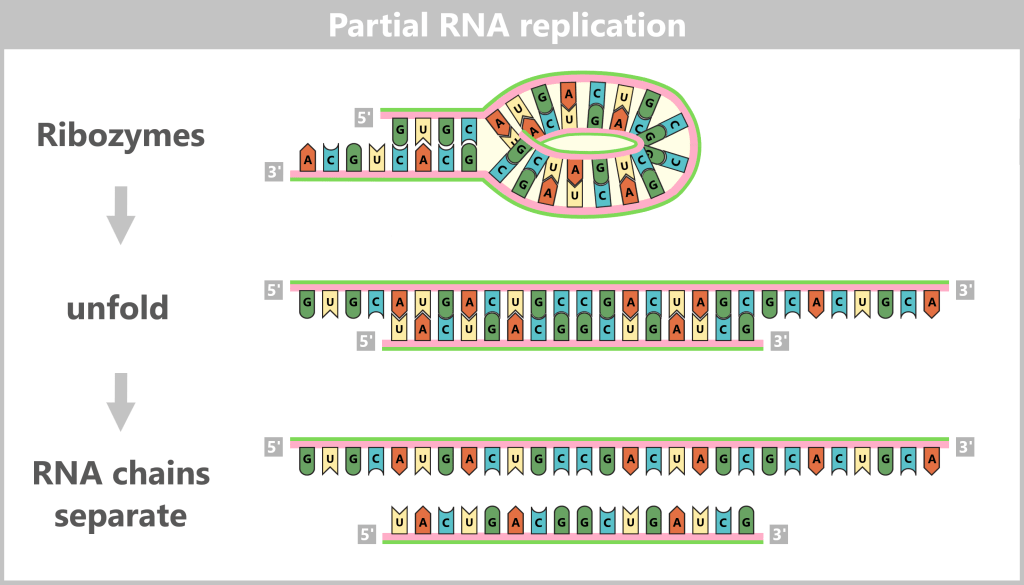

The virus is not degraded by the cell’s digestive enzymes because the release process happens quickly – before the degradation mechanism (activation of digestive enzymes) can take effect. The virus exploits the drop in pH and the changes within the endosome to rapidly escape by triggering membrane fusion, releasing its genome directly into the cell’s cytoplasm. This „escape” from the endosome is faster than the cellular breakdown process, which is why the virus is not decomposed.d) Viral Replication – The Molecular Factory

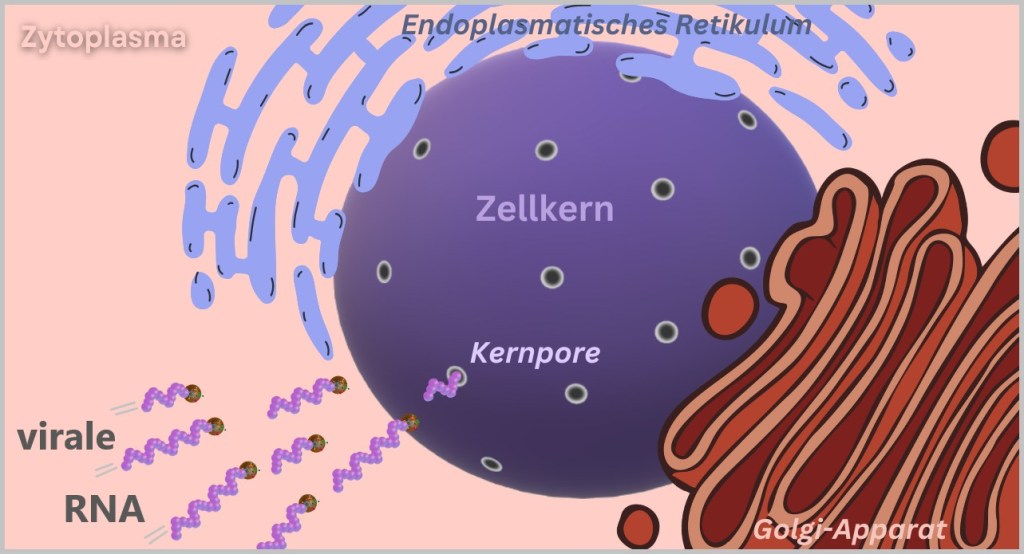

The viral RNA does not arrive unprotected – it travels in high-tech armor: wrapped in protective nucleoproteins (NP) and equipped with viral polymerase, each of the eight RNA segments forms a highly organized ribonucleoprotein complex (RNP). These molecular command units are perfectly equipped for their mission:

- The nucleoproteins act like armor – shielding the RNA from cellular defense systems.

- The polymerase is the Swiss army knife of the virus – a tool for copying (replication) and translating (transcription) in one.

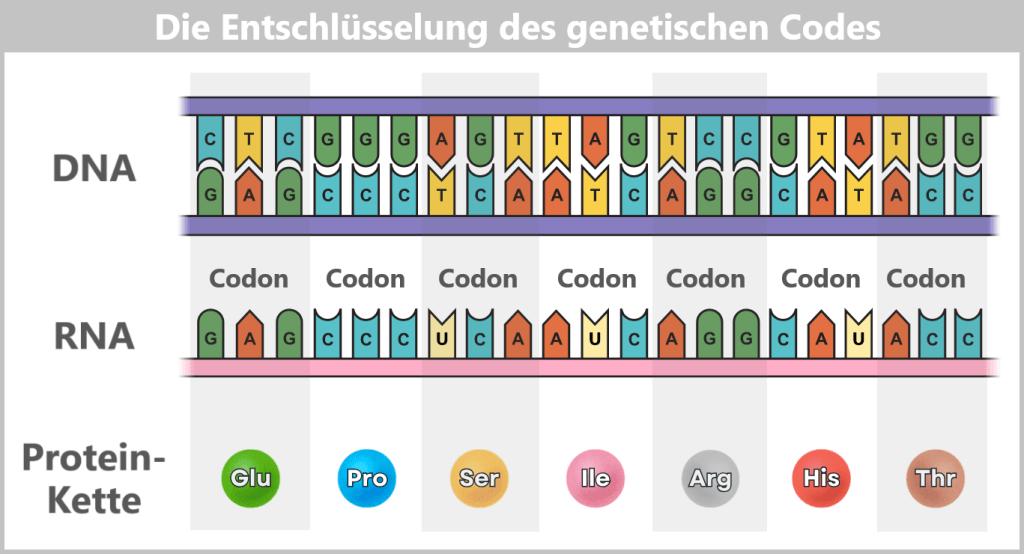

As soon as the ribonucleoprotein complexes (RNPs) are released in the cytoplasm, the systematic takeover of the cellular production lines begins – the virus factory goes into operation. The genome takes on two central tasks: On the one hand, it serves as a blueprint for the production of viral proteins (Protein synthesis), on the other hand, it is itself replicated (Genome replication) – so that each new virus particle is given its own copy of the genetic material along the way.

Fig. 2-G: To build new viruses, new viral proteins and new viral genomes are required. Protein synthesis: The viral genome serves as a template for the synthesis of the proteins needed to assemble new virus particles.

Genome replication: At the same time, the viral RNA is replicated to provide the genetic information for new viruses.While most RNA viruses remain in the cytoplasm, influenza has a clever trick up its sleeve: it hijacks the cell nucleus. Why? Because there, it finds optimal conditions for replicating its RNA.

The journey there, however, is anything but straightforward. The RNPs manipulate the cellular transport system by presenting fake import signals – molecular entry passes that grant them access to the nucleus. Cellular importins, normally responsible for transporting the cell’s own proteins, thus become unsuspecting smugglers. In a feat of biological deception, the viral RNPs are escorted straight into the cell’s control center.

Fig. 2-H: The viral RNA is transported from the cytoplasm into the cell nucleus. In the cell nucleus, the RNPs finally unfold their full potential. The viral polymerase begins its double role:

- Copying the viral RNA (replication) → blueprint for new viruses

- Producing viral mRNA (transcription) → building instructions for protein synthesis

As this process is particularly sophisticated, each step is described in detail below.

1️⃣ Activation of the RNA polymerase – Here we go

The viral polymerase needs a molecular ignition spark to become active. And it finds this in the cell nucleus: a biochemical special zone that differs significantly from the cytoplasm. High concentrations of nucleotides, ions and nucleus-specific factors send a clear signal: „This is the place to start!” Only in this environment does the polymerase come to life. Without this molecular wake-up call, it remains in a dormant state – camouflaged as a harmless cellular component.

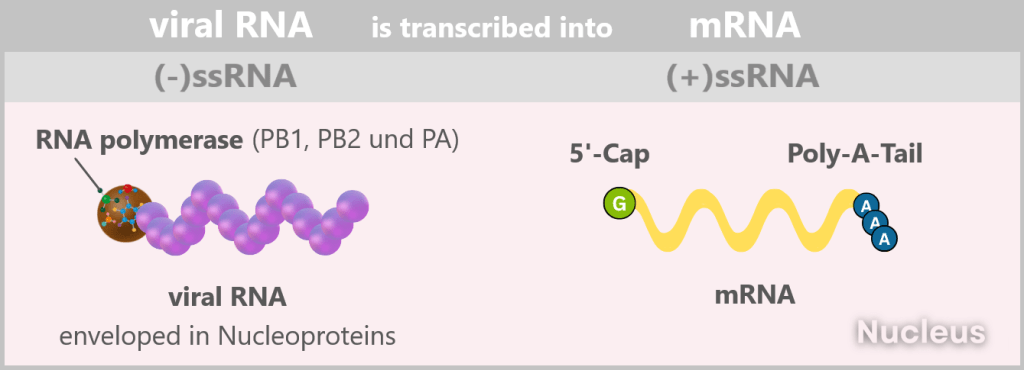

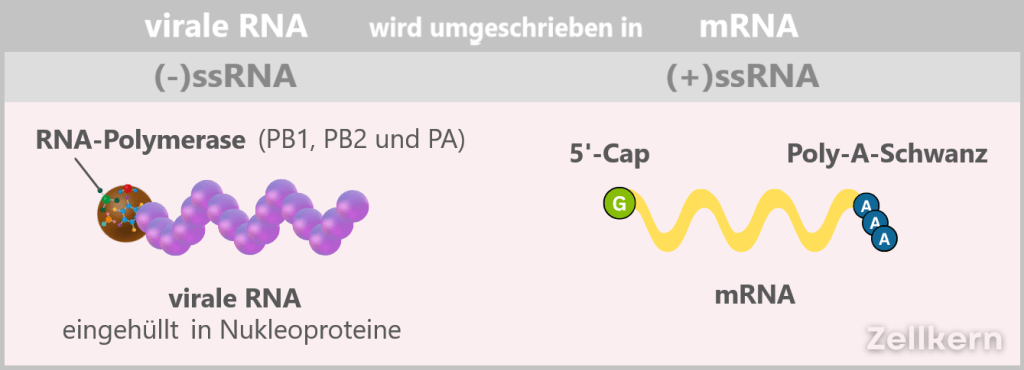

2️⃣ Initial situation: (-)ssRNA – A Genome in Mirror Writing

The genome of the influenza virus is a master of disguise. Instead of presenting itself as a readable blueprint, it appears more like a riddle in mirror writing: eight separate RNA segments, negatively polarized, lacking all the usual hallmarks of a cellular message. No sender, no letterhead, no stamp. To the cell, it’s not a message – it’s biological noise.

In scientific terms:

The viral genome consists of eight segmented single-stranded RNA (ssRNA) with negative polarity: (-)ssRNA. „Negative” means that this RNA is the complementary template to the mRNA (i.e. mirror-inverted) and therefore not directly readable.

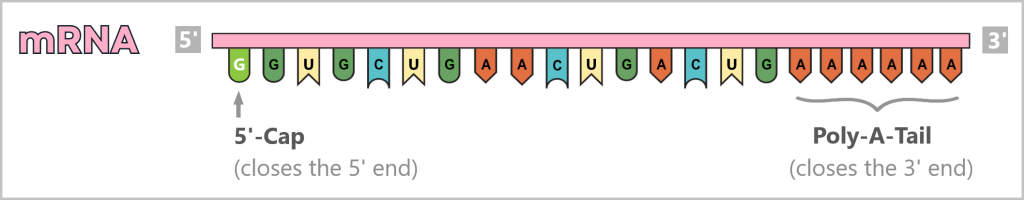

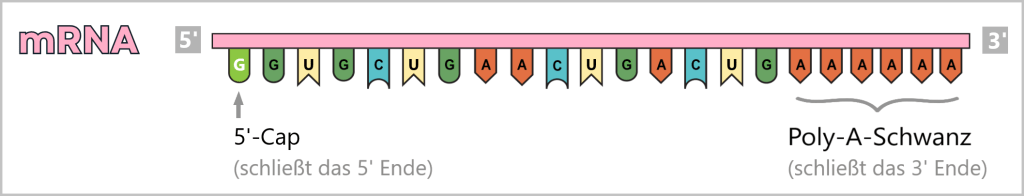

In addition, it lacks two crucial identifying features: the 5′ cap (a kind of molecular start button) and the 3′ poly-A tail, which protect and identify a normal mRNA.

Why so complicated?

Because it’s brilliant.With this molecular masquerade, the virus achieves two things:

Staying invisible: The (-)ssRNA is not immediately recognized as a threat by the cell’s immune system. If the viral genome were already in the form of mRNA, the cell’s alarm systems would be triggered right away.

Full control over production: The virus doesn’t beg for help from the host’s enzymes. Because only the virus’s own RNA polymerase can convert the (-)ssRNA into readable mRNA, the virus can precisely control:

➤ When mRNA is produced.

➤ How much of it is produced.

➤ Which segments are prioritized.In short: What looks like a cryptic puzzle is actually a highly precise control mechanism – a blueprint that only reveals itself when the viral machinery is ready – and the immune system is still asleep.

3️⃣ From (-)ssRNA to (+)ssRNA (the mRNA)

The viral polymerase is ready to transcribe the (-)ssRNA into readable mRNA – but the start button is missing. Without the 5′-cap, the machinery remains silent.

The solution? Theft at nano level.

This ingenious trick is called cap-snatching.

The Coup in Detail

The polymerase subunit PB2 prowls through the cellular mRNAs like a cunning thief searching for the most valuable jewel. Its target: the 5′ cap, the universal „seal” for cellular protein factories. Its accomplice, PB1 – the „molecular scissors” – cuts off the cap along with 10–15 nucleotides – a perfect primer for viral transcription. The stolen cap is attached to the viral RNA. The cell believes it has a legitimate mRNA and starts producing viral proteins. Meanwhile, the capped host mRNA is degraded – causing the collapse of the cell’s protein production.

At the same time, the viral mRNA receives a poly-A tail at its 3′ end, which stabilizes and protects it.

Why this trick is so brilliant

✅ Energy-saving: The virus uses existing resources – no effort needed to synthesize its own cap.

✅ Sabotage: The degradation of cellular mRNAs cripples the host’s defense.

✅ Camouflage: The stolen cap disguises viral mRNA as a „harmless” cellular message.The Consequences of the Heist

- The cell loses its own blueprints – and now produces viral proteins at full speed.

- The virus gains twice: rapid replication and weakening of its adversary.

This process is a classic in virology – a prime example of how viruses turn their host cells into puppets.

In the end, numerous „naked” +ssRNA strands are produced in the cell nucleus, which are used directly as mRNA for translation, i.e. for viral protein production and genome replication.

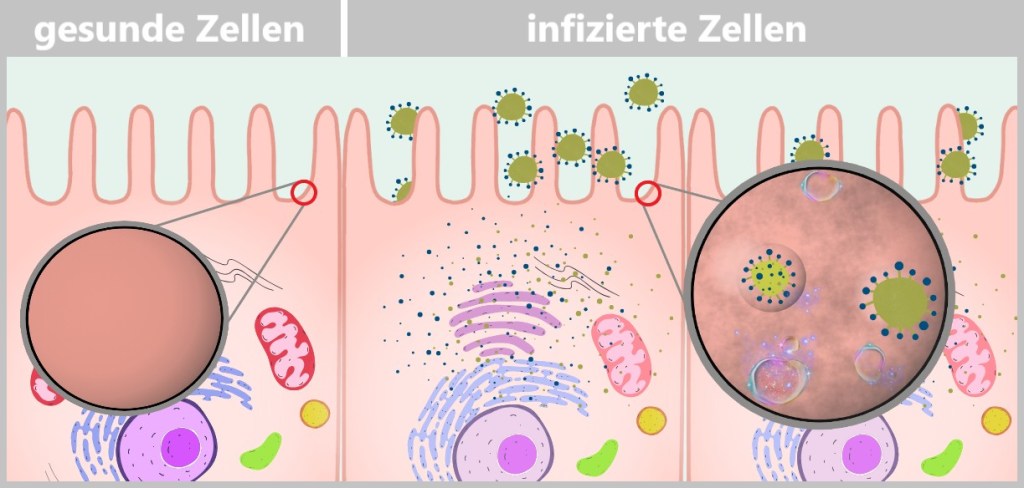

Figure 2-I: The viral RNA (-)ssRNA is transcribed into messenger RNA (mRNA). 4️⃣ The virus production is running hot

The freshly capped viral mRNAs exit the nucleus – equipped with a stolen signature and a poly-A tail. In the cytoplasm, ribosomes are waiting, unsuspectingly executing the enemy’s blueprints.

The prey: an entire protein factory

The ribosomes churn out viral proteins on an assembly line – including:Haemagglutinin (HA): The key to cell entry – the indispensable door opener.

Neuraminidase (NA): The liberator of new viruses – the sharp molecular scissors.

Matrix protein (M1): The stable envelope for the virus interior – the scaffold builder.

Ion channel protein (M2): The pH guardian – regulates the acidic environment in the virus.

RNA Polymerase (RNAP): The copying machine – a viral printing press.

Nucleoprotein (NP): The bodyguards – package and protect the RNA segments.

Nuclear Export Protein (NEP): The dispatcher – handles the export of viral RNPs from the nucleus.These freshly produced proteins are ready for the final act: the assembly of new virus particles.

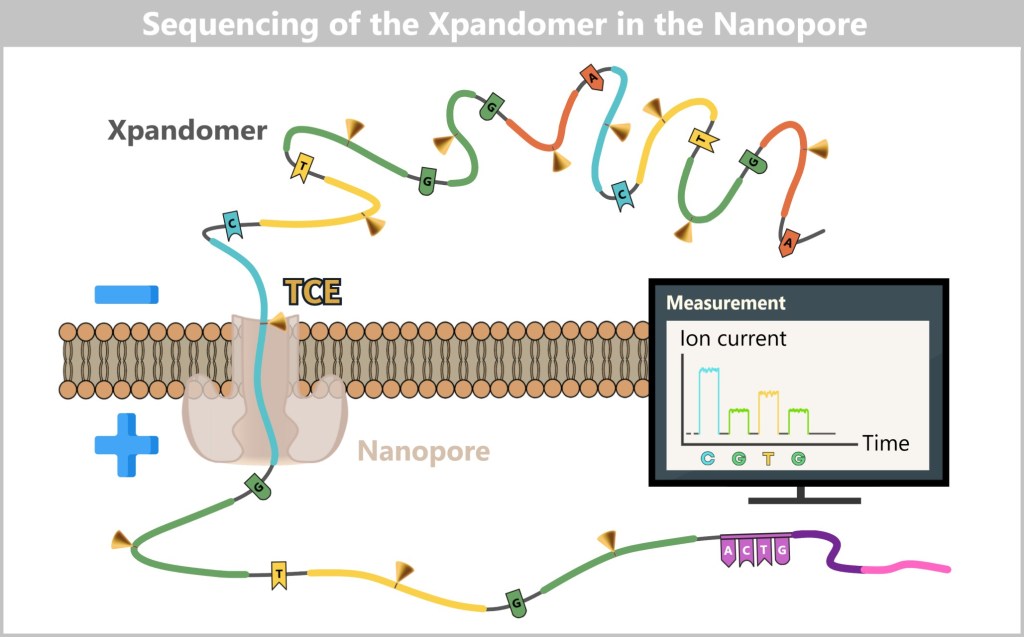

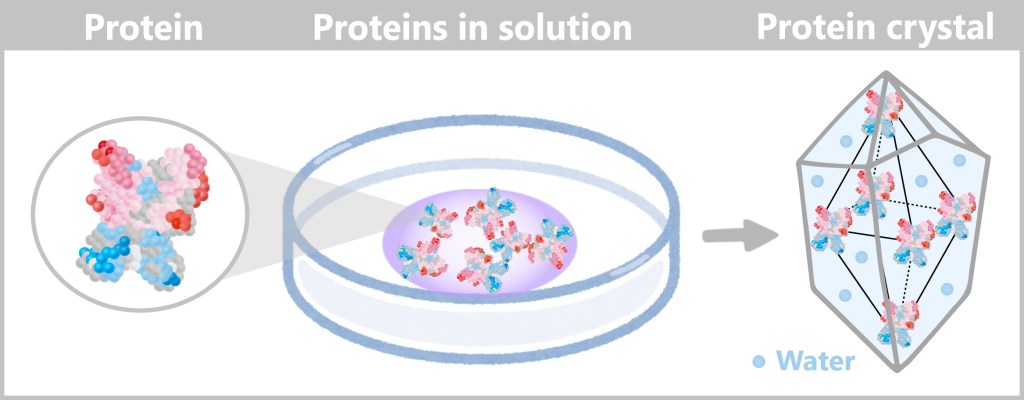

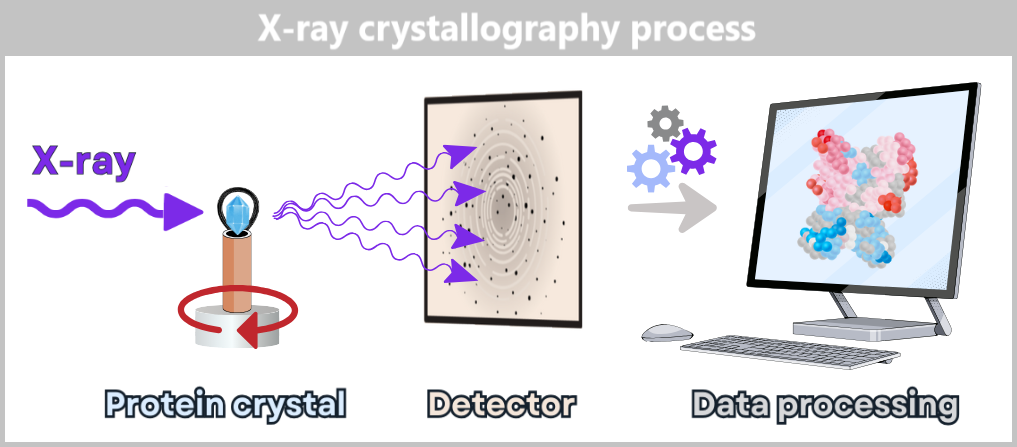

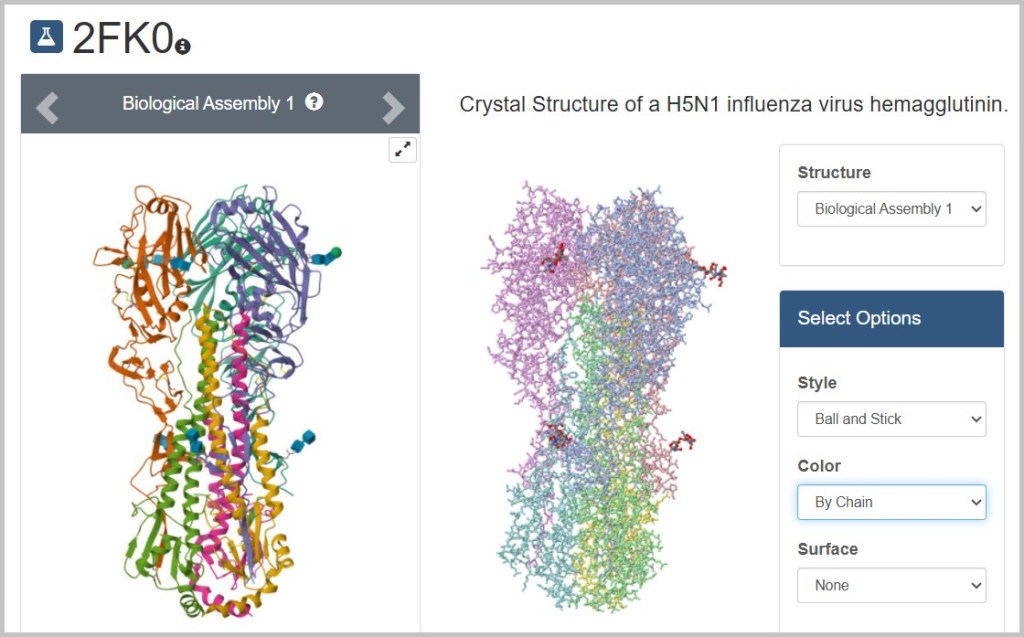

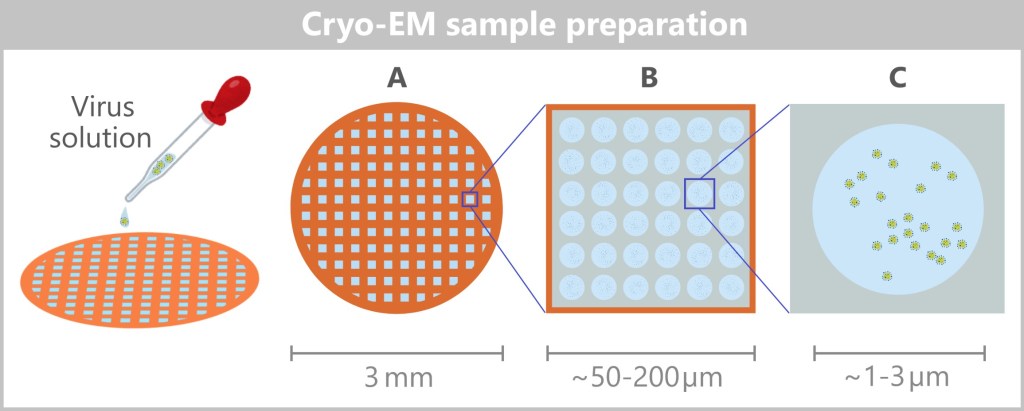

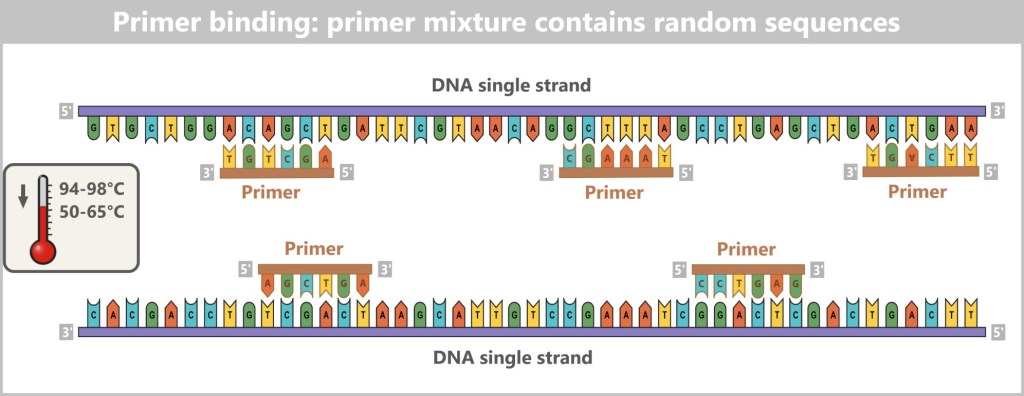

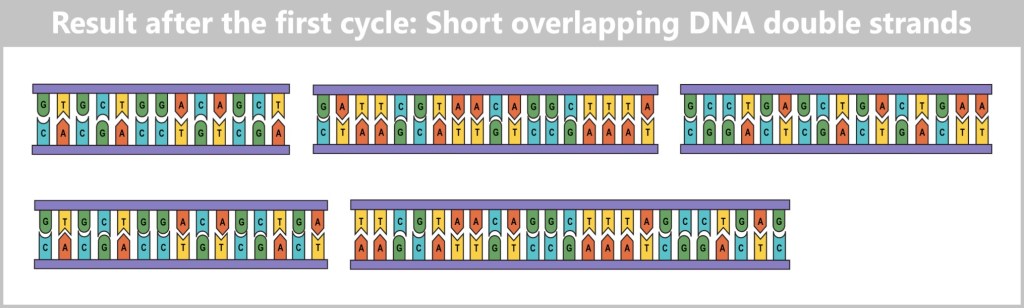

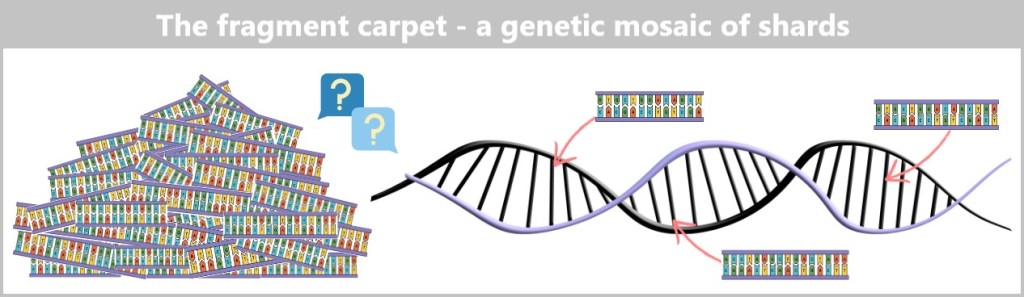

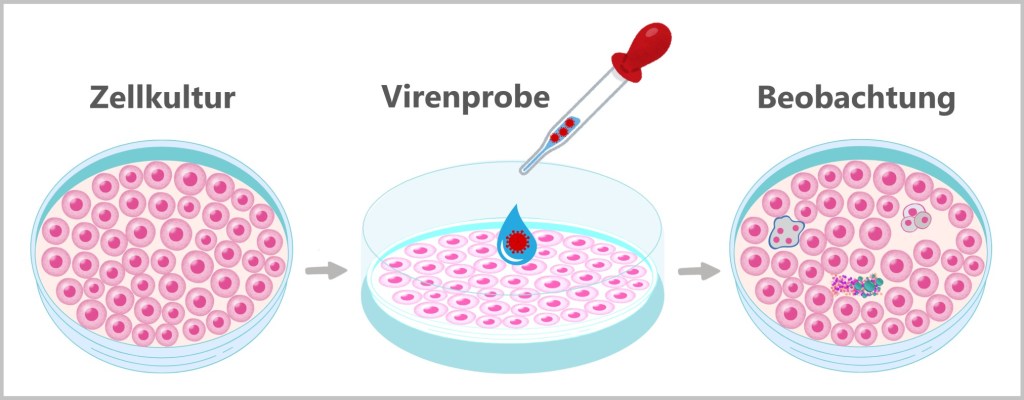

5️⃣ Return to the Nucleus