Als die HSBC Bank im Jahr 2013 im Rahmen ihrer globalen Kampagne „The future is full of opportunity“ an Flughäfen wie Gatwick und Dubai Plakate mit einem Fingerabdruck, einem QR-Code und dem provokanten Slogan „Your DNA will be your data“ platzierte, war die Botschaft unmissverständlich: Die Zukunft wird persönlich – vielleicht sogar beunruhigend persönlich. Die Bank wollte sich als zukunftsorientiertes Unternehmen positionieren, das Digitalisierung, Künstliche Intelligenz, Nachhaltigkeit und Genetik offensiv thematisiert.

Der Slogan wirkte doppeldeutig – als verheißungsvolle Vision ebenso wie als alarmierender Ausblick. Kritiker schlugen sofort Alarm: Deine DNA wird lesbar, analysierbar und digital verfügbar – ein offenes Buch über Herkunft, Gesundheitsrisiken, vielleicht sogar Persönlichkeitsmerkmale – vergleichbar mit biometrischen Daten wie Fingerabdrücken oder Gesichtsscans. Was einst als das Intimste am Menschen galt, wird nun zur Datei: maschinell entschlüsselbar, potenziell speicherbar, womöglich handelbar. Der Mensch wird reduziert auf Information – auf „Bits und Bytes“, die verarbeitet, verkauft oder missbraucht werden könnten.

Wer besitzt die Rechte an deinen genetischen Daten? Und wer hat Zugriff darauf? Du selbst? Die Firma, die den Test durchgeführt hat? Erreichen dadurch Überwachung, Datenlecks und Missbrauch durch staatliche und private Akteure eine neue Dimension? Die Vision von Designerbabys, genetischer Selektion und personalisierter Werbung auf Basis biologischer Marker wirft schwerwiegende ethische Fragen auf. Wird der Fortschritt am Ende mit dem Preis individueller Freiheit bezahlt?

Doch die Biotech-Revolution hat längst eine gewaltige Dynamik entfaltet, und immer mehr Stimmen erkennen in dieser Entwicklung ein enormes Potenzial. In der E-Book-Ausgabe der HSBC Bank Frontiers – Biotech – Five Big Ideas Shaping the Biotech Revolution von März 2024 heißt es:

„Die Idee, die Natur für Waren und Dienstleistungen zu nutzen, ist nicht neu. Doch in den 1970er Jahren, mit dem Aufkommen der Gentechnik und der Gründung der ersten Biotech-Unternehmen, begann die moderne Ära dieser Praxis. Dies brachte Wissenschaft und Wirtschaft zusammen wie nie zuvor, und der Kapitalzufluss beflügelte die Forschungs- und Entwicklungsbemühungen.

In den folgenden drei Jahrzehnten wurde das Feld durch bahnbrechende Geräte wie DNA-Sequenzierer und -Synthesizer beschleunigt, und die Biologie selbst wandelte sich langsam zu einer rechnergestützten, datengesteuerten Disziplin. Nach der Jahrtausendwende, als die Forscher immer größere Bereiche des menschlichen Genoms erfolgreich entschlüsseln konnten und die Kosten für die Sequenzierung dieses Genoms rapide sanken – von etwa 100 Millionen Dollar im Jahr 2001 auf weniger als 1.000 Dollar heute –, wurde das Potenzial der Biotechnologie, unser Leben zu verändern, auf elektrisierende Weise deutlich.

In den letzten Jahren wurden die Möglichkeiten der Biotechnologie – von der Behandlung genetisch bedingter Krankheiten bis zur Wiederbelebung ausgerotteter Tierarten – durch Fortschritte in ergänzenden Bereichen wie der künstlichen Intelligenz erweitert. Dies hat dazu beigetragen, dass in diesem Bereich ein neues Zeitalter angebrochen ist.“

Nirgendwo sonst prallen Nutzen und Risiko so direkt aufeinander wie in der personalisierten – oder präzisionsbasierten – Medizin. Ihr Anspruch: individuelle genetische und biologische Informationen zu nutzen, um Diagnosen zu präzisieren, Therapien zu individualisieren und Krankheiten frühzeitig zu erkennen. Die Vision ist vielversprechend: weniger Nebenwirkungen, bessere Heilungschancen, effizientere Prävention – Medizin, maßgeschneidert auf den Einzelnen.

Doch auch hier gilt: Was als medizinischer Fortschritt gefeiert wird, bringt gesellschaftliche, rechtliche und ethische Herausforderungen mit sich:

- Wer entscheidet, welche genetischen Daten relevant sind?

- Welche Rolle spielt der Zugang zu diesen Technologien – werden soziale Ungleichheiten dadurch vertieft?

- Und wie lassen sich Diskriminierung, etwa durch genetisches Scoring bei Versicherungen oder Arbeitgebern, verhindern?

Zwischen der Hoffnung auf individuelle Heilung und der Sorge vor kollektiver Entmündigung stehen grundlegende Fragen: Wird der Mensch durch den Zugriff auf seine biologischen Daten ermächtigt – oder entblößt? Ist personalisierte Medizin ein Segen – oder der Auftakt zu einer Ära subtiler Entmenschlichung?

Daher lautet die Gretchenfrage: Ist die personalisierte Medizin der verheißene Aufstieg in den Himmel – oder der Sturz durch die Tore der Hölle?

Dieser Blogbeitrag lädt dazu ein, die personalisierte Medizin in ihrer ganzen Komplexität zu betrachten – jenseits von Hype oder Alarmismus. Er richtet sich bewusst auch an fachfremde Leser, die sich kritisch mit den Chancen, Risiken und ethischen Spannungsfeldern dieser medizinischen Revolution auseinandersetzen möchten.

📑Inhaltsverzeichnis

1. Die begriffliche Einordnung und das grundlegende Paradigma

2. Treibende Kräfte – zwischen Vision und Wirklichkeit

3. Die Zukunft der Medizin beginnt in der Zelle

3.1. Wie Biologie und Technologie zusammenfinden

3.2. Daten, Verantwortung und der größere Rahmen

4. Von DNA zur Erkenntnis – ein Hochgeschwindigkeitszug der Innovation

4.1. Die DNA – Bauplan des Lebens

a) Die DNA: Das molekulare Informationsarchiv des Lebens

b) Vom Code zum Protein: Wie Anleitungen Wirklichkeit werden

c) Epigenetik & nicht-codierende DNA: Das Dirigenten-Team unseres Erbguts

d) Das verborgene Kontrollzentrum: Was die nicht-codierende DNA steuert

e) Wenn das Betriebssystem krank macht

f) Offene Rätsel der Forschung

g) Die wahre Magie der Gene

4.2. Genetische Variation und ihre Folgen

4.3. Genomsequenzierung: Schlüssel zum individuellen Erbgut

a) Die Reise der DNA: Vom Nabelschnurblut zur genetischen Information

b) Drei Regieanweisungen für die Gen-Diagnostik: WGS, WES und Panel

4.4. Methoden der Genomsequenzierung

4.4.1. Methode 1: Kopieren mit Leuchtfarbe

a) Sanger-Sequenzierung

b) Illumina-Technologie

c) Single-Molecule Real-Time(SMRT)-Sequenzierung

4.4.2. Methode 2: Hightech-Tunnel – DNA elektrisch abtasten

a) Oxford Nanopore Sequenzierung

4.4.3. Genomsequenzierung – Technologien im Vergleich

a) Durchsatz vs. Verwertbarkeit – Masse ist nicht immer gleich Klasse

b) Wirtschaftlichkeit – Kosten pro Base vs. Kosten pro Erkenntnis

c) Von der Probe zum Befund – Wie schnell spricht das ganze Genom?

d) Klinische Einsatzfelder – Welche Technologie passt wozu?

e) KI als Co-Pilot – Automatisierung ohne Verantwortung abzugeben

f) Vergleichstabelle: Sanger, Illumina, PacBio, ONT

g) Key Takeaways: Zwischen Reife und Routine

4.5. Genomsequenzierung: Der nächste Technologiesprung

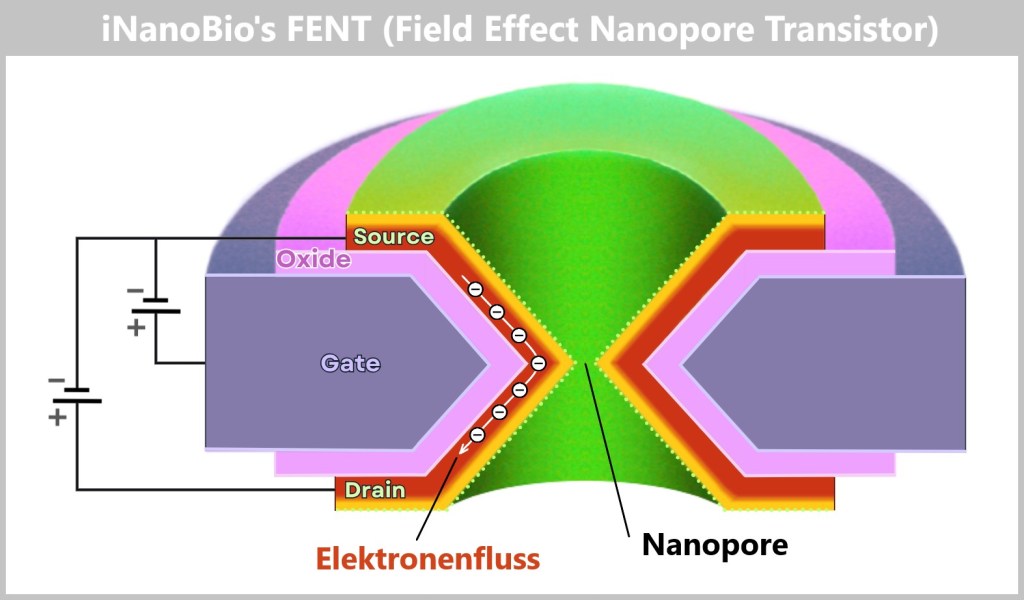

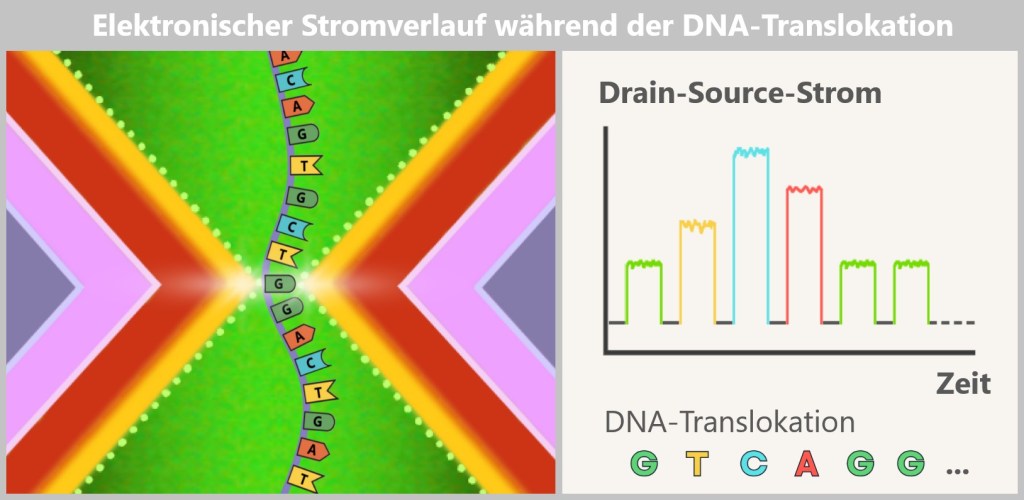

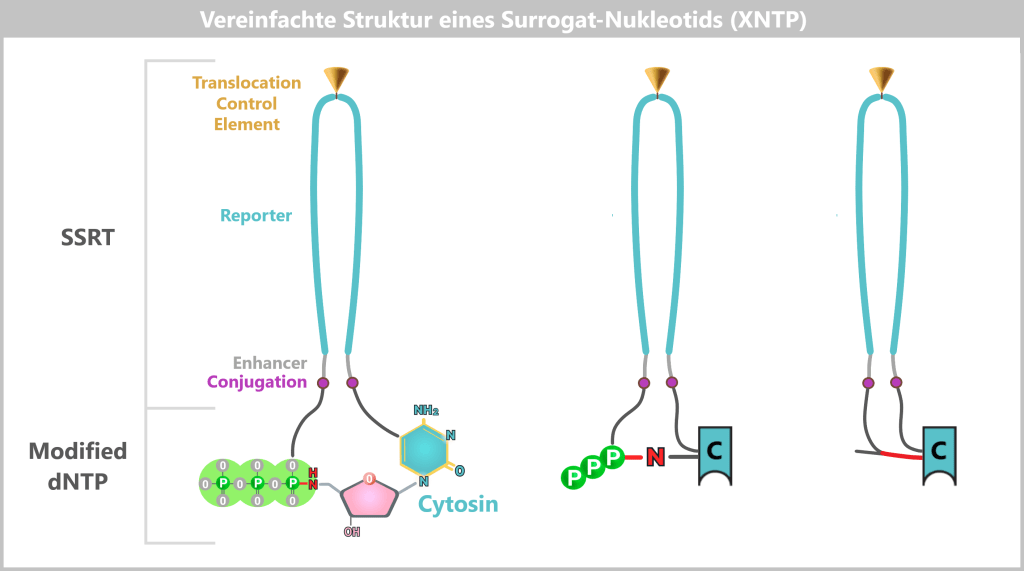

a) FENT: Wie ein Mikrochip die DNA-Analyse revolutioniert

b) SBX: Wenn DNA sich streckt, um verstanden zu werden

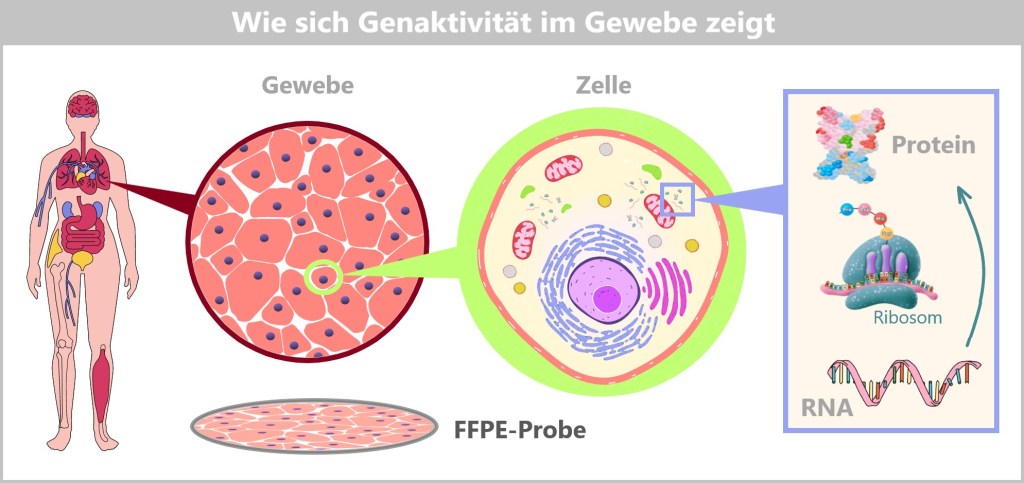

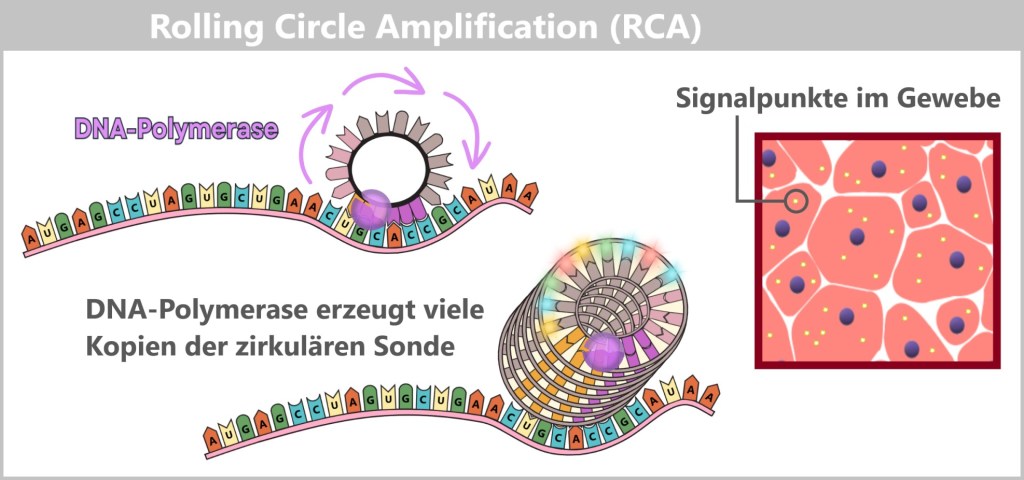

c) Das G4X-System: Vom genetischen Rezept zum räumlichen Atlas der Zelle

4.6. Vom Code zur Heilung – Bioinformatik als Schlüssel der Medizin von morgen

4.6.1. Vom genetischen Code zur computergestützten Genomanalyse

4.6.2. Moderne Bioinformatik – Der digitale Werkzeugkasten der Biologie

5. Eine Erfolgsgeschichte

6. Ein Blick in die Zukunft: Das Synthetic Human Genome Project

7. Personalisierte Medizin und Smart Governance

7.1. Macht, Governance und Smart Governance

7.2. Gouvernementalität

7.3. Personalisierte Medizin als Katalysator biomolekularer Gouvernementalität

7.4. Der weltweite Trend: Globale biomolekulare Gouvernementalität

7.5. Schlussfolgerung: Globale Ambivalenz der biomolekularen Macht

8. Epilog

1. Die begriffliche Einordnung und das grundlegende Paradigma

Die Entwicklung der modernen Medizin hin zu maßgeschneiderten Behandlungen wird häufig mit Begriffen wie „personalisierte Medizin“, „individualisierte Therapie“ oder „Präzisionsmedizin“ beschrieben. Doch was genau verbirgt sich hinter diesen Schlagworten?

Personalisierte Medizin gilt derzeit als einer der populärsten Begriffe – eingängig wie ein Werbeslogan. Damit verbunden ist das Versprechen, Therapien auf jeden Menschen zuzuschneiden: auf seine Gene, seine Lebensgewohnheiten, seine Biologie. In den Medien und in der öffentlichen Debatte wird der Ausdruck entsprechend häufig verwendet.

Individualisierte Therapie klingt weniger glamourös, meint aber Ähnliches: die Anpassung von Medikamenten oder Dosierungen an die Bedürfnisse einzelner Patienten. Dieser Begriff findet vor allem im klinischen Alltag Verwendung.

Präzisionsmedizin schließlich ist der nüchternste der drei Begriffe – ein Fachwort, das in Forschungslaboren und wissenschaftlichen Publikationen dominiert. Es unterstreicht den datenbasierten Ansatz: Algorithmen, Genanalysen und Biomarker entscheiden darüber, welche Therapie bei welcher Patientengruppe wirkt. Das ist die Sprache der Wissenschaft.

Doch egal, welcher Begriff gewählt wird – sie alle stehen für einen Paradigmenwechsel: Weg von standardisierten Verfahren – hin zu einer Medizin, die den einzelnen Menschen in seiner biologischen Einzigartigkeit in den Mittelpunkt stellt.

2. Treibende Kräfte – zwischen Vision und Wirklichkeit

Die treibenden Kräfte hinter der personalisierten Medizin sind vielfältig und eng miteinander verflochten. Auf der einen Seite stehen wissenschaftlich-technologische Entwicklungen, die in den letzten Jahrzehnten enorme Fortschritte ermöglicht haben: neue Methoden, um Erbgut schnell und genau zu lesen, leistungsfähige Datenanalyse durch künstliche Intelligenz sowie die Verfügbarkeit großer biomedizinischer Datenmengen. Diese Technologien bilden die Grundlage dafür, individuelle Unterschiede zwischen Patienten überhaupt erst erkennen und medizinisch nutzen zu können.

Auf der anderen Seite wirken gesellschaftliche und politische Impulse als Beschleuniger dieses Wandels. Öffentliche Gesundheitsprogramme, gezielte Forschungsförderung, Strategiepapiere internationaler Gesundheitsorganisationen und gezielte Gesetzesinitiativen treiben die Integration der personalisierten Medizin in die Versorgungspraxis aktiv voran. Auch das gestiegene Gesundheitsbewusstsein in der Bevölkerung sowie die zunehmende Erwartung an individuelle Behandlungsangebote verstärken diesen Trend.

Personalisierte Medizin ist also kein bloßes Produkt technologischer Machbarkeit, sondern entsteht im Spannungsfeld von Innovation, Politik und gesellschaftlicher Nachfrage.

Ein aktuelles Beispiel für die praktische Umsetzung dieser Entwicklung liefert das Vereinigte Königreich: Im Rahmen eines neuen 10-Jahres-Plans soll künftig jedes Neugeborene einem DNA-Test unterzogen werden. Die sogenannte Ganzgenomsequenzierung soll nach hunderten genetisch bedingten Krankheiten suchen – mit dem Ziel, potenziell tödliche Erkrankungen frühzeitig zu erkennen und ihnen gezielt vorzubeugen. Nach Angaben des britischen Gesundheitsministers Wes Streeting geht es darum, den National Health Service (NHS) grundlegend zu transformieren: weg von der reinen Krankheitsbehandlung – hin zu einem System der Vorhersage und Prävention. Genomik, also die umfassende Analyse der Erbinformation, soll dabei in Kombination mit künstlicher Intelligenz als Frühwarnsystem dienen.

„Die Revolution in der medizinischen Wissenschaft bedeutet, dass wir den NHS von einem Dienst, der Krankheiten diagnostiziert und behandelt, in einen Dienst verwandeln können, der sie vorhersagt und verhindert“, so Streeting. Die Vision: eine personalisierte Gesundheitsversorgung, die Risiken erkennt, bevor Symptome überhaupt auftreten – und damit die Lebensqualität verbessert sowie das Gesundheitssystem entlastet.

Doch so überzeugend diese Vision auch klingt – aus der Wissenschaft kommen auch mahnende Stimmen. So warnt etwa der Genetiker Prof. Robin Lovell-Badge vom Francis Crick Institute davor, die Komplexität der genomischen Daten zu unterschätzen. Es brauche nicht nur technisches Know-how zur Datenerhebung, sondern vor allem qualifiziertes Personal, das die gewonnenen Informationen verantwortungsvoll und verständlich kommunizieren kann. Denn Daten allein sind noch keine Diagnose – entscheidend ist ihre sinnvolle und patientengerechte Interpretation.

Was bedeutet es konkret, Medizin neu zu denken?

Die wahre Revolution spielt sich in den Laboren und Rechenzentren ab, in denen die Bausteine der personalisierten Medizin entstehen. Die folgenden Kapitel führen Schritt für Schritt hinter die Kulissen und zeigen die Schlüsseltechnologien, die nötig sind, um die personalisierte Medizin vom Konzept in die Klinik zu bringen.

3. Die Zukunft der Medizin beginnt in der Zelle

3.1. Wie Biologie und Technologie zusammenfinden

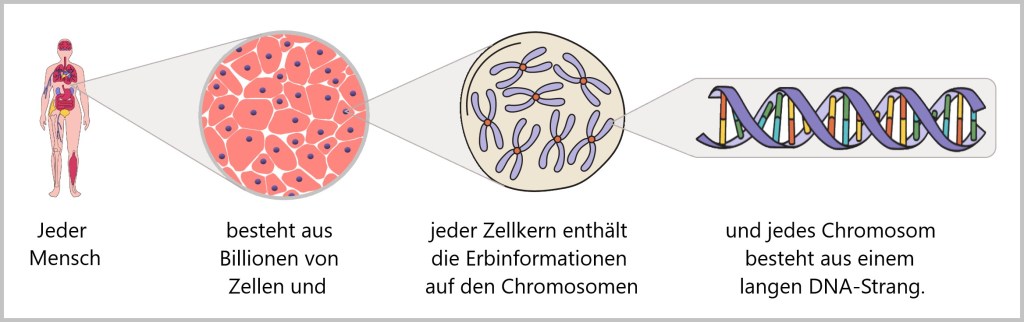

Unser Körper besteht aus Milliarden Zellen – winzigen, spezialisierten Einheiten, die Tag für Tag zusammenarbeiten, um Gesundheit und Leben zu ermöglichen. In jeder einzelnen Zelle laufen unzählige Prozesse ab, die genau aufeinander abgestimmt sind. Diese zellulären Mechanismen sind entscheidend für das Verständnis von Gesundheit, Krankheit und der Entwicklung neuer, gezielter Therapien.

Ein zentraler Mechanismus ist die Energiegewinnung: Zellen verwandeln Nährstoffe und Sauerstoff in ATP (Adenosintriphosphat)– die „Energie-Währung“ des Körpers. Ohne ATP könnte keine Zelle funktionieren, kein Muskel sich bewegen, kein Gedanke entstehen.

Gleichzeitig produzieren Zellen fortwährend Proteine – auf Basis genetischer Informationen. Diese komplexen Moleküle übernehmen zentrale Aufgaben im Körper – als chemische Katalysatoren, Botenstoffe, Baustoffe oder Transportmoleküle.

Auch die Reinigung und Erneuerung innerhalb der Zelle ist lebenswichtig: Prozesse wie die Autophagie bauen beschädigte Zellbestandteile ab und recyceln sie – eine Art innere Müllabfuhr, die Krankheiten wie Alzheimer oder Parkinson vorbeugen kann.

Damit Zellen im Körper koordiniert zusammenarbeiten können, brauchen sie funktionierende Signalwege – sie „kommunizieren“ über chemische Botenstoffe miteinander. Diese Zellkommunikation steuert, wann Zellen wachsen, ruhen oder auf Veränderungen reagieren sollen.

Ein weiterer zentraler Vorgang ist die Zellteilung – notwendig für Wachstum, Wundheilung und Gewebeerneuerung. Gleichzeitig sorgen DNA-Reparaturmechanismen dafür, dass Fehler im Erbgut korrigiert werden. Gelingt das nicht, greift die Apoptose, der programmierte Zelltod, um Schäden zu begrenzen.

All diese Mechanismen laufen im Hintergrund ab – ständig und hochpräzise. Wenn jedoch einer dieser Abläufe gestört ist, kann das zu schweren Erkrankungen führen, etwa Krebs, Autoimmunerkrankungen oder Stoffwechselstörungen. Genau hier setzt die personalisierte Medizin an. Sie nutzt modernste Technologien, um diese zellulären Prozesse besser zu verstehen und gezielt zu beeinflussen.

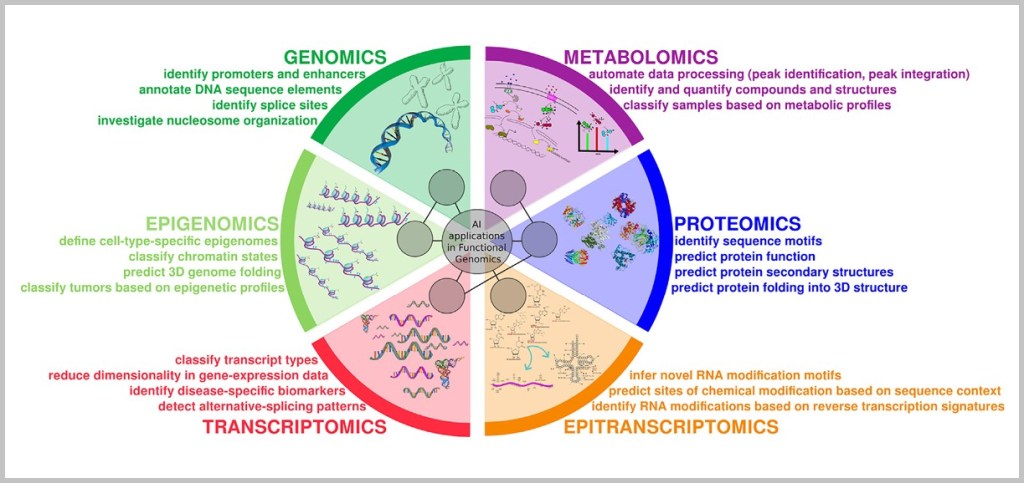

Dank Genomsequenzierung (etwa durch „Next Generation Sequencing“) lassen sich genetische Veränderungen identifizieren, die z. B. die Proteinproduktion oder Reparaturmechanismen beeinflussen.

Biomarker-Analysen (die Analyse bestimmter Moleküle)im Blut, Gewebe oder anderen Körperflüssigkeiten zeigen, ob bestimmte Signalwege über- oder unteraktiv sind – und helfen dabei, individuelle Krankheitsverläufe vorherzusagen oder passende Therapien auszuwählen.

Die Einzelzellanalytik ermöglicht es, Unterschiede selbst zwischen einzelnen Zellen sichtbar zu machen – etwa in einem Tumor, wo manche Zellen auf eine Therapie ansprechen und andere nicht. Dadurch wird eine präzisere Behandlung möglich.

Auch die Proteomik (Analyse aller Proteine in einer Zelle) und Metabolomik (Analyse von Stoffwechselprodukten) liefern ein aktuelles Bild davon, wie aktiv bestimmte zelluläre Mechanismen wirklich sind – z. B. ob eine Zelle gestresst ist, ausreichend Energie hat oder sich gerade teilt.

Künstliche Intelligenz (KI) hilft dabei, diese riesigen Datenmengen zu analysieren und Muster zu erkennen – zum Beispiel, welche Kombination von zellulären Störungen typisch für eine bestimmte Krebserkrankung ist. Digitale Gesundheitsdaten (etwa aus Wearables) ergänzen dieses Bild im Alltag und ermöglichen eine präzise Langzeitbeobachtung.

Sogar neue Therapieansätze beruhen auf dem Verständnis zellulärer Abläufe: Gentherapien und CRISPR-basierte Gen-Editierung greifen gezielt in die DNA ein, um fehlerhafte Mechanismen zu korrigieren. In Organoiden – Mini-Organmodellen im Labor – lassen sich Medikamente direkt an patientenspezifischen Zellmodellen testen, ganz ohne Risiko für den Menschen.

Moderne Technologien machen heute sichtbar, was früher im Verborgenen lag: Wie Zellen arbeiten, was bei Krankheit aus dem Gleichgewicht gerät – und wie man gezielt eingreifen kann. So entsteht eine individualisierte Medizin, die nicht mehr auf Vermutung basiert, sondern auf messbarer Biologie.

Diese neue Präzision bringt nicht nur Chancen, sondern auch neue Verantwortlichkeiten mit sich.

3.2. Daten, Verantwortung und der größere Rahmen

Die Komplexität dieser zellulären Prozesse spiegelt sich unmittelbar in der Komplexität der personalisierten Medizin wider: Je genauer wir die feinen Abläufe und Wechselwirkungen in unseren Zellen verstehen, desto gezielter – aber auch anspruchsvoller – werden Diagnose und Therapie. Diese neue Präzision erfordert neue Technologien, neue Denkweisen und ein tiefes biologisches Verständnis. Gleichzeitig eröffnet sie die Chance auf wirksamere, nachhaltigere und maßgeschneiderte Behandlungskonzepte.

Doch je gezielter und tiefer diese Eingriffe werden, desto größer ist auch die Verantwortung – und die Herausforderung, unerwünschte Langzeitwirkungen oder Nebenreaktionen frühzeitig zu erkennen und zu beherrschen. Gerade bei innovativen Verfahren wie Gentherapie oder Immunmodulation gilt es, den Nutzen sorgfältig gegen mögliche Risiken abzuwägen. Die personalisierte Medizin verlangt daher nicht nur Präzision, sondern auch Weitblick.

Ein zentrales Element dieses Weitblicks ist die Verfügbarkeit personenbezogener Gesundheitsdaten – und zwar nicht nur im Einzelfall, sondern im großen Maßstab.

Erst durch die Kombination individueller Daten mit Bevölkerungsdaten wird es möglich, biologische Prozesse im Detail zu verstehen, Krankheitsverläufe vorherzusagen und personalisierte Therapien zu entwickeln. Genetische Informationen, Laborwerte, Bildgebungsdaten oder digitale Alltagsmessungen liefern Hinweise darauf, wie zelluläre Mechanismen bei einem Menschen konkret funktionieren – und wie sie bei anderen variieren.

Um diese individuellen Muster medizinisch einzuordnen, braucht es den Vergleich mit großen Datensätzen. Nur so können KI-Systeme komplexe Zusammenhänge erkennen, die dem menschlichen Auge entgehen – etwa seltene Genvarianten, molekulare Risikokonstellationen oder unerwartete Therapieeffekte. Dabei gilt: Je größer und vielfältiger die Datenbasis, desto zuverlässiger die Modelle – besonders, wenn sie laufend mit neuen Informationen angereichert werden.

Doch diese Fortschritte gelingen nur, wenn Menschen bereit sind, ihre Gesundheitsdaten zu teilen – und darauf vertrauen können, dass sie sicher und verantwortungsvoll genutzt werden.

Die Zukunft der Medizin beginnt dort, wo alles Leben entsteht: in der Zelle. Doch ihr Erfolg hängt ab vom Zusammenspiel dreier Kräfte: technologischer Innovation, wissenschaftlicher Tiefe – und ethischer Verantwortung.

4. Von DNA zur Erkenntnis – ein Hochgeschwindigkeitszug der Innovation

Wie Genomsequenzierung und bioinformatische Analyse die Medizin revolutionieren

4.1. Die DNA – Bauplan des Lebens

a) Die DNA: Das molekulare Informationsarchiv des Lebens

b) Vom Code zum Protein: Wie Anleitungen Wirklichkeit werden

c) Epigenetik & nicht-codierende DNA: Das Dirigenten-Team unseres Erbguts

d) Das verborgene Kontrollzentrum: Was die nicht-codierende DNA steuert

e) Wenn das Betriebssystem krank macht

f) Offene Rätsel der Forschung

g) Die wahre Magie der Gene

4.2. Genetische Variation und ihre Folgen

4.3. Genomsequenzierung: Schlüssel zum individuellen Erbgut

a) Die Reise der DNA: Vom Nabelschnurblut zur genetischen Information

b) Drei Regieanweisungen für die Gen-Diagnostik: WGS, WES und Panel

4.4. Methoden der Genomsequenzierung

4.4.1. Methode 1: Kopieren mit Leuchtfarbe

4.4.2. Methode 2: Hightech-Tunnel – DNA elektrisch abtasten

4.4.3. Genomsequenzierung – Technologien im Vergleich

4.5. Genomsequenzierung: Der nächste Technologiesprung

4.6. Vom Code zur Heilung: Bioinformatik als Schlüssel der Medizin von morgen

Stellen Sie sich vor, Sie stehen am Bahnsteig, und ein Zug rauscht mit solch einer Geschwindigkeit vorbei, dass kaum ein Bild im Fenster zu erkennen ist. So ähnlich empfinden viele Menschen die Entwicklungen in der personalisierten Medizin: Technologien kommen in rasantem Tempo, Begriffe wirken abstrakt – und doch zieht sich durch alles ein roter Faden: das menschliche Genom.

So vielfältig die modernen Ansätze auch sind – von Organoiden über CRISPR-basierte Gen-Editierung bis zu RNA-Medikamenten – im Zentrum steht der genetische Bauplan des Menschen. Die Genomsequenzierung ist heute Grundlage vieler Diagnosen und Therapieentscheidungen. Sie zeigt, welche genetischen Veränderungen Krankheiten auslösen, welche Signalwege betroffen sind – und wo gezielte Eingriffe möglich sein könnten.

Was einst Milliarden kostete und Jahre dauerte, gelingt heute in wenigen Tagen: Das gesamte Erbgut eines Menschen kann entschlüsselt werden. Doch die reine Sequenz ist noch kein Befund. Die Abfolge von drei Milliarden Basenpaaren entfaltet erst dann medizinischen Wert, wenn sie auch verstanden wird – und genau hier beginnt die eigentliche Herausforderung.

Die Bioinformatik betritt die Bühne: ein interdisziplinäres Feld, das Mathematik, Informatik und Biologie vereint, um aus Rohdaten Muster, Risiken und Therapieoptionen abzuleiten. Sie ist das eigentliche Nadelöhr der personalisierten Medizin – denn sie entscheidet, ob genetische Varianten als harmlos, risikobehaftet oder krankheitsverursachend gelten.

Dazu werden individuelle Sequenzen mit internationalen Referenzdatenbanken abgeglichen, Algorithmen analysieren Millionen genetischer Varianten, und lernende Systeme modellieren das komplexe Zusammenspiel von Genetik, Umwelt und Stoffwechsel.

Dieser Prozess ist hochkomplex – und zugleich essenziell. Denn erst die rechnergestützte Auswertung macht die DNA medizinisch nutzbar. Zwischen Genomsequenzierung und bioinformatischer Analyse besteht eine untrennbare Symbiose: Die Sequenz liefert die Daten, die Analyse das Verständnis. Ohne sie bleibt die DNA eine bloße Aneinanderreihung von Buchstaben.

Genau deshalb richtet sich der Blick der folgenden Abschnitte auf die entscheidende Frage:

Was heißt es, das Genom zu entschlüsseln – und es wirklich zu verstehen?

Welche Aussagen sind möglich – und wo liegen ihre Grenzen?

Denn wer die Zukunft der Medizin begreifen will, muss wissen, wie wir heute das menschliche Erbgut lesen – und wie wir lernen, es zu deuten.

Der Hochgeschwindigkeitszug der Innovation ist längst abgefahren. Wer mitfahren will, muss verstehen, wohin er führt.

4.1. Die DNA – Bauplan des Lebens

Um diese Reise anzutreten, lohnt ein kurzer Blick auf die molekularen Grundlagen: Wie unsere DNA zur Bauanleitung wird, wie daraus über den Umweg der RNA Proteine entstehen – und wie die Epigenetik diese Prozesse feinjustiert. Erst dieses Fundament macht verständlich, was beim Entschlüsseln des Genoms eigentlich passiert.

a) Die DNA: Das molekulare Informationsarchiv des Lebens

In jeder Zelle unseres Körpers liegt sorgfältig verpackt ein beeindruckendes Molekül: die DNA (Desoxyribonukleinsäure). Sie enthält die vollständige Bau- und Funktionsanleitung unseres Körpers – ein molekulares Informationsarchiv des Lebens.

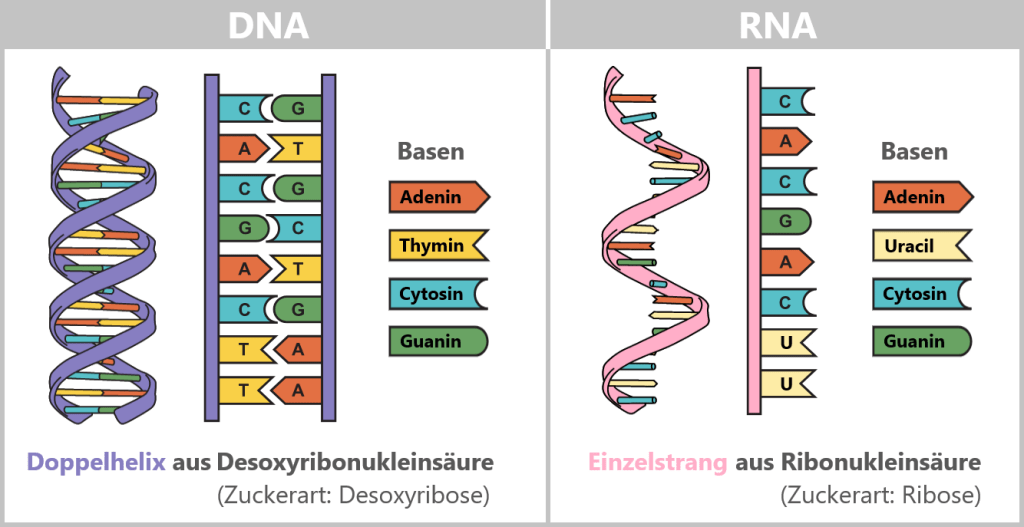

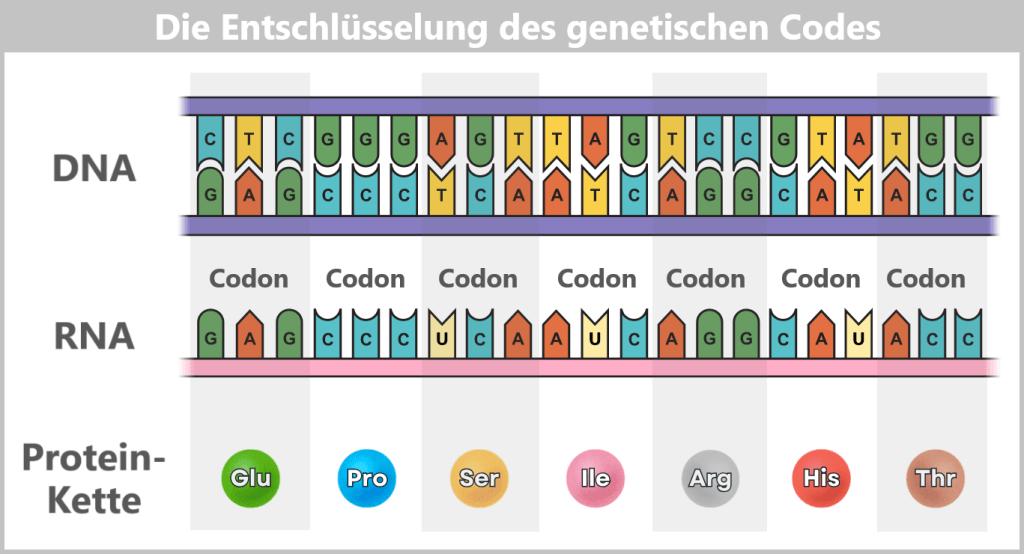

Strukturell gleicht sie einer spiralförmig verdrehten Strickleiter: Zwei Zucker-Phosphat-Ketten bilden die Seiten, dazwischen liegen die „Sprossen“ – die Basen Adenin (A), Cytosin (C), Guanin (G) und Thymin (T). Sie paaren sich stets nach festen Regeln: A mit T, C mit G. Diese komplementäre Bindung macht jeden Strang zur Vorlage für den anderen – ein molekulares Backup-System.

Entrollt man die DNA aus nur einer einzigen Zelle, misst sie rund zwei Meter – bei einem Durchmesser von nur wenigen Millionstel Millimetern. Das Leben hängt also buchstäblich an einem hauchdünnen, aber erstaunlich langen Faden.

Die Abfolge der rund drei Milliarden Basenpaare ist so individuell wie ein Fingerabdruck. Sie bildet den genetischen Code – die Anweisungen zur Herstellung von Proteinen, jenen Molekülen, die Struktur, Funktion und Regulation aller biologischen Prozesse steuern.

Als zentrales Informationsarchiv ist die DNA zugleich äußerst wertvoll und empfindlich. Deshalb wird sie sicher im Zellkern aufbewahrt, vergleichbar mit einem Safe. Damit der Körper auf die Informationen in diesem Safe zugreifen kann, braucht es ein cleveres Transportsystem. Schließlich müssen die Baupläne für Proteine – jene molekularen Architekten aller Lebensprozesse – zu den Ribosomen gelangen, den sogenannten „Protein-Fabriken“ im Zellplasma. Dort werden die Proteine hergestellt – ein Prozess, den man als Proteinbiosynthese bezeichnet.

Doch wie kommt ein konkreter Bauplan sicher aus dem Zellkern zu diesen Fabriken? Mit anderen Worten: Wie wird die genetische Information für ein bestimmtes Protein vom geschützten Archivort an den Ort der Produktion übertragen?

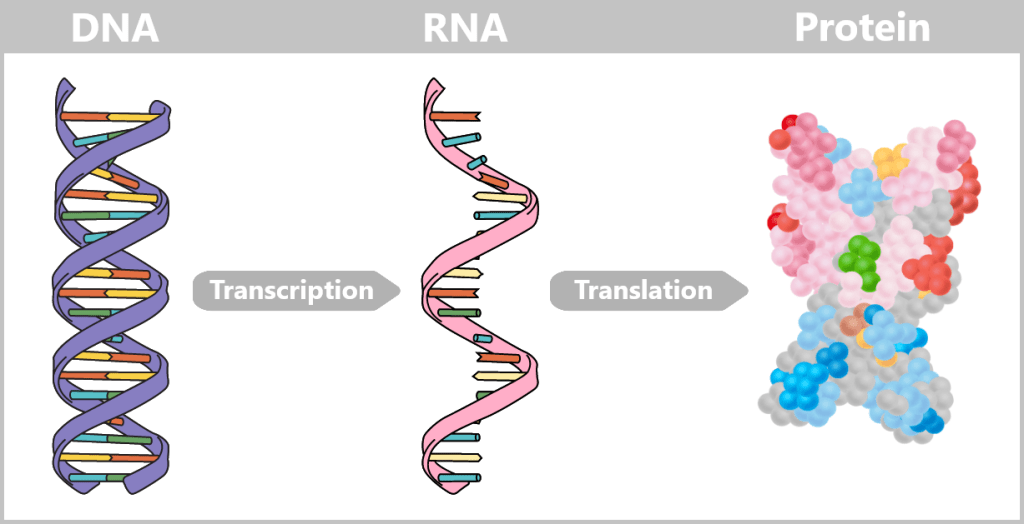

b) Vom Code zum Protein: Wie Anleitungen Wirklichkeit werden

Die Reise beginnt bei den Genen – bestimmten Abschnitten der DNA, die die Baupläne für Proteine enthalten. Etwa 20.000 solcher Gene finden sich im menschlichen Genom.

Die DNA ist dabei nicht nur ein passives Informationsarchiv im Zellkern – sie enthält ein aktives Repertoire an Anleitungen. Man kann sich jedes Gen wie ein Kapitel in einem molekularen Kochbuch vorstellen: nicht selten mit mehreren Varianten eines Rezepts, angepasst an Zelltyp, Entwicklungsstand oder äußere Bedingungen.

Zunächst entsteht eine temporäre „Arbeitskopie“ eines Gens – in Form von RNA (Ribonukleinsäure). Sie ähnelt der DNA, verwendet jedoch die Base Uracil (U) anstelle von Thymin (T) und besteht meist nur aus einem einzelnen Strang. Diese flüchtige Struktur macht die RNA ideal für den kurzfristigen Gebrauch – sie wird nach Erfüllung ihrer Funktion wieder abgebaut.

Alternatives Splicing: Die flexible Küche der Gene

Zellen müssen sich flexibel an wechselnde Anforderungen anpassen: auf Entzündungen reagieren, Krankheitserreger abwehren, Muskeln aufbauen oder den Blutzuckerspiegel regulieren. Dafür braucht es keine starre Anleitung, sondern ein System, das je nach Situation improvisieren kann.

In Abhängigkeit vom Zelltyp und äußeren Signalen wird der RNA-Strang dynamisch umgebaut, indem er an bestimmten Markierungen – übertragen aus der DNA – geschnitten wird. Nicht benötigte Abschnitte (Introns) werden entfernt, die verbleibenden (Exons) neu zusammengesetzt. So entsteht aus einer Vorlage eine Vielzahl möglicher Botschaften. Das Ergebnis ist die messenger RNA (mRNA), die die genetische Information aus dem Zellkern zu den Ribosomen im Zytoplasma bringt – den „Protein-Fabriken“ der Zelle.

Man kann sich diesen Prozess vorstellen wie das Nachkochen eines Rezepts: je nach Bedarf lässt die Zelle Zutaten weg, fügt Gewürze hinzu oder passt die Zubereitungsschritte an. So wird aus einer Grundanleitung eine Vielfalt von Gerichten.

Durch diesen Prozess – genannt alternatives Splicing – können Zellen aus einem Gen eine Vielzahl unterschiedlicher Proteine herstellen, die jeweils spezifische Funktionen übernehmen.

Der gesamte Vorgang „Vom Gen zum Protein“ wird häufig als Genexpression bezeichnet.

💡 Beispiel: Das Titin-Gen

👉 Längstes menschliches Gen (≈ 300.000 Basenpaare).

👉 Durch alternatives Splicing entstehen > 20.000 verschiedene Proteinvarianten – jeweils angepasst an die unterschiedlichen Anforderungen in verschiedenen Muskeltypen.

Unser Erbgut ist also kein starres Rezeptbuch – es ist eine dynamische Küche, in der die Zelle aus denselben Vorlagen immer neue Lösungen entwickelt.

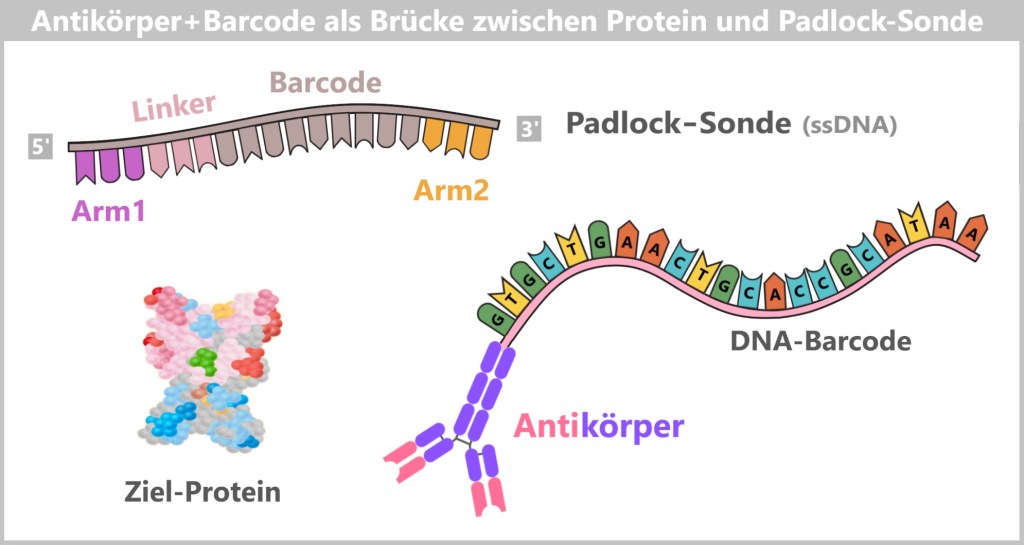

📌 Wer sich dafür interessiert, wie die Erbinformation in der DNA Schritt für Schritt in ein Protein übersetzt wird, findet hier weiterführende Informationen.

Doch wie in jeder kreativen Küche können auch hier beim Übergang der DNA zur mRNA Fehler passieren: Wird beim Abschreiben oder Montieren ein „Zutatenbuchstabe“ übersehen, vertauscht oder falsch zusammengesetzt, kann die Botschaft am Ende missverständlich oder unbrauchbar werden. Solche Mutationen oder fehlerhaftes Splicing sind manchmal harmlos – doch sie können auch defekte Proteine hervorbringen, die ihre Aufgabe nicht erfüllen oder sogar Schaden anrichten. Ein kleiner Patzer in der Abschrift des molekularen Kochbuchs – und der Geschmack des Lebens verändert sich.

c) Epigenetik & nicht-codierende DNA: Das Dirigenten-Team unseres Erbguts

Obwohl alle Zellen die gleiche DNA enthalten, nutzen sie jeweils nur einen Bruchteil davon. Eine Leberzelle benötigt andere Anleitungen als eine Nervenzelle – der Rest bleibt stillgelegt. Diese gezielte Genregulation wird durch epigenetische Mechanismen gesteuert: Kleine chemische Markierungen – etwa Methylgruppen – verändern nicht die genetische Sequenz selbst, sondern beeinflussen, ob ein Gen aktiv ist, wie oft es abgelesen wird oder ob es komplett stummgeschaltet bleibt.

Doch wer gibt dem Dirigenten eigentlich seine Anweisungen? Hier kommt die nicht-codierende DNA ins Spiel – 98 % unseres Erbguts, lange als nutzloser „Ballast“ abgetan. Sie ist das Betriebssystem, das die epigenetischen Schaltpläne bereitstellt. Erst ihr Zusammenspiel legt fest, wann, wo und wie stark unsere Gene aktiv werden – und entscheidet so über Gesundheit oder Krankheit.

d) Das verborgene Kontrollzentrum: Was die nicht-codierende DNA steuert

In diesen „dunklen“ Regionen verbergen sich präzise Schaltkreise, die das Schicksal jeder Zelle lenken:

Enhancer wirken wie unsichtbare Fernbedienungen der Gene. Selbst über Tausende Bausteine hinweg können sie ein Zielgen aktivieren oder zum Schweigen bringen – etwa für die Herzentwicklung im Embryo.

Telomere sind die Schutzkappen der Chromosomenenden, wie Plastikhüllen an Schnürsenkeln. Doch wenn sie schrumpfen, beginnt das Altern – ein zentraler Mechanismus von Zellverfall und Krebsentstehung.

Nicht-codierende RNAs agieren als heimliche Regisseure: Mikro-RNAs blockieren krankmachende Gene, während die lange RNA XIST bei Frauen ein gesamtes X-Chromosom zum Schweigen bringt.

Epigenetische Markierungen legen eine unsichtbare Landkarte über das Genom. Mit Methylierungen wie roten Stoppschildern entscheiden sie, ob ein Enhancer oder Gen gelesen werden darf – oder verstummt.

So entsteht Ordnung im molekularen Kochbuch: Jeder Zelltyp liest nur die Seiten, die er braucht – gesteuert durch nicht-codierende DNA und ihre epigenetische Interpretation.

e) Wenn das Betriebssystem krank macht

Fast alle genetischen Risikomarker für Volkskrankheiten – von Diabetes über Herzleiden bis zu psychischen Störungen – liegen in nicht-codierenden Zonen:

Mutationen in einem Enhancer für das MYC-Gen können Leukämie auslösen, indem sie die Zellteilung außer Kontrolle bringen.

Epigenetische Fehlprogrammierungen in diesen Bereichen – etwa durch chronischen Stress oder Umweltgifte – können Gene dauerhaft falsch an- oder abschalten und so Krankheiten wie Krebs oder Autoimmunstörungen begünstigen.

Solche epigenetischen Muster sind teils reversibel – ein Hoffnungsschimmer für neue Therapien.

f) Offene Rätsel der Forschung

Trotz gewaltiger Fortschritte bleibt das Genom voller ungelöster Rätsel:

Die „dunkle Materie“: Rund die Hälfte des nicht-codierenden Genoms ist funktional unergründet. Handelt es sich um evolutionäres Rauschen – oder um ein noch unkartiertes Steuernetz des Lebens?

Langstrecken-Kommunikation: Wie findet ein Enhancer zielsicher sein Gen inmitten von Millionen DNA-Bausteinen? Die räumliche Faltung des Genoms – ein wahres „Chromatin-Origami“ – könnte der Schlüssel sein.

Umwelt-Einflüsse: Weshalb führen identische nicht-codierende Mutationen in verschiedenen Lebenswelten zu völlig unterschiedlichen Krankheitsbildern?

RNA-Codes: Zehntausende nicht-codierende RNAs sind entdeckt – doch welche von ihnen sind nur Randnotizen, und welche erheben sich möglicherweise zu Leitmotiven neuer Therapien?

g) Die wahre Magie der Gene

Die nicht-codierende DNA ist kein Datenmüll, sondern das Mastermind der Zelle. Die Epigenetik wiederum ist ihr Dirigent – sie interpretiert flexibel, was das Betriebssystem vorgibt. Gemeinsam formen sie unsere Entwicklung, steuern unsere Gesundheit und reagieren auf Umweltsignale.

Gene sind kein starres Schicksal, mehr eine Partitur, die immer wieder neu interpretiert werden kann. Im Zusammenspiel entsteht ein Orchester, das nicht nur unsere Zellen formt, sondern sich ständig neu einstimmt – durch Erfahrungen, Umwelteinflüsse und sogar durch Spuren, die auch an kommende Generationen weitergegeben werden können.

Die wahre Magie liegt darin, dass aus begrenzten Noten eine unendliche Vielfalt von Leben erklingt.

4.2. Genetische Variation und ihre Folgen

Wenn sich das Erbgut verschreibt, verstummt oder improvisiert.

Bei jeder Zellteilung wird die DNA sorgfältig kopiert und an die Tochterzellen weitergegeben – so bleibt die genetische Information über Generationen hinweg erhalten.

Doch das System ist nicht unfehlbar: Mutationen – also Veränderungen in der DNA-Sequenz – können Struktur und Funktion von Proteinen beeinflussen. Manchmal stimmt nur ein Buchstabe nicht. Oder ein Satz fehlt. Oder ein ganzer Absatz wurde umgestellt. In der Genetik spricht man dann von Varianten – genetischen Veränderungen, die je nach Art, Größe und Position harmlos, risikobehaftet oder krankheitsauslösend sein können.

Die folgende Übersicht enthält die wichtigsten Variantentypen – und was sie im molekularen Manuskript des Lebens bedeuten:

📌 SNVs (Single Nucleotide Variants) – Ein einziger Buchstabe ist vertauscht. Meist kaum spürbar – doch manchmal genügt er, um ganze Geschichten umzuschreiben, wie bei der Sichelzellenanämie.

📌 Indels (Insertionen/Deletionen) – Kleine Textfragmente werden eingefügt oder gelöscht. Schon eine winzige Verschiebung kann ganze Sätze aus dem Takt bringen, manchmal so stark, dass der ursprüngliche Sinn verloren geht.

📌 Strukturelle Varianten (SVs) – Lange DNA-Passagen werden verdreht, verdoppelt oder verschoben. Diese verdeckten Umschreibungen sind schwer zu entdecken – und oft verhängnisvoll, etwa bei Krebs.

📌 Splice-Site-Varianten – Fehler an den Schnittstellen zerreißen die Syntax der RNA. Es entstehen falsche Baupläne – und Proteine, die nicht mehr stimmen.

📌 Repeat-Expansionen – Basenfolgen werden zwanghaft wiederholt, bis sie den Text entstellen. So entstehen Krankheiten wie Chorea Huntington.

📌 Copy Number Variants (CNVs) – Ganze Kapitel (Gene) fehlen oder erscheinen doppelt. Das Gleichgewicht der Erzählung geht verloren.

📌 Mitochondriale Varianten – Veränderungen in der DNA der Mitochondrien, der Kraftwerke der Zelle. Wenn hier der Text verfälscht wird, stockt der Antrieb des Lebens.

📌 Somatische Varianten – Treten erst im Laufe des Lebens auf und betreffen nur bestimmte Zellgruppen. Sie prägen vor allem die Geschichte von Tumoren.

📌 Epigenetische Signale – Keine neuen Buchstaben, sondern eine andere Betonung: Lautstärke, Rhythmus, Beginn. Sie verwandeln denselben Text in eine völlig neue Melodie.

Die Liste zeigt: Unser Erbgut ist kein starres Gebilde, sondern lässt sich durch Varianten verändern. Manche dieser Abweichungen bleiben unauffällige Randnotizen, andere aber können die gesamte Geschichte neu schreiben – manchmal mit dramatischen Folgen.

Um solche feinen Unterschiede sichtbar zu machen, braucht es Werkzeuge, die jedes Detail erfassen – jeden Buchstaben, jedes Satzzeichen, jede Verschiebung. Genau hier setzt die moderne Genomsequenzierung an.

4.3. Genomsequenzierung: Schlüssel zum individuellen Erbgut

Das Erbgut eines Menschen gleicht einer gigantischen Bibliothek: Milliarden von Buchstaben, fein säuberlich in langen Bänden angeordnet. Um darin zu lesen, bedarf es der Genomsequenzierung – die wie ein hochpräziser Scanner den Rohtext unseres genetischen Bauplans liefert.

So wird sie zum Herzstück der personalisierten Medizin: einer Medizin, die ihre Entscheidungen am Einzelnen ausrichtet, nicht am Durchschnitt.

Doch wie gelangen wir überhaupt an das „Buch des Lebens“, um es Seite für Seite lesen zu können?

Stellen wir uns vor: Bei einem Neugeborenen wird kurz nach der Geburt ein DNA-Test durchgeführt – ein Szenario, das im Vereinigten Königreich bereits Wirklichkeit geworden ist, wie zuvor beschrieben.

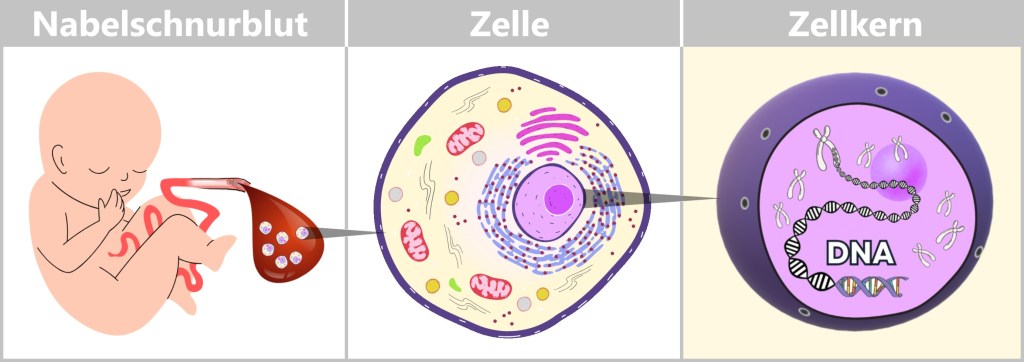

a) Die Reise der DNA: Vom Nabelschnurblut zur genetischen Information

Unmittelbar nach der Geburt kann Blut aus der abgetrennten Nabelschnur entnommen werden – ein sicherer und schmerzfreier Vorgang. Das Nabelschnurblut stammt vom Neugeborenen und enthält zahlreiche wertvolle Zellen, insbesondere Stammzellen und weiße Blutkörperchen. In ihren Zellkernen liegt das Entscheidende verborgen: die DNA – das genetische Erbe des Kindes.

Links: Nabelschnurblut als reiche Quelle unterschiedlicher Zellen.

Mitte: Schematische Darstellung einer menschlichen Zelle.

Rechts: Im Zellkern liegt die DNA, Trägerin der genetischen Information.

Um diese DNA zu isolieren und analysieren zu können, durchläuft sie im Labor einen mehrstufigen Prozess. Dabei kommen bewährte molekularbiologische Methoden zum Einsatz, die sich in vier zentrale Schritte gliedern lassen:

Zellaufschluss: Zugang zum Erbgut schaffen

Zunächst wird das Blut zentrifugiert – also mit hoher Geschwindigkeit geschleudert. Dabei trennen sich die Bestandteile nach Dichte: Die weißen Blutkörperchen setzen sich als Zellpellet am Boden ab. Sie enthalten den größten Teil der interessierenden DNA.

Diese Zellen werden anschließend mit speziellen Lösungen und Enzymen behandelt, die die Zell- und Zellkernmembran auflösen. Dadurch wird die DNA freigesetzt – zunächst allerdings als Teil eines Gemischs aus Proteinen, Lipiden und anderen Zellbestandteilen.

DNA-Isolierung: Reines Erbgut gewinnen

Im nächsten Schritt wird die DNA aus dem Zelllysat – der „Zellsuppe“ – isoliert. Dazu gibt es verschiedene Verfahren:

Filtration oder Säulenreinigung: Die Lösung wird durch spezielle Filtersysteme geleitet, an denen die DNA haften bleibt, während kleinere Moleküle ausgespült werden.

Magnetkügelchen: Modernere Verfahren verwenden winzige Kügelchen mit DNA-bindenden Oberfläche. Die DNA haftet daran und kann per Magnet gezielt entnommen werden.

Beide Methoden ermöglichen eine effektive Trennung von Erbgut und Störstoffen.

Reinigung und Konzentration der DNA

Nun liegt die DNA vieler weißer Blutkörperchen in relativ reiner Form vor – allerdings noch in einer wässrigen Lösung. Um sie weiter zu reinigen und zu konzentrieren, wird kalter Alkohol (z. B. Ethanol oder Isopropanol) hinzugefügt. Dadurch fällt die DNA aus und wird sichtbar – als weißlicher, fadenartiger Niederschlag.

Die menschliche DNA ist extrem lang: Entrollt man sie, misst sie pro Zelle etwa zwei Meter. Bei der Extraktion wird sie jedoch durch chemische und mechanische Einflüsse in viele kleinere Abschnitte zerteilt. Das sieht zunächst nach Chaos aus – doch da die DNA in allen Zellen identisch ist, enthalten viele Fragmente überlappende Informationen. Diese zufällige Verteilung wird bei der Sequenzierung zum Vorteil: Die Fragmente können mehrfach unabhängig gelesen und anschließend am Computer zu einem Gesamtbild zusammengesetzt werden. Das erhöht die Genauigkeit der Analyse erheblich.

Qualitätskontrolle: Ist die DNA intakt?

Bevor die DNA-Probe analysiert werden kann, muss ihre Qualität überprüft werden. Zwei gängige Verfahren sind:

Spektrophotometrie: Misst die Konzentration und Reinheit der DNA über die Lichtabsorption.

Gelelektrophorese: DNA-Fragmente werden durch ein Gel geleitet und nach Länge getrennt. (Längere Fragmente wandern langsamer als kürzere.) So lässt sich beurteilen, ob die Probe ausreichend intakt ist.

Warum ist dieser Prozess so wichtig?

Die menschliche DNA ist empfindlich – Verunreinigungen oder Fragmentierungen können Analysen verfälschen oder unbrauchbar machen. Eine sorgfältige und kontrollierte Aufreinigung ist daher Voraussetzung für zuverlässige genetische Aussagen.

Gerade Nabelschnurblut stellt eine besonders wertvolle Quelle medizinischer Information dar: Es ermöglicht Frühdiagnostik, Prognosen und in manchen Fällen gezielte Prävention.

Was im Labor wie ein routinierter Ablauf wirkt, ist in Wahrheit ein hochpräziser Vorgang – erfordert technisches Know-how, moderne Geräte und biochemisches Feingefühl. Durch automatisierte Extraktionsmethoden lässt sich heute in weniger als einer Stunde aus wenigen Tropfen Nabelschnurblut eine hochwertige DNA-Probe gewinnen. Sie besteht zwar aus Fragmenten, enthält aber dennoch alle Informationen, um den individuellen genetischen Code zu entschlüsseln – und damit die Grundlage für eine Medizin von morgen zu legen.

b) Drei Regieanweisungen für die Gen-Diagnostik: WGS, WES und Panel

Bevor wir tiefer in die Werkzeuge der Genom-Sequenzierung eintauchen, lohnt sich ein Blick auf die drei zentralen Strategien, mit denen heute genetische Informationen entschlüsselt werden – gleichsam wie Regieanweisungen im Drehbuch des Lebens:

🎯 Panel-Sequenzierung – Die gezielte Szene

Hier wird nur ein ausgewählter Teil des Genoms untersucht – meist einige Dutzend bis wenige Hundert Gene. Solche Tests kommen zum Einsatz, wenn der Verdacht auf eine spezifische Erkrankung besteht, etwa bei erblich bedingtem Brustkrebs (BRCA1/2).

Vorteil: Schnell, kosteneffizient, präzise – solange die medizinische Fragestellung klar ist.

Limitierung: Alles außerhalb der gewählten Szene bleibt im Dunkeln.

🎥 Whole Exome Sequencing (WES) – Der klassische Director’s Cut

WES analysiert alle protein-kodierenden Abschnitte des Genoms – also etwa 1–2 % des gesamten Erbguts. Gerade bei seltenen Erbkrankheiten ist es ein bewährtes Mittel, da die meisten bekannten Mutationen in diesen Bereichen liegen.

Vorteil: Effiziente Suche nach fehlerhaften Bauplänen für Proteine.

Limitierung: Bereiche außerhalb der Gene – wichtige Schalter und Regler des Erbguts – werden nicht erfasst.

🎬 Whole Genome Sequencing (WGS) – Der vollständige Film in 4K

WGS liest das gesamte Genom – alle drei Milliarden Buchstaben. Damit liefert es das umfassendste Bild, inklusive nicht-kodierender Regionen, regulatorischer Elemente, struktureller Varianten und seltener Mutationen.

Vorteil: Maximale Auflösung für komplexe Fälle.

Beispiel: Bei Kindern mit unklaren Entwicklungsstörungen bringt WGS doppelt so häufig Klarheit wie WES – etwa durch das Aufdecken von Mutationen in entfernten „Fernsteuerungs“-Regionen (Enhancern), die Gene falsch an- oder abschalten.

Fazit:

Je nach Fragestellung braucht es die passende Perspektive – manchmal reicht ein Zoom auf die Schlüsselszene, manchmal muss der ganze Film neu geschnitten werden. Die Wahl der Methode ist daher keine technische Nebensache, sondern eine strategische Entscheidung im Drehbuch der Diagnostik.

4.4. Methoden der Genomsequenzierung

Wie wird der genetische Code gelesen?

Stellen Sie sich vor, DNA ist ein Buch – geschrieben in einer Sprache mit nur vier Buchstaben: A, T, C und G. Um diesen genetischen Text zu entschlüsseln, nutzen Wissenschaftler moderne Technologien. Zwei zentrale Methoden haben sich etabliert. Sie verfolgen dasselbe Ziel: die Reihenfolge der DNA-Buchstaben möglichst genau zu bestimmen.

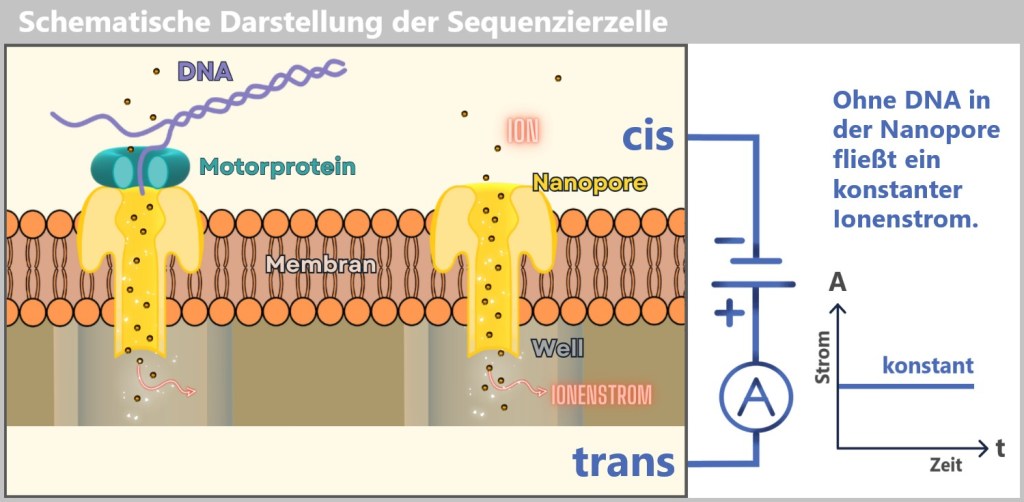

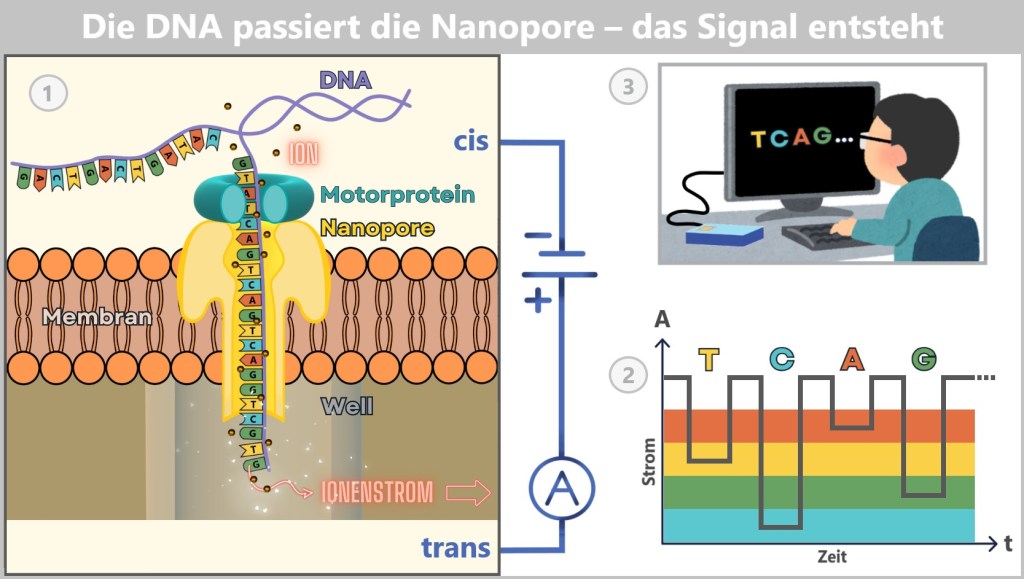

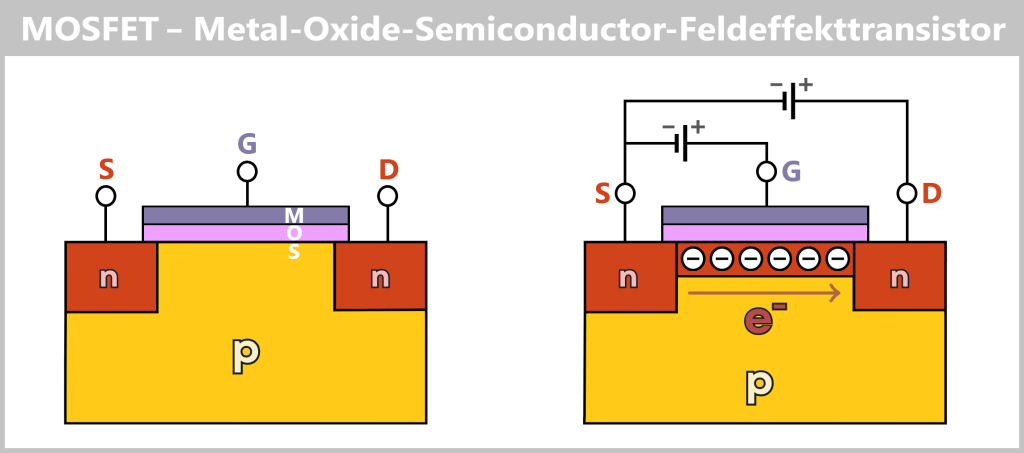

Die erste Methode funktioniert – vereinfacht gesagt – wie eine molekulare Kopiermaschine mit Farbsensoren. Die zweite nutzt einen Hightech-Tunnel, durch den die DNA geleitet und elektronisch „abgetastet“ wird – vergleichbar mit dem Abtasten eines Seils mit den Fingern, um kleinste Unebenheiten zu spüren. Diese Verfahren bilden die Grundlage der DNA-Sequenzierung.

4.4.1. Methode 1: Kopieren mit Leuchtfarbe

a) Sanger-Sequenzierung

b) Illumina-Technologie

c) Single-Molecule Real-Time(SMRT)-Sequenzierung

4.4.2. Methode 2: Hightech-Tunnel – DNA elektrisch abtasten

a) Oxford Nanopore Sequenzierung

4.4.3. Genomsequenzierung – Technologien im Vergleich

a) Durchsatz vs. Verwertbarkeit – Masse ist nicht immer gleich Klasse

b) Wirtschaftlichkeit – Kosten pro Base vs. Kosten pro Erkenntnis

c) Von der Probe zum Befund – Wie schnell spricht das ganze Genom?

d) Klinische Einsatzfelder – Welche Technologie passt wozu?

e) KI als Co-Pilot – Automatisierung ohne Verantwortung abzugeben

f) Vergleichstabelle: Sanger, Illumina, PacBio, ONT

g) Key Takeaways: Zwischen Reife und Routine

4.4.1. Methode 1: Kopieren mit Leuchtfarbe

Diese Methode nutzt die Tatsache, dass DNA aus zwei komplementären Strängen besteht. Kennt man die Basenabfolge eines Strangs, lässt sich die Sequenz des Gegenstrangs automatisch ableiten. Um diese Information zu gewinnen, wird einer der beiden Stränge der zu untersuchenden DNA kopiert. Ziel ist es, während dieses Kopiervorgangs die exakte Reihenfolge der Basen in der entstehenden Kopie zu erfassen.

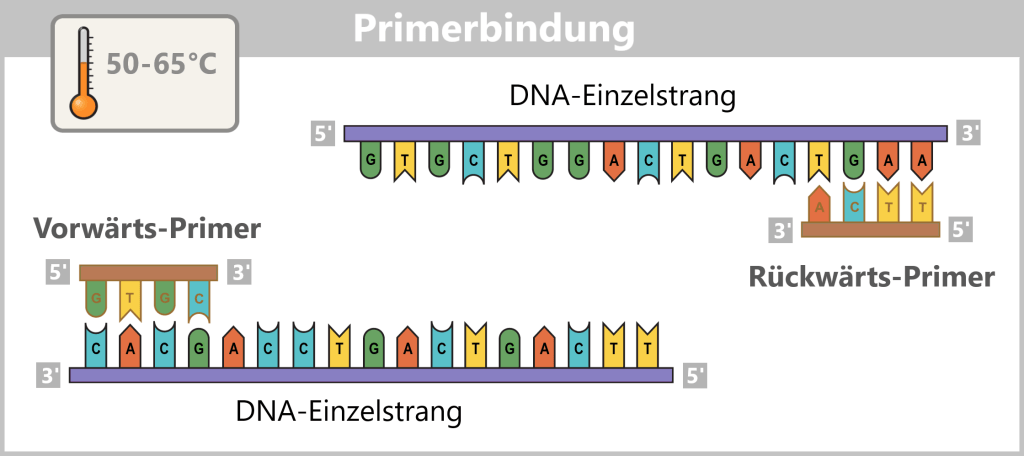

Um besser zu verstehen, wie dieses Verfahren funktioniert, werfen wir zunächst einen Blick auf die wichtigsten Bestandteile und die grundlegenden Schritte zur Herstellung einer DNA-Kopie im Reagenzglas (in vitro).

Herstellung einer DNA-Kopie – das Grundprinzip

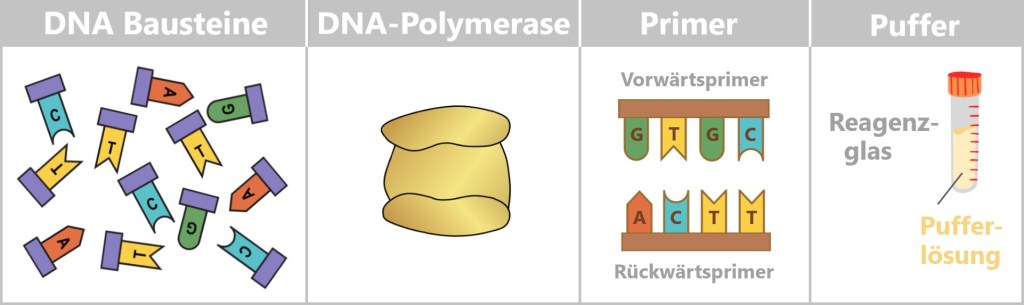

Im Zentrum steht eine DNA-Vorlage, die kopiert werden soll. Dafür braucht es vier Hauptbestandteile:

- dNTPs (Desoxynukleosidtriphosphate): die DNA-Bausteine A, T, C und G.

- DNA-Polymerase: ein Enzym, das als molekularer Kopierer fungiert.

- Primer: kurze DNA-Stücke, die der Polymerase den Startpunkt liefern.

- Pufferlösung: sorgt für stabile Bedingungen während der Reaktion.

DNA-Bausteine: Einzelne Nukleotide (A, T, C, G), dargestellt in verschiedenen Farben und Buchstaben. Sie bilden das Rohmaterial, aus dem der neue DNA-Strang zusammengesetzt wird.

DNA-Polymerase: Ein schematisch dargestelltes Enzym, das Nukleotide zu einem DNA-Strang verknüpft.

Primer: Kurze DNA-Stücke, die der Polymerase den Startpunkt vorgeben.

Puffer: Ein Reagenzglas mit Pufferlösung, die für stabile chemische Bedingungen während der Reaktion sorgt.

Was macht die DNA-Polymerase?

Die DNA-Polymerase ist ein spezielles Enzym, das komplementäre DNA-Stränge erzeugt – gewissermaßen der „Druckkopf“ einer molekularen Kopiermaschine. Enzyme wirken als biologische Werkzeuge, die chemische Reaktionen gezielt und effizient ermöglichen – deshalb nennt man sie auch „biologische Katalysatoren“.

Damit die Polymerase arbeiten kann, benötigt sie einen Primer als Startsignal. Man kann sich das so vorstellen: Wie ein Druckkopf erst loslegt, wenn ein Blatt Papier richtig eingelegt ist, beginnt auch die Polymerase ihre Arbeit erst, wenn ein Primer vorhanden ist. Dieses kleine DNA-Stück zeigt ihr, wo sie starten soll – es ist sozusagen das erste Blatt im molekularen Drucker.

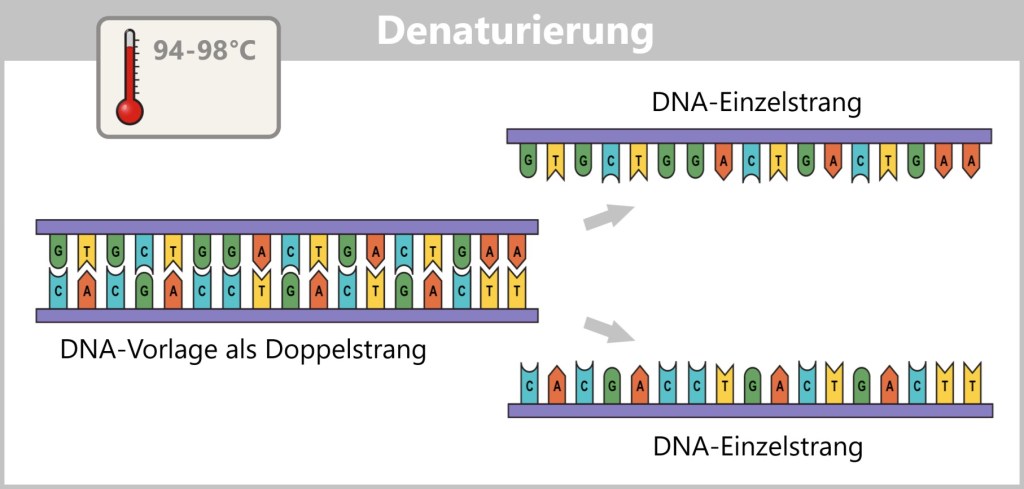

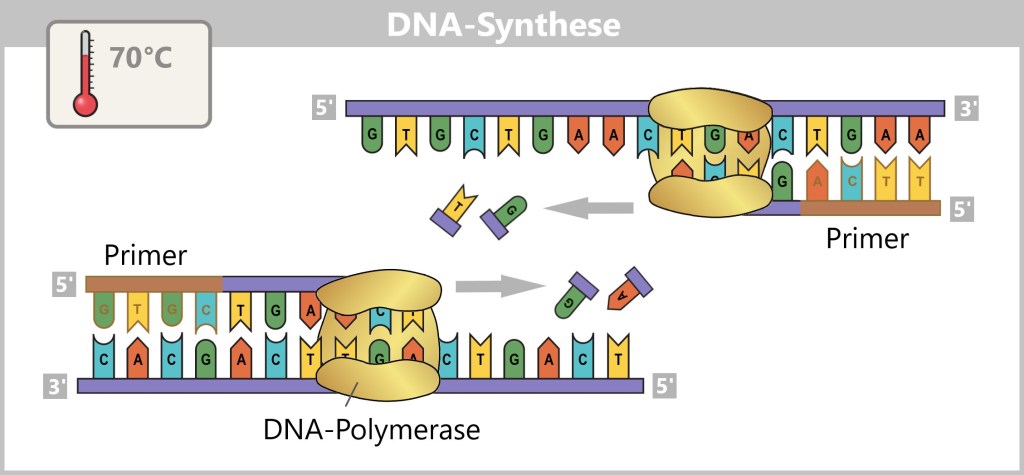

Vor Beginn der Kopie muss die doppelsträngige DNA zunächst in zwei Einzelstränge aufgetrennt werden – dieser Schritt heißt Denaturierung.

Anschließend lagern sich die Primer an ihre passenden Zielstellen der Einzelstränge. Diese Primerbindung markiert den Startpunkt für die DNA-Polymerase.

Nun beginnt die Synthese der neuen Stränge: Die Polymerase liest den Vorlage-Strang in 3′-zu-5′-Richtung und ergänzt die Kopie in Gegenrichtung – von 5′ nach 3′ – unter Beachtung der Basenpaarung (A mit T, G mit C).

Was bedeuten 3′ und 5′?

Die Bezeichnungen 3′ (sprich: drei-Strich) und 5′ (fünf-Strich) stammen aus der Chemie des DNA-Rückgrats. Sie geben an, an welchem Ende sich bestimmte Kohlenstoffatome im Zuckermolekül befinden, an die neue Bausteine angefügt werden können.

Stellen Sie sich den DNA-Strang wie eine Einbahnstraße vor. Die Polymerase kann nur in eine Richtung fahren – vom 5′-Ende zum 3′-Ende. Neue Bausteine lassen sich chemisch nur am 3′-Ende anfügen. Daher liest die Polymerase den „alten“ Strang rückwärts (3′ → 5′) und baut den neuen Strang vorwärts (5′ → 3′).

So entsteht aus einem Einzelstrang nach und nach ein neuer, passender Gegenstrang – mithilfe der Basenpaarungsregeln: Adenin (A) paart sich mit Thymin (T), und Cytosin (C) mit Guanin (G).

Das Ergebnis sind perfekte genetische Abbilder – neue DNA-Stränge, exakte Kopien der Ursprungs-DNA.

Leuchtende Buchstaben: Wie Sequenzierung funktioniert

Moderne Sequenziermethoden erweitern diesen Kopiervorgang um eine raffinierte Technik: Sie verwenden fluoreszierend markierte dNTPs (DNA-Bausteine). Jedes der vier Nukleotide (A, T, C, G) ist mit einem Farbstoff versehen, der beim Einbau ein spezifisches Lichtsignal aussendet.

Während die Polymerase die DNA-Stränge verlängert, fügt sie die farbigen Bausteine passgenau ein. Jedes Mal, wenn ein neues Nukleotid eingebaut wird, sendet es ein winziges Lichtsignal – wie ein kleiner Blitz, der verrät, welcher „Buchstabe“ gerade ergänzt wurde. Hochauflösende Kameras erfassen diese Lichtsignale und ermöglichen so die schrittweise Rekonstruktion der DNA-Sequenz.

Sequenziermethoden im Überblick

Mehrere bedeutende Technologien nutzen dieses Prinzip in spezifischer Form:

Sanger-Sequenzierung: Die klassische Methode, bei der fluoreszierende Kettenabbruch-Nukleotide die DNA-Synthese an zufälligen Stellen beenden. Die resultierenden Fragmente lassen sich der Reihenfolge nach auslesen.

Illumina-Technologie: Eine weit verbreitete Hochdurchsatzmethode, bei der Millionen DNA-Fragmente parallel sequenziert werden. Die fluoreszierenden Signale werden Schritt für Schritt erfasst.

SMRT-Sequenzierung (PacBio): Hier wird die Synthese in Echtzeit an einem einzigen DNA-Molekül beobachtet – mit hoher Präzision und langen Leselängen.

a) Sanger-Sequenzierung

Das klassische „Buchstaben-für-Buchstaben-Lesen“

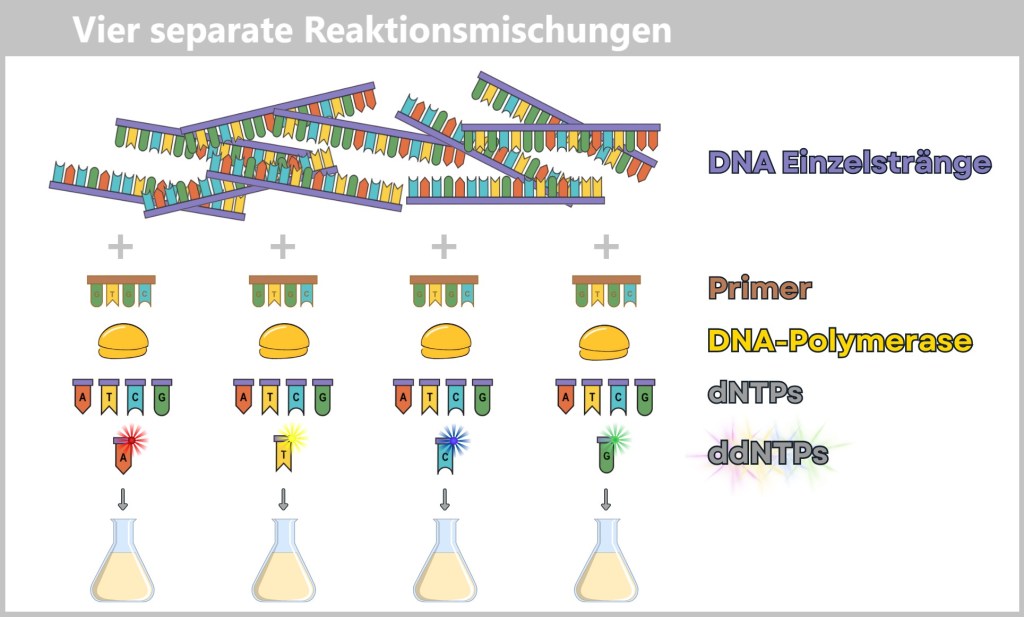

Die Sanger-Sequenzierung, auch Kettenabbruchmethode genannt, wurde in den 1970er-Jahren entwickelt und war das erste Verfahren, mit dem sich DNA präzise und zuverlässig auslesen ließ. Sie beruht im Wesentlichen auf denselben Prinzipien wie die DNA-Synthese, unterscheidet sich jedoch in einigen entscheidenden Punkten:

- Es wird nur ein Primer verwendet.

- Neben den normalen DNA-Bausteinen – den dNTPs (dATP, dCTP, dGTP, dTTP) – kommen zusätzlich spezielle fluoreszierende Kettenabbruch-Bausteine, die sogenannten ddNTPs (ddATP, ddCTP, ddGTP, ddTTP) in geringer Konzentration zum Einsatz. Wenn ein solcher ddNTP eingebaut wird, stoppt die DNA-Synthese genau an dieser Stelle. Jeder der vier ddNTP-Typen trägt eine unterschiedliche Leuchtfarbe, je nach Base.

Der Ablauf – Schritt für Schritt

Für die Sequenzierung werden vier separate Reaktionsmischungen angesetzt. Jede enthält:

- die einzelsträngige Ziel-DNA,

- einen Primer (Startpunkt der Synthese),

- eine DNA-Polymerase,

- normale dNTPs,

- und jeweils eine Sorte der farblich markierten ddNTPs.

Jede Mischung enthält die gleichen Grundkomponenten, unterscheidet sich jedoch durch die jeweils zugegebene Variante der farblich markierten Stopp-Bausteine (ddNTPs).

Nach der Primerbindung liest die Polymerase den DNA-Strang aus und fügt passende Nukleotide ein, um einen komplementären Strang aufzubauen. Wird dabei zufällig ein ddNTP eingebaut, endet die Synthese an genau dieser Stelle.

So entstehen viele unterschiedlich lange DNA-Fragmente – jedes endet mit einem farbig markierten Basenbuchstaben. Da in jeder der vier Reaktionen nur ein ddNTP enthalten ist, weiß man genau, mit welchem Buchstaben die erzeugten DNA-Fragmente enden.

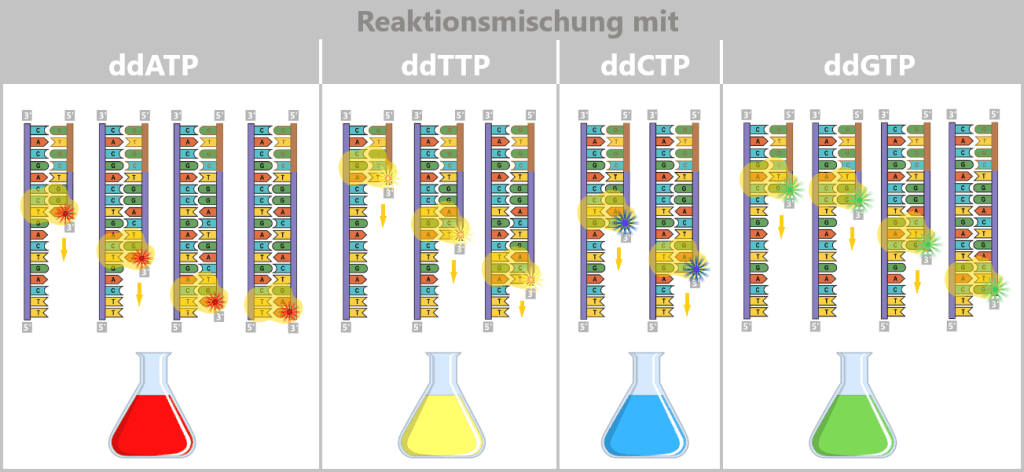

In jeder Reaktionsmischung ist jeweils eine Sorte der modifizierten DNA-Bausteine (ddATP, ddTTP, ddCTP, ddGTP) enthalten. Wird einer dieser Stopp-Bausteine während der DNA-Synthese eingebaut, bricht der Kopiervorgang genau an dieser Stelle ab. In der ddATP-Mischung stoppt die Synthese, sobald ein modifiziertes Adenin (A) eingebaut wird. In der ddTTP-Mischung endet sie beim Einbau eines modifizierten Thymins (T). Genauso führen ddCTP und ddGTP zum Abbruch der Synthese, wenn ein modifiziertes Cytosin (C) bzw. Guanin (G) eingebaut wird. Durch dieses Verfahren entstehen viele DNA-Fragmente unterschiedlicher Länge, die jeweils mit einem spezifischen Stopp-Nukleotid enden. Ziel ist es, alle theoretisch möglichen Fragmente zu erzeugen, um daraus die vollständige DNA-Sequenz ablesen zu können.

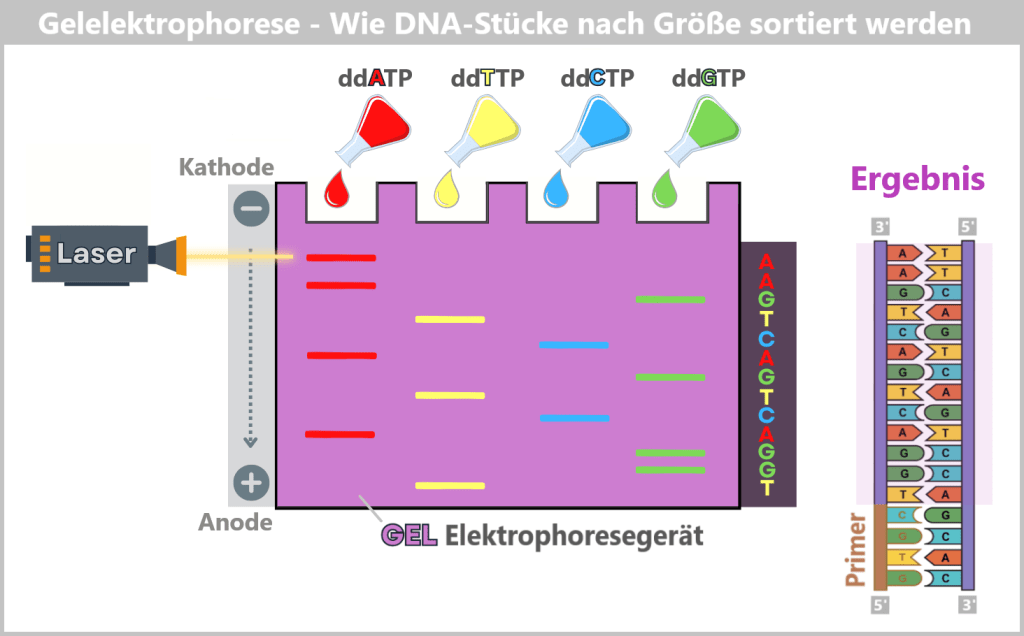

Sortierung und Auswertung

Anschließend werden die DNA-Fragmente denaturiert (in Einzelstränge überführt) und durch Gelelektrophorese der Länge nach sortiert. Dabei wandern die negativ geladenen Fragmente durch ein Gel in Richtung der positiven Elektrode. Kleinere Fragmente bewegen sich schneller, größere langsamer – so entsteht eine geordnete „Leiter“ von Fragmenten.

Ein Laser regt nun die fluoreszierenden Farbstoffe der Endbasen an. Die dabei entstehenden Lichtsignale werden von einem Detektor erfasst. Jedes Signal steht für eine bestimmte Base an einer bestimmten Position. Die Reihenfolge der Lichtsignale ergibt damit direkt die DNA-Sequenz – wie bei einem Buchstaben-für-Buchstaben-Lesen.

Da die erzeugten Fragmente komplementär zur Ursprungs-DNA sind, lässt sich daraus die ursprüngliche Basenfolge exakt ableiten.

In den Reaktionsansätzen entstehen unterschiedlich lange DNA-Fragmente, die jeweils mit demselben Stopp-Nukleotid enden – je nach Ansatz entweder mit Adenin, Thymin, Guanin oder Cytosin. Diese Reaktionsmischungen werden auf ein Gel aufgetragen. Sobald ein elektrisches Feld angelegt wird, wandern die negativ geladenen DNA-Fragmente von der Kathode (−) zur Anode (+). Dabei bestimmt die Größe der Fragmente ihre Wandergeschwindigkeit: Kleinere Fragmente bewegen sich schneller durch die feinen Poren des Gels und gelangen früher zur Anode, während größere Fragmente langsamer sind. Durch das Auslesen der fluoreszierenden Farbsignale an den Fragment-Enden kann die genaue Reihenfolge der Basen bestimmt werden – und damit die DNA-Sequenz Schritt für Schritt rekonstruiert werden.

Warum gilt die Sanger-Sequenzierung bis heute als Goldstandard?

Auch ein halbes Jahrhundert nach ihrer Entwicklung bleibt die Sanger-Methode in vielen Bereichen der Molekularbiologie und Medizin unverzichtbar. Der Grund: Zuverlässigkeit und Präzision.

Im Vergleich zu modernen Hochdurchsatzverfahren ist die Sanger-Sequenzierung zwar langsamer und eignet sich nur für die Analyse kleinerer DNA-Abschnitte – nicht für ganze Genome. Aber genau darin liegt ihre Stärke:

- Gezielte Fragestellungen, wie das Überprüfen einzelner Gene,

- Nachweis spezifischer Mutationen, oder

- Validierung kritischer Ergebnisse, die zuvor mit anderen Methoden identifiziert wurden,

lassen sich mit der Sanger-Sequenzierung präzise, klar und interpretierbar beantworten – oft so deutlich, dass man die Abfolge der Basen direkt im Sequenzplot sehen kann.

In der medizinischen Diagnostik – etwa bei der Analyse vererbter Erkrankungen oder in der Qualitätskontrolle gentechnischer Verfahren – ist diese hohe Genauigkeit entscheidend. Denn ein falsch interpretierter Buchstabe kann hier lebenswichtige Folgen haben.

Ein weiterer Pluspunkt: Die Methode ist weltweit standardisiert, seit Jahrzehnten bewährt und unterliegt klaren Qualitätsrichtlinien.

Ein Klassiker mit Beständigkeit

In einer Welt, in der ständig neue Technologien auf den Markt drängen, bleibt die Sanger-Sequenzierung ein verlässlicher Anker – der Oldtimer unter den Sequenzierverfahren: nicht der Schnellste, aber extrem robust, bewährt und zuverlässig. Und manchmal ist genau das entscheidend.

b) Illumina-Sequenzierung

Die Hochgeschwindigkeits-Kopiermaschine

Die Sanger-Sequenzierung ist wie präzise Handarbeit: Jeder DNA-Strang wird Schritt für Schritt entziffert – zuverlässig, aber langsam und teuer.

Stellen Sie sich vor, Sie müssten ein ganzes Buch oder sogar eine Bibliothek abschreiben – und dürften dabei nur einen Buchstaben pro Minute notieren.

Genau hier liegt das Problem: Moderne Krebsforschung, die Entschlüsselung seltener Krankheiten oder die genetische Überwachung von Pandemien verlangen die Analyse großer Datenmengen – also vieler und/oder sehr langer DNA-Abschnitte. Dafür braucht es eine Methode, die nicht nur genau, sondern auch schnell und bezahlbar ist.

Und genau da kommt die Illumina-Sequenzierung ins Spiel. Sie hat das Prinzip der DNA-Entzifferung von der Handarbeit zur industriellen Massenproduktion erhoben und ist heute eine der am häufigsten eingesetzten Methoden für die Hochdurchsatz-Sequenzierung (Next Generation Sequencing, NGS). Statt einzelner Buchstaben werden nun ganze Seiten gleichzeitig gelesen – millionenfach, parallel, mit hoher Präzision und kosteneffizient.

Anders als bei der klassischen Sanger-Methode, bei der jedes DNA-Fragment einzeln analysiert wird, arbeitet Illumina mit einer massiven Parallelisierung – das heißt: Es werden viele DNA-Fragmente gleichzeitig vervielfältigt und sequenziert. Wie funktioniert das?

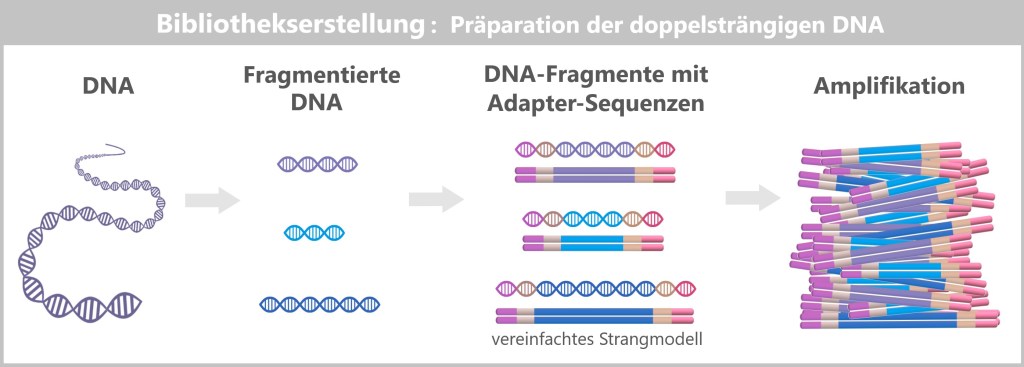

Schritt 1: Vorbereitung der DNA-Fragmente

– Die DNA wird zur „Lego-Baustelle“ –

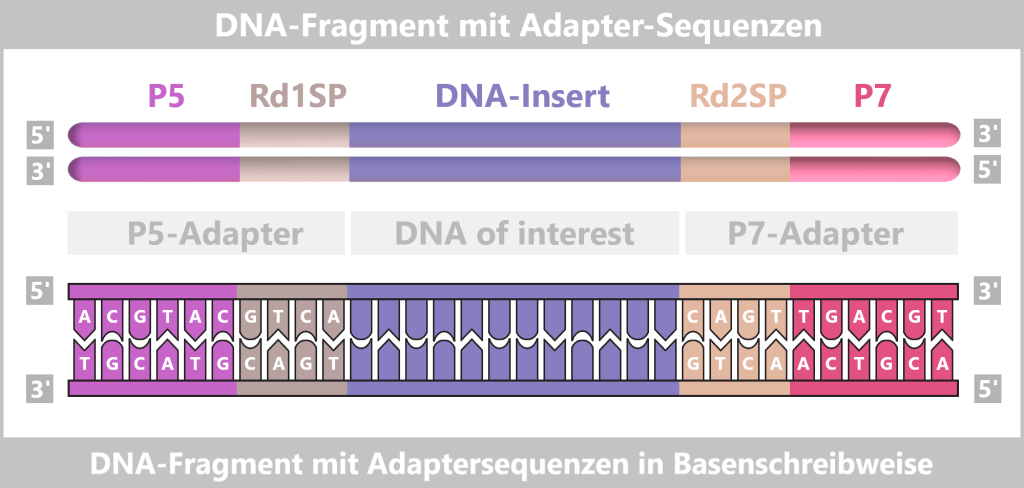

Zunächst wird die zu untersuchende DNA-Probe in viele kurze Stücke zerlegt – sogenannte Fragmente, die 100 bis 300 Basenpaaren lang sind. An beide Enden dieser Fragmente werden kleine künstliche DNA-Stücke – sogenannte Adapter – angehängt. Man kann sie sich wie LEGO-Steckverbinder vorstellen. Sie dienen einerseits als molekulare Andockstellen, um die DNA-Fragmente später auf einem speziellen Träger – dem Flowcell-Chip – zu befestigen. Andererseits dienen sie als Bindungsstellen für universelle Primer.

Die P5/P7-Sequenzen dienen der Bindung an der Flow Cell. Die Rd1SP/Rd2SP-Sequenzen sind Bindungsstellen für universelle Primer.

Durch Denaturierung werden die so vorbereiteten doppelsträngigen DNA-Fragmente in Einzelstränge gespalten.

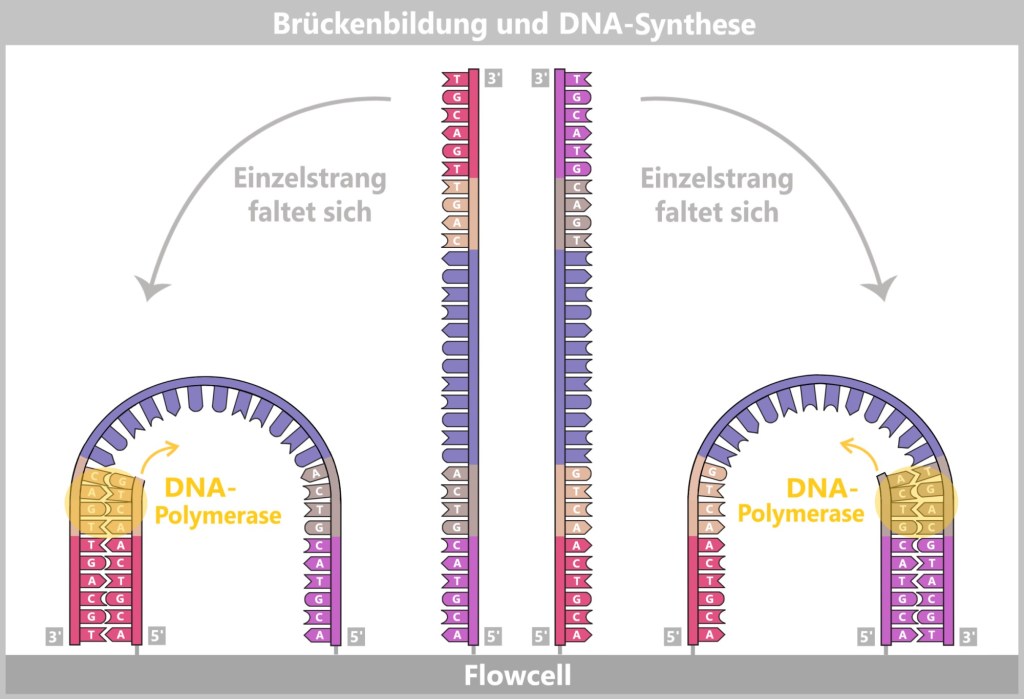

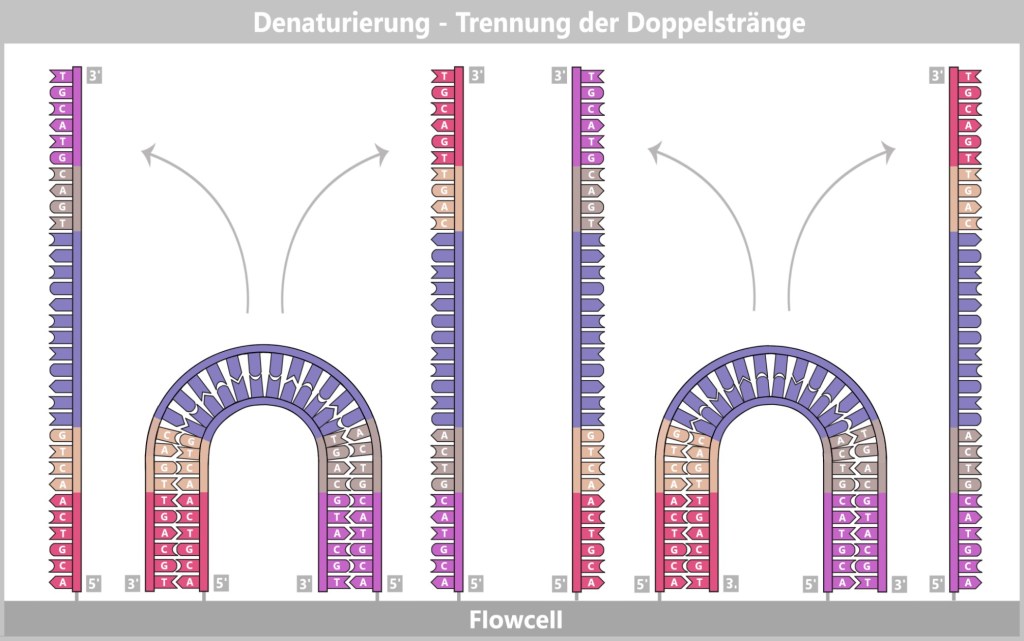

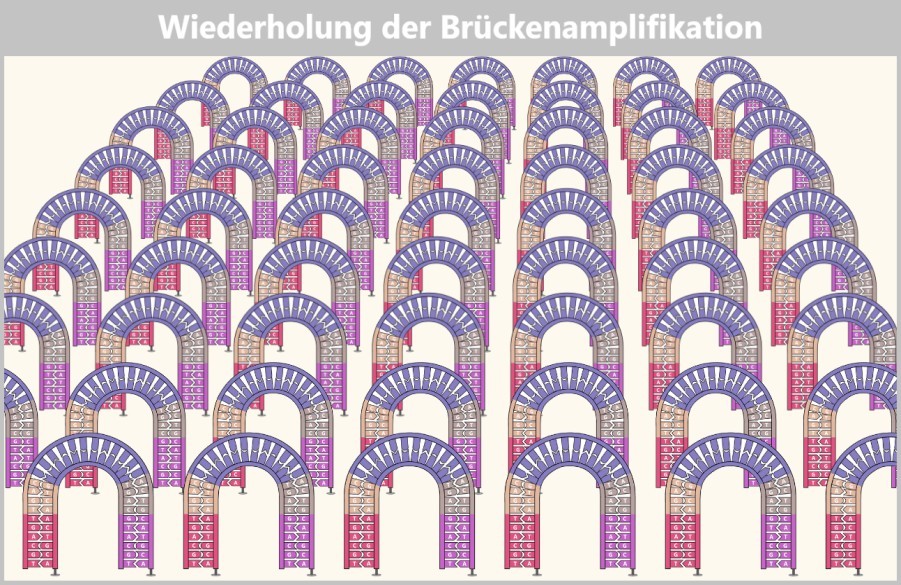

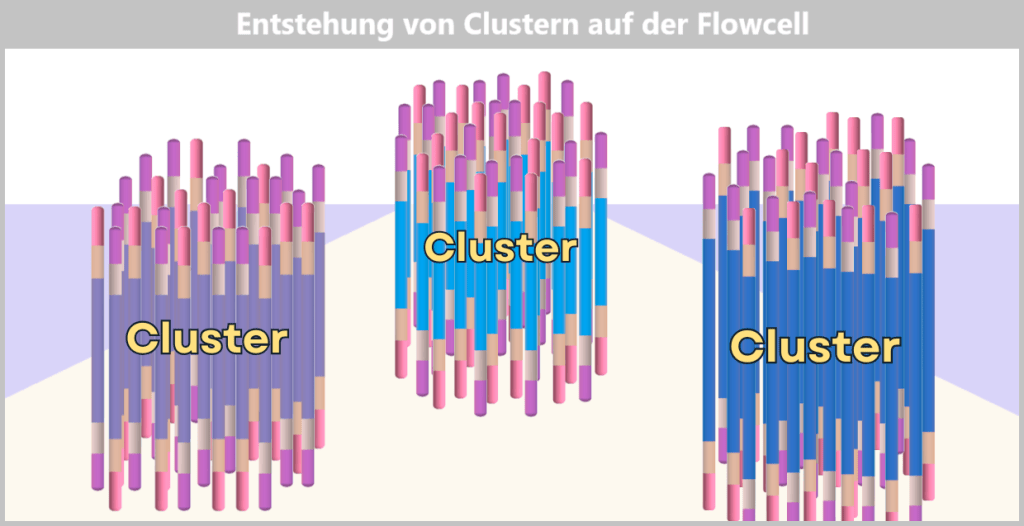

Schritt 2: Brückenamplifikation

– Der Tanz der DNA auf der Flow Cell –

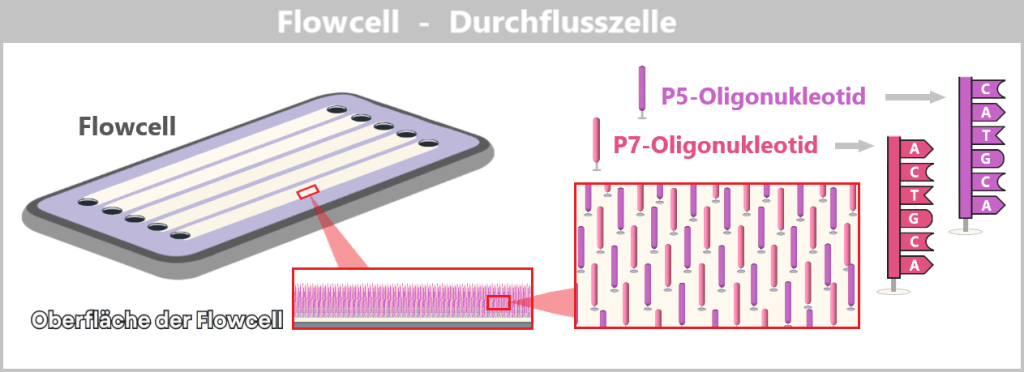

Das Herzstück der Illumina-Technologie ist die sogenannte Flow Cell – eine glasartige Platte, übersät mit Millionen winziger DNA-Andockstellen (kurzen DNA-Abschnitten, sogenannten Oligonukleotiden), die fest an der Oberfläche verankert sind.

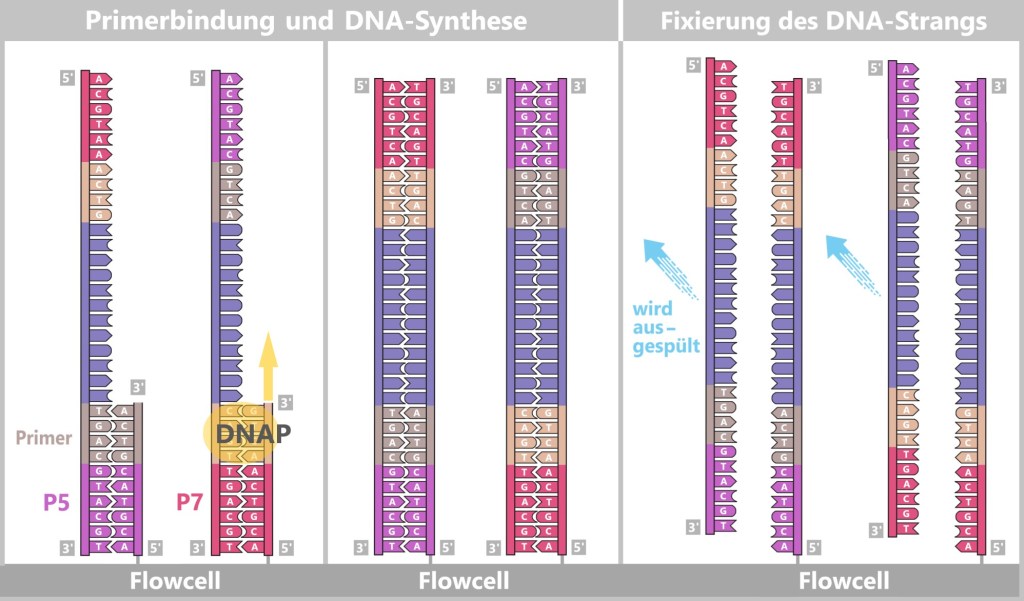

Über ihre Adapter binden sich die einzelsträngigen DNA-Fragmente an die Anker. Anschließend beginnt die molekulare Kopierarbeit: Es werden komplementäre Kopien der DNA-Schnipsel erzeugt, die nun fest mit der Flow Cell verankert sind.

Links: Primer binden an die Adapter (P5, P7), und die DNA-Polymerase (DNAP) startet die Synthese eines neuen, komplementären Strangs.

Mitte: Die DNA-Polymerase synthetisiert daraufhin einen ersten Strang.

Rechts: Der neue entstandene DNA-Doppelstrang wird aufgetrennt. Der ursprüngliche Strang hat nach der Denaturierung keine Verbindung mehr zur Flowcell und wird ausgespült. Der neu synthetisierte Strang bleibt mit seinem 5′-Ende fest an der Flowcell gebunden.

Dann beginnt ein faszinierender Prozess: Die DNA-Stränge biegen sich zu kleinen Brücken, indem ihre freien Adapter an benachbarte Oligonukleotide auf der Flow Cell binden. An diesen Stellen werden sie erneut kopiert. Nach dem Kopieren wird die Brücke wieder aufgelöst – und die Zahl der fest verankerten DNA-Stränge verdoppelt sich. Dieser Vorgang, bekannt als Brückenamplifikation, wiederholt sich dutzendfach. Am Ende entstehen dichte Cluster aus Millionen identischer Kopien eines einzelnen DNA-Fragments.

Die verankerten Einzelstränge falten sich und verbinden sich mit den benachbarten Ankern auf der Flowcell, wodurch eine Brückenstruktur entsteht. Danach wird der Kopiervorgang initiiert.

Nach dem Kopiervorgang werden die Brücken-Doppelstränge getrennt. Die Anzahl der fest verankerten DNA-Stränge verdoppelt sich. Sie sind bereit für die weitere Amplifikation.

Das Ergebnis ist eine dicht gepackte „Landkarte“ aus Millionen DNA-Clustern, die jeweils nur eine bestimmte Sequenz enthalten – ideal für das gleichzeitige Auslesen.

Ohne diese Vervielfältigung wäre das Lesen der DNA, als würde man versuchen, ein einzelnes Glühwürmchen im Wind zu erkennen. Die Cluster hingegen machen die DNA-Basen (A, T, C, G) deutlich sichtbar – wie ein leuchtender Neon-Schriftzug in der Dunkelheit.

Schritt 3: Sequenzieren durch Synthese

– Die Lichtshow der DNA-Basen –

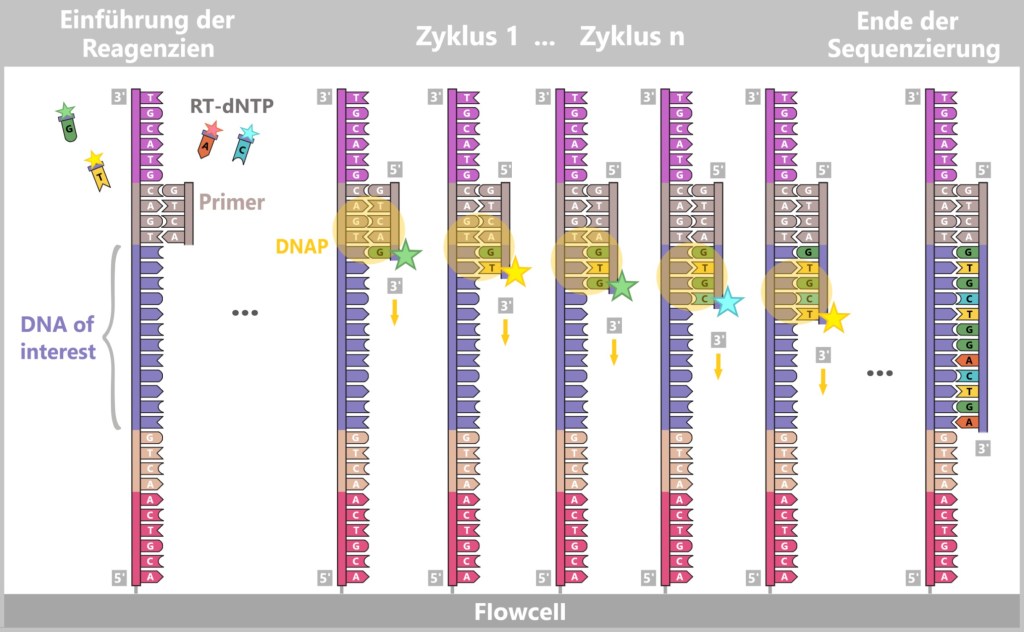

Nun beginnt das eigentliche Sequenzieren durch Synthese. Auch hier kommt das Prinzip der „molekularen Kopiermaschine mit Farbsensoren“ zum Einsatz – aber in optimierter Form:

Zu Beginn binden die Universal-Primer an den entsprechenden Adapterstellen der DNA-Fragmente in jedem DNA-Clusters.

Dann werden modifizierte dNTPs – sogenannte RT-dNTPs (reversibel terminierende Nukleotide) – in die Reaktionslösung gegeben. Jeder der vier DNA-Bausteine (A, T, G, C) ist dabei mit einer eigenen Fluoreszenzfarbe markiert und trägt eine reversible Blockierung.

Nur ein Nukleotid pro Zyklus kann eingebaut werden, weil die Blockierung den weiteren Strangaufbau vorübergehend stoppt. Nicht eingebaute RT-dNTPs werden weggewaschen.

Nach jedem Einbau wird die Flowcell mit einer hochauflösenden Kamera gescannt. Jeder leuchtende Punkt steht für ein eingebautes Nukleotid und seine Farbe zeigt an, welcher Buchstabe gerade ergänzt wurde.

Danach wird die Blockierung und die Farbstoffmarkierung chemisch entfernt, und der nächste Zyklus beginnt.

Dieser Prozess wird Zyklus für Zyklus wiederholt – bis jeder DNA-Strang vollständig gelesen ist.

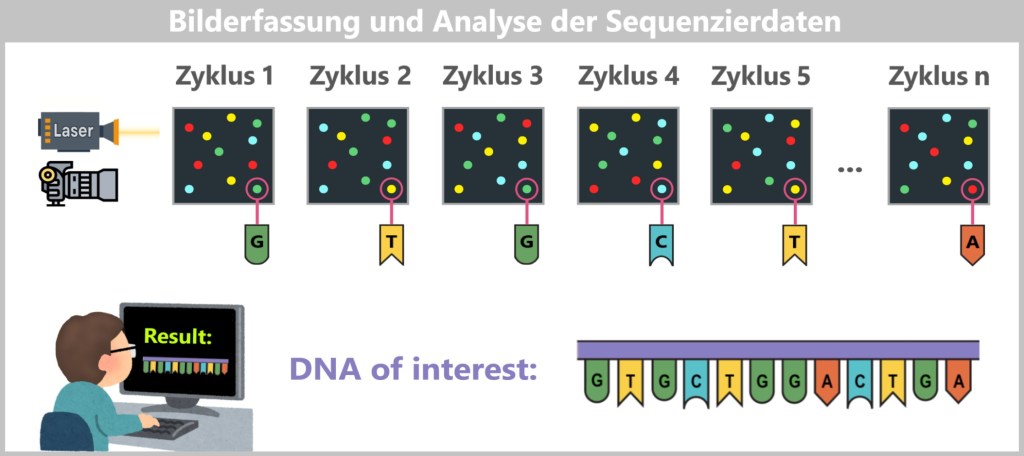

Schritt 4: Datenauswertung

– Der Supercomputer als Puzzlemeister –

Nach der „Lichtshow“ liegen Millionen von Fotos vor – eines für jeden Zyklus und jedes Cluster. Jedes Bild zeigt, welche Farbe (und damit welcher Buchstabe: A, T, C oder G) in jedem Cluster hinzugefügt wurde.

Jetzt kommen leistungsfähige Computer ins Spiel – ausgestattet mit Software, die so präzise arbeitet wie ein Detektiv, der aus einem Stapel durchnummerierter Polaroids ein zerschnittenes Buch zusammensetzt. Jedes Cluster auf dem Sequenzierungschip ist wie ein kleiner Tatort, jeder Farbpixel eine Spur. Und aus Millionen solcher Spuren entsteht allmählich eine Geschichte – die Geschichte der DNA.

Die Farbmuster werden in Buchstabenfolgen übersetzt, sogenannte „Reads“: winzige Textstücke eines gewaltigen Genom-Romans. Am Ende türmt sich eine Flut solcher Fragmente auf – wie ein Berg zerschnittener Buchseiten, lose verstreut.

Genau hier beginnt die eigentliche Kunst: Die Bioinformatik tritt auf den Plan. Mit Hilfe spezieller Algorithmen werden die Schnipsel analysiert, sortiert und aneinandergefügt – immer auf der Suche nach überlappenden Stellen, vertrauten Mustern, bekannten Strukturen.

Stück für Stück setzt sich das große Ganze wieder zusammen – bis am Ende die ursprüngliche DNA-Sequenz sichtbar wird, wie ein rekonstruiertes Buch, das plötzlich wieder Sinn ergibt.

Die eigentliche „Magie“ geschieht also nicht in der Flow Cell, sondern im Computer! Ohne die Software wären die Bilder nur buntes Flimmern – mit ihr aber werden sie zum Schlüssel für medizinische Durchbrüche.

Eine ausführlichere und dennoch anschauliche Erklärung der Illumina-Sequenzierungstechnologie Methode findet sich im Video „Illumina Sequencing Technology“.

Moderne Hochdurchsatz-Sequenzierplattformen wie die von Illumina können die Rohdaten eines vollständigen menschlichen Genoms innerhalb weniger Tage erzeugen – zu reinen Sequenzierkosten, die deutlich unter dem Preis eines Premium-Smartphones liegen.

Diese Technologie hat die Genomforschung revolutioniert und erheblich zugänglicher gemacht: Sie ist heute ein äußerst vielseitiges Werkzeug – schnell genug für die Echtzeit-Analyse von Pandemien, präzise genug, um in Kombination mit robuster Bioinformatik und klinischer Expertise die Grundlage für personalisierte Krebstherapien zu bilden.

Die Illumina-Sequenzierung gilt inzwischen als Industriestandard für große Sequenzierprojekte – etwa bei der Analyse ganzer Genome, in der Genexpressionsforschung oder in der modernen Krebsdiagnostik.

Und das Beste: Während man diesen Text liest, entschlüsselt irgendwo auf der Welt eine Flow Cell Millionen DNA-Fragmente.

Allerdings hat auch die Illumina-Technologie ihre Grenzen. Besonders bei langen, sich wiederholenden DNA-Abschnitten – wie sie in manchen Chromosomenbereichen vorkommen – gerät sie an ihre Grenzen. Das ist, als müsste man ein Lied aus tausenden 3-Sekunden-Schnipseln rekonstruieren. Für solche Herausforderungen kombiniert man Illumina häufig mit anderen Sequenzierverfahren, die auch lange Abschnitte zuverlässig erfassen können – wie ein Ermittler, der sowohl Nahaufnahmen als auch Panoramabilder braucht, um den ganzen Tatort zu verstehen.

c) Single-Molecule Real-Time(SMRT)-Sequenzierung

Der Roman in einem Zug

Stellen Sie sich vor, Sie wollen einen langen Roman lesen – voller wiederkehrender Kapitel und versteckter Hinweise, die sich über viele Seiten erstrecken. Wenn Sie das Buch wie bei der Illumina-Sequenzierung in tausende kleine Schnipsel zerschneiden, diese einzeln lesen und anschließend wie ein Puzzle zusammensetzen, besteht die Gefahr, dass Kapitel fehlen, vertauscht oder unvollständig bleiben. Die geheimen Botschaften der Geschichte – das, was der Roman uns eigentlich erzählen will – könnte dadurch verloren gehen oder nur bruchstückhaft erscheinen.

Hier glänzt die Single Molecule Real-Time (SMRT)-Sequenzierung von PacBio: Sie liest ganze Buchkapitel in einem Zug – ohne Schnipsel, ohne Pause.

Anstatt die DNA zu zerlegen, bleibt sie bei PacBio in sehr langen Stücken erhalten – oft Zehntausende Basenpaare am Stück, die als Ganzes sequenziert werden. Diese Fäden betreten winzige Bühnen in einer SMRT-Zelle, sogenannte Nanokammern (Zero-Mode Waveguides). Diese sind so klein, dass sie nur Platz für ein einziges DNA-Molekül und eine Polymerase bieten. Jede dieser Bühnen lässt Licht nur an einem winzigen Punkt wirken – genau dort, wo die Polymerase die DNA abliest. Wie ein Spotlicht, dass einen Schauspieler bei einem Monolog auf der Bühne ins Zentrum rückt.

Die Polymerase spielt die Hauptrolle: Sie fügt Baustein für Baustein (A, T, C oder G) an die DNA-Kopie an. Jeder dieser Bausteine leuchtet in einer anderen Farbe, ähnlich wie Neonlichter bei einem DJ. Bei jedem Einbau blitzt ein Lichtsignal auf, das von einer Kamera in Echtzeit aufgezeichnet wird – ein tanzender Lichtcode, der die DNA-Sequenz sichtbar macht.

Das Video Introduction to SMRT Sequencing von PacBio veranschaulicht diesen Vorgang eindrucksvoll.

Analysieren wir die einzelnen Schritte dieses faszinierenden Verfahrens im Detail.

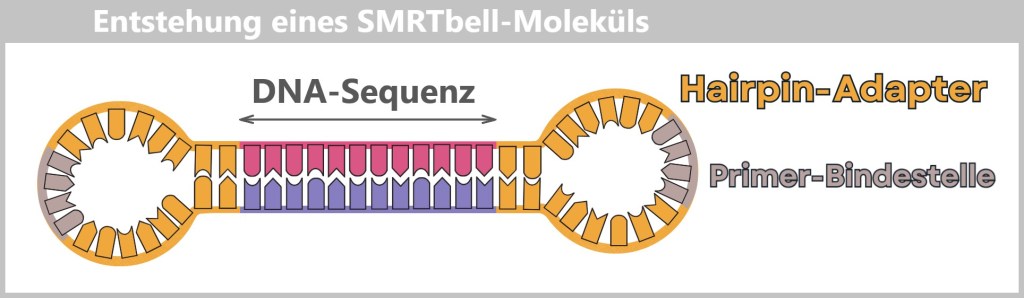

Schritt 1: Die Vorbereitung

– DNA-Ringe für das Endloslesen –

Auch bei PacBio wird die zu untersuchende DNA zunächst in Fragmente zerlegt – allerdings in deutlich größere Stücke als bei Illumina, meist 10.000 bis über 20.000 Basenpaare lang. Diese Fragmente werden zu ringförmigen DNA-Molekülen verarbeitet:

Man fügt an beide Enden sogenannte Hairpin-Adapter an – kleine Schlaufen aus DNA, die das Fragment in sich selbst schließen.

Die Adapter enthalten eine Primer-Bindestelle, die später den Startpunkt für die Polymerase liefert.

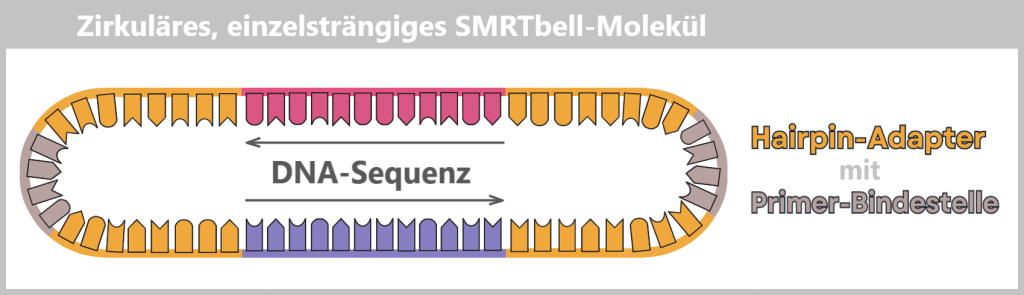

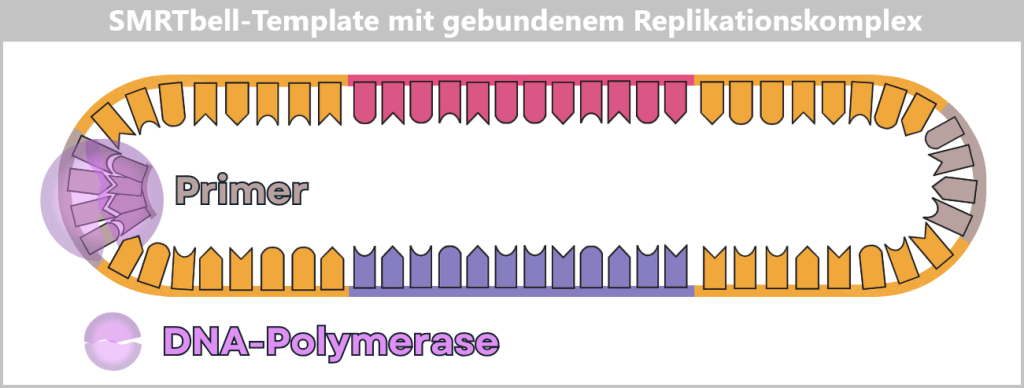

Durch anschließende Denaturierung entsteht ein zirkuläres, einzelsträngiges SMRTbell-Molekül in Form einer offenen Schlaufe.

Durch Denaturierung entsteht aus der doppelsträngigen Vorlage ein einzelsträngiges SMRTbell-Molekül. Dieses bildet eine zirkuläre Struktur, die in der Darstellung als geöffnete Schlaufe erscheint.

Das Ergebnis ist ein SMRTbell: ein geschlossener DNA-Ring, der von der Polymerase beliebig oft gelesen werden kann – wie eine Modelleisenbahn, die im Kreis fährt.

Jeder Hairpin-Adapter enthält eine definierte Bindungsstelle, an der der universelle Primer bindet. Das ist der Startpunkt für die Polymerase.

Die DNA-Polymerase lagert sich an den Primer-Komplex an. Es entsteht ein voll funktionsfähiger Replikationskomplex: Polymerase + Primer + SMRTbell.

Der Primer ist an die Adapter-Bindestelle gebunden, die Polymerase an den Primer. Dieser Komplex ist startbereit für die DNA-Synthese.

Schritt 2: Die Sequenzierbühne

– Lichtspiele im Nanomaßstab –

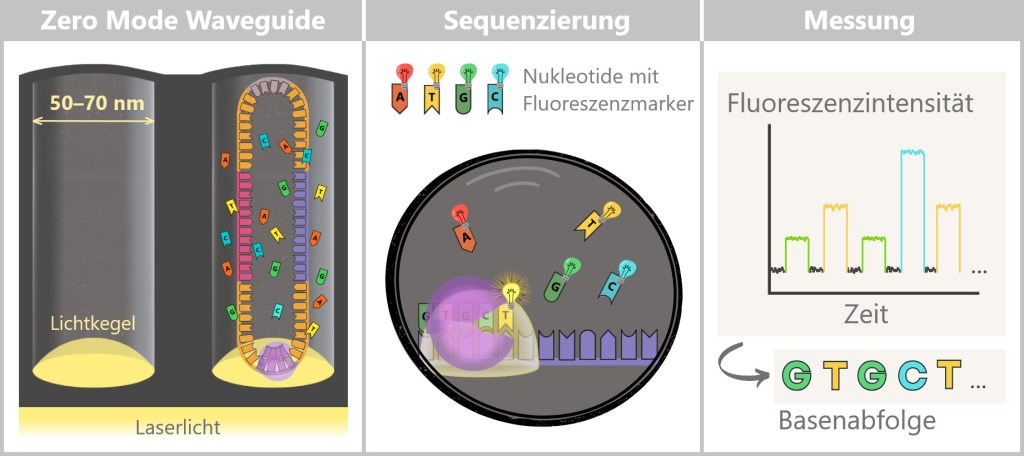

Jetzt wird es spektakulär: Die vorbereiteten Replikationskomplexe werden in ihre winzigen Beobachtungskammern geleitet – die Zero Mode Waveguides (ZMWs). Diese Nanokammern sind so klein, dass in der Regel nur ein einziges SMRTbell-Template Platz findet. Die Polymerase ist dabei fest am Boden des ZMWs verankert und wartet auf ihren Einsatz.

Das Startsignal gibt die Zugabe der vier Nukleotide (A, C, G, T), die jeweils mit einem eigenen Fluoreszenzfarbstoff markiert sind.

Die Polymerase beginnt nun mit ihrer Arbeit – sie liest den DNA-Strang und baut einen komplementären Strang auf. Sobald sie ein Nukleotid einbaut, passiert das Entscheidende:

Jedes Nukleotid sendet einen kurzen, farbcodierten Lichtblitz aus.

Links: Am Boden des Zero Mode Waveguides (ZMW) tritt ein Laserstrahl ein, der ein sogenanntes evaneszentes Feld (dargestellt als Lichtkegel) erzeugt. Dieses Feld breitet sich nicht wie normales Licht in die Lösung aus, sondern klingt innerhalb von nur 20–30 Nanometern exponentiell ab. Dadurch entsteht ein extrem kleines Anregungsvolumen, in dem die Fluoreszenzfarbstoffe der Nukleotide angeregt werden können.

Im linken Zero Mode Waveguide (ZMW) befindet sich ein einzelner Replikationskomplex (Polymerase + SMRTbell). Die Polymerase (lila) ist dabei fest am (Glas-)Boden verankert. Mit Anwesenheit der Fluoreszenz-markierten Nukleotide beginnt die Polymerase mit ihrer Arbeit.

Mitte: Die vier Nukleotide (A, T, G, C) tragen unterschiedliche Fluoreszenzmarker. Sobald die Polymerase ein Nukleotid einbaut, leuchtet es kurz auf, bevor der Farbstoff abgespalten wird.

Rechts: Diese Lichtblitze werden in Echtzeit gemessen und in Fluoreszenzsignale übersetzt. So entsteht Schritt für Schritt die Basenabfolge der DNA.

Das Leuchten geschieht in Echtzeit, genau im Moment der Einfügung – daher der Name: Single Molecule Real-Time Sequencing. Ein empfindlicher Detektor zeichnet diese Lichtsignale auf –wie ein molekulares Live-Mikroskop bei der Arbeit.

Schritt 3: Das Geheimnis der Langstrecke

– Wiederholung macht’s robust –

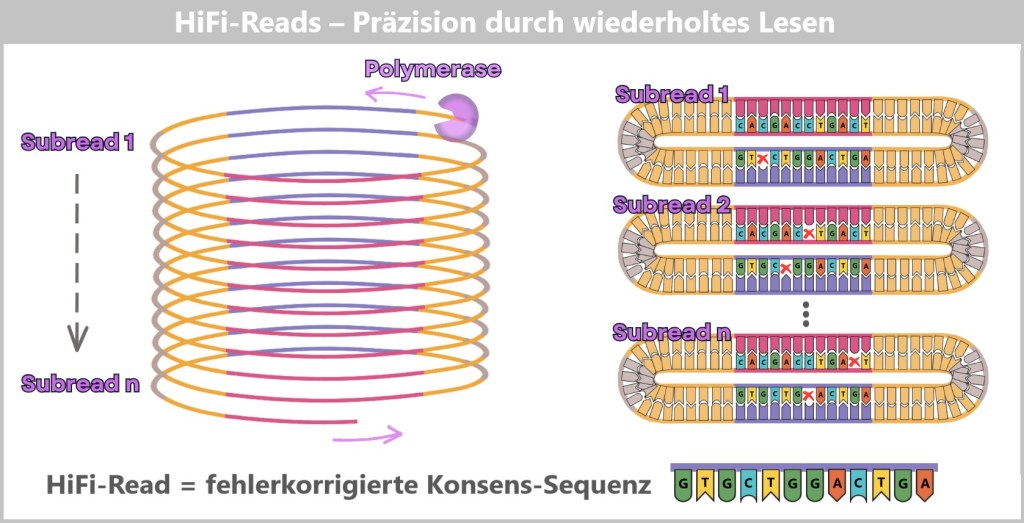

Da PacBio sehr lange DNA-Abschnitte auf einmal liest – vergleichbar mit dem Lesen ganzer Buchkapitel statt einzelner Verse, treten bei einem einzelnen Durchlauf mehr Einzelfehler auf als bei Illumina. Genau hier kommt die ringförmige SMRTbell-Struktur zum Einsatz. Die DNA-Polymerase kann wie ein Zugführer das Ringmolekül mehrfach umrunden. Dabei wird das gleiche DNA-Fragment immer wieder gelesen – wie ein Vorleser, der sich mehrfach an denselben Text wagt, bis er ihn sicher beherrscht.

Ein Computer gleicht die Wiederholungen miteinander ab und filtert die Fehler heraus – wie ein Lektor, der ein Manuskript glättet. So entsteht eine besonders präzise Konsens-Sequenz.

PacBio nennt dieses Verfahren HiFi-Reads – hochpräzise Einzelmolekül-Lesungen.

Die Polymerase wandert mehrfach um das zirkuläre SMRTbell-Template und erzeugt dabei mehrere Subreads. Jeder Umlauf entspricht einer vollständigen Ablesung der DNA-Sequenz. Einzelne Subreads können zufällige Fehler (x) enthalten, doch durch den Vergleich vieler Wiederholungen wird ein hochpräziser Konsens gebildet – der sogenannte HiFi-Read (High-Fidelity Read).

Zusatzinfo: Wie die Polymerase mehrfach um die DNA läuft

Erster Sequenzierungsdurchlauf

Die Polymerase liest den einzelsträngigen Template-Strang ab und synthetisiert dabei einen komplementären Strang.

Das Ergebnis ist eine vollständige Doppelhelix – der ursprüngliche Template-Strang und der neu entstandene Tochterstrang sind nun fest miteinander verbunden.

Aus dieser ersten, ununterbrochenen Umrundung entsteht ein Subread – also eine einzelne Basenabfolge, die von der Polymerase in einem Durchlauf erzeugt wurde.

Zweite und weitere Sequenzierungsdurchläufe

Nun stellt sich die Frage: Wie kann die Polymerase weiterlesen, wenn doch der DNA-Ring bereits doppelsträngig ist?

Hier kommt die Φ29-Phagen-DNA-Polymerase ins Spiel – eine speziell modifizierte Enzymvariante mit zwei entscheidenden Eigenschaften:

Hohe Prozessivität: Sie bleibt sehr lange am DNA-Strang gebunden und löst sich kaum – das ermöglicht die langen Reads.

Starke Strangverdrängungsaktivität: Sie kann Wasserstoffbrückenbindungen zwischen Template- und Tochterstrang aufbrechen.

Die Polymerase läuft in die Doppelhelix hinein, trennt die Stränge lokal auf und verdrängt den alten Tochterstrang, während sie gleichzeitig einen neuen synthetisiert – wie ein molekularer Bulldozer.

Der zuvor gebildete Strang wird dabei nicht abgebaut, sondern bleibt als loser, einzelsträngiger DNA-Faden in der Nanokammer zurück. Bei jeder weiteren Runde wiederholt sich dieser Prozess: Die Polymerase liest dasselbe Template erneut ab – und erzeugt dadurch mehrere Subreads vom gleichen DNA-Molekül.

Schritt 4: Datenanalyse

– Aus Lichtblitzen wird lesbare DNA –

Sind alle Lichtsignale eingefangen, beginnt die eigentliche Detektivarbeit: die Datenanalyse.

Der erste Schritt ist das sogenannte Base-Calling: Dabei werden die aufgezeichneten Fluoreszenzsignale – zeitlich und farblich codiert – in Nukleotidsequenzen übersetzt – A, T, G oder C.

Anschließend werden die Rohdaten jedes Polymerase-Umlaufs bereinigt: Die Hairpin-Adapter-Sequenzen werden bioinformatisch abgetrennt. Zurück bleiben die sogenannten Subreads – die ungekürzten Leseprotokolle jedes einzelnen Rundgangs der Polymerase durch den DNA-Kapiteltext.

Doch erst der nächste Schritt enthüllt die volle Wahrheit: Wie ein philologischer Meisterdetektiv, der mehrere Abschriften eines Manuskripts vergleicht, kombiniert der Algorithmus alle Subreads desselben SMRTbell-Moleküls. Aus diesem Vergleich – Circular Consensus Sequencing (CCS) genannt – entsteht ein hochpräziser HiFi-Read: eine fehlerbereinigte Masterkopie, die das DNA-Kapitel wortgetreu wiedergibt.

Erst jetzt ist das Textfragmentbereit für die finale Einordnung – und durchläuft dabei mehrere Stationen:

Zunächst eine Qualitätskontrolle, ganz wie ein sorgfältiges Lektorat, das den Text auf Klarheit und Stimmigkeit prüft.

Darauf folgt das Alignment: Die Sequenz wird wie ein neues Kapitel ins richtige Fach eines Referenzgenom-Regals eingeordnet.

Schließlich erfolgt die Assemblierung – der Schlussakt, bei dem alle Kapitel zu einem vollständigen Roman des Genoms zusammengefügt werden.

Das Video PacBio Sequencing – How it Works fasst die Schritte anschaulich zusammen.

Anwendung und Vorteile – Die Stärken der Langleser

Die PacBio-SMRT-Technologie hat eine besondere Stärke: Sie kann sehr lange DNA-Abschnitte am Stück lesen – mit höchster Genauigkeit. Das macht sie ideal für:

- Das Erkennen komplexer Genomstrukturen

- Die Analyse wiederholungsreicher Abschnitte

- Die Unterscheidung sehr ähnlicher Genvarianten (z. B. bei Immunrezeptoren oder in der Krebsgenetik)

- De-novo-Sequenzierung – also das vollständige Lesen neuer Genome ohne Referenz

- Das Aufspüren von epigenetischen Modifikationen (z.B. Methylierungen)

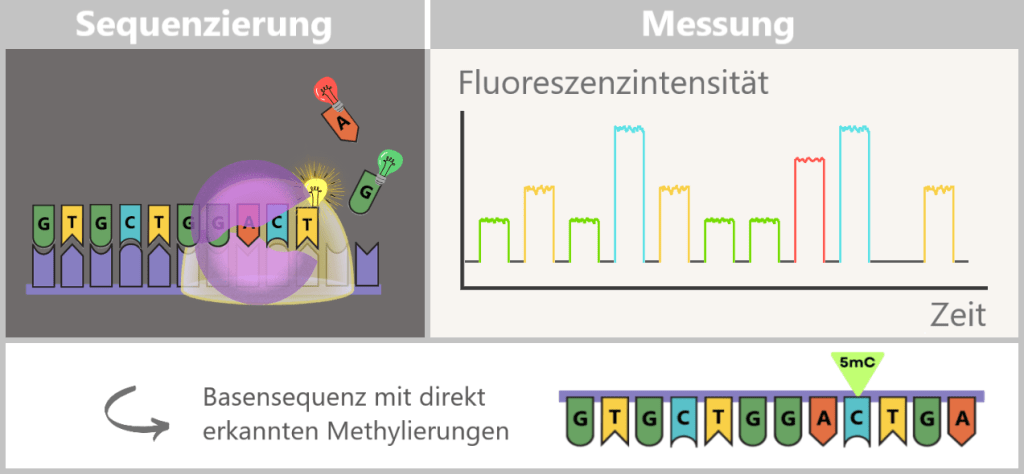

Wie kann SMRT epigenetische Modifikationen sichtbar machen?

Wie bereits beschrieben, spielen epigenetische Mechanismen eine zentrale Rolle bei der gezielten Genregulation. Es handelt sich um kleine chemische Markierungen – etwa Methylgruppen – die an bestimmte DNA-Basen angeheftet werden. Sie verändern nicht die genetische Sequenz selbst, sondern beeinflussen, wann und wie oft Gene abgelesen werden – abhängig von Zelltyp, Umgebung oder Entwicklungsstadium.

Sie funktionieren wie Notizen oder Markierungen am Seitenrand eines Buches: Der Text bleibt derselbe, aber die „Lesart“ ändert sich – manche Passagen werden betont, andere überblättert.

Gerät dieses fein abgestimmte System aus dem Gleichgewicht, kann das weitreichende Folgen haben – etwa bei Krebs, Autoimmunerkrankungen oder psychischen Störungen.

Im Gegensatz zur Illumina-Technologie, die eine chemisch veränderte Kopie der DNA liest, analysiert SMRT die Original-DNA in Echtzeit. Dabei wird nicht nur die Basenabfolge, sondern auch die Verweildauer der DNA-Polymerase an jeder Base – die sogenannte Einbaukinetik – gemessen.

Genau hier liegt der Schlüssel zum Nachweis epigenetischer Modifikationen: Methylierungen und andere chemische Veränderungen beeinflussen diese Kinetik. Sie wirken wie kleine Hindernisse oder Bremsspuren auf dem DNA-Strang. Die Polymerase „verharrt“ an solchen Stellen länger – und genau diese Verzögerung wird von der SMRT-Kamera direkt erfasst.

SMRT eignet sich besonders gut zur direkten Detektion bestimmter chemischer Markierungen, etwa Methylgruppen an Adenin- oder Cytosin-Basen, die vor allem in Bakterien und Pflanzen eine wichtige Rolle spielen. Für die in der humanen Epigenetik zentrale Cytosin-Methylierung (5mC) ist die direkte Detektion weniger sensitiv, kann aber mithilfe spezialisierter Bioinformatik-Tools wie pb-CpG-tools zuverlässig abgeleitet werden.

Wie SMRT epigenetische Modifikationen sichtbar macht

Während der SMRT-Sequenzierung werden die Fluoreszenzsignale der eingebauten Nukleotide in Echtzeit gemessen. Gleichzeitig können Modifikationen wie 5-Methylcytosin (5mC) erkannt werden, da sie die Kinetik der Polymerase leicht verändern.

Der entscheidende Vorteil: Die extrem langen Leselängen enthüllen, wie sich Methylierungsmuster über große genomische Regionen mit anderen Faktoren verschränken – etwa mit:

- Genvarianten,

- Haplotypen (Gruppen von gemeinsam vererbten Genvarianten),

- repetitiven Sequenzen.

So liefert PacBio nicht nur die genetische Buchstabenfolge, sondern eine „Landkarte“ der epigenetischen Steuerung – und macht sichtbar, welche „Buchseiten“ funktionell zusammengehören und wie diese Vernetzung Krankheitsprozesse wie Krebs oder neurologische Störungen beeinflusst.

Defekte Scheren im Genom: Wie PacBio Splice-Site-Varianten enttarnt

Im Abschnitt Alternatives Splicing: Die flexible Küche der Gene wurde vereinfacht beschrieben, wie unsere DNA als molekulares Kochbuch Rezepte in Gestalt von mRNA-Abschriften erzeugt. Diese transportieren die genetische Information aus dem Zellkern zu den Ribosomen im Zytoplasma – den „Protein-Fabriken“ der Zelle.