Der andauernde Hype um den Chatbot ChatGPT von OpenAI veranschaulicht die Tatsache, dass sich KI-Systeme nicht nur rasant entwickeln, sondern auch die Gesellschaft verändern.

Zu den beeindruckendsten Eigenschaften von ChatGPT gehören die Zugänglichkeit, die Benutzerfreundlichkeit und die Ausgereiftheit der natürlichsprachlichen Antworten. Mögliche Anwendungsgebiete sind:

- Automatisierte Erstellung von Inhalten, wie Blog-Artikel oder Produktbeschreibungen

- Generierung von Software Code in verschiedenen Programmiersprachen

- Automatische Übersetzungen in verschiedenen Sprachen

- Entwicklung von virtuellen Assistenten im Kundenservicebereich

- Automatische Generierung von Musik

- Automatische Generierung von medizinischen Diagnoseberichten

- Automatische Berichterstellung in verschiedenen Branchen wie Finanzen, Recht und Wissenschaft

- Automatische Erstellung von Lernmaterialien

- u.v.m.

Eine kurze Zusammenfassung zu diesem Thema liefert dieser ARD-Beitrag.

Der Chatbot von Open AI ist ein mächtiges Modell der natürlichen Sprachverarbeitung und hat das Potenzial, die Art und Weise, wie wir mit Computern interagieren, zu verändern.

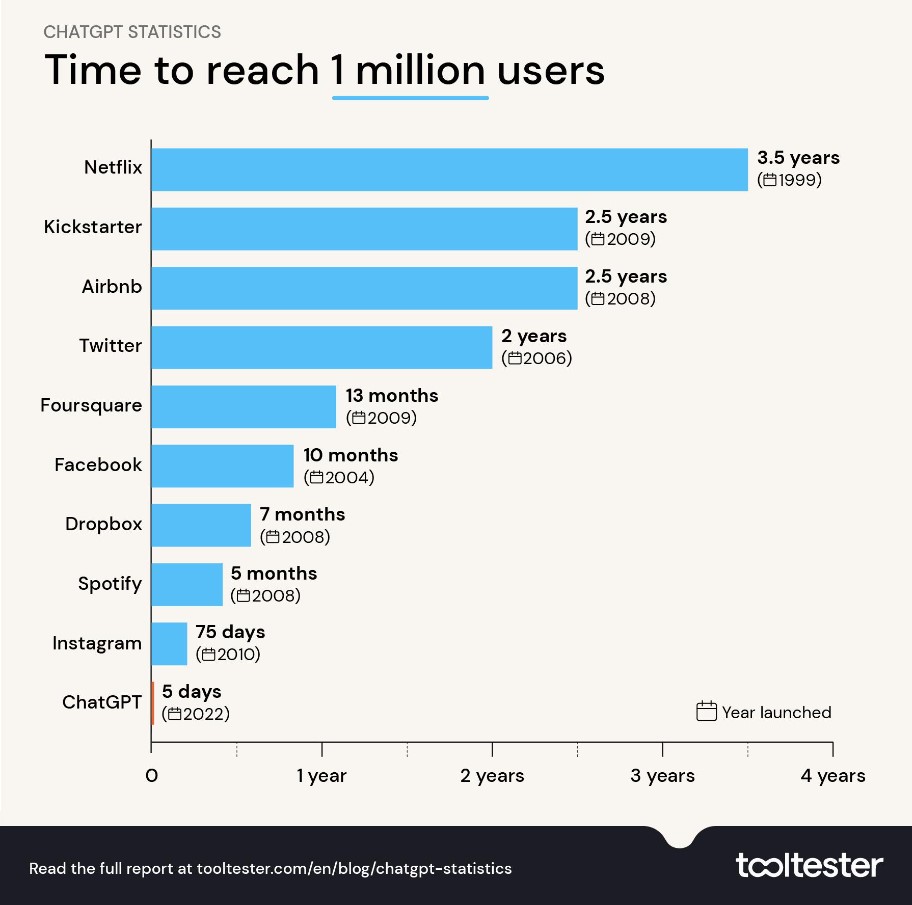

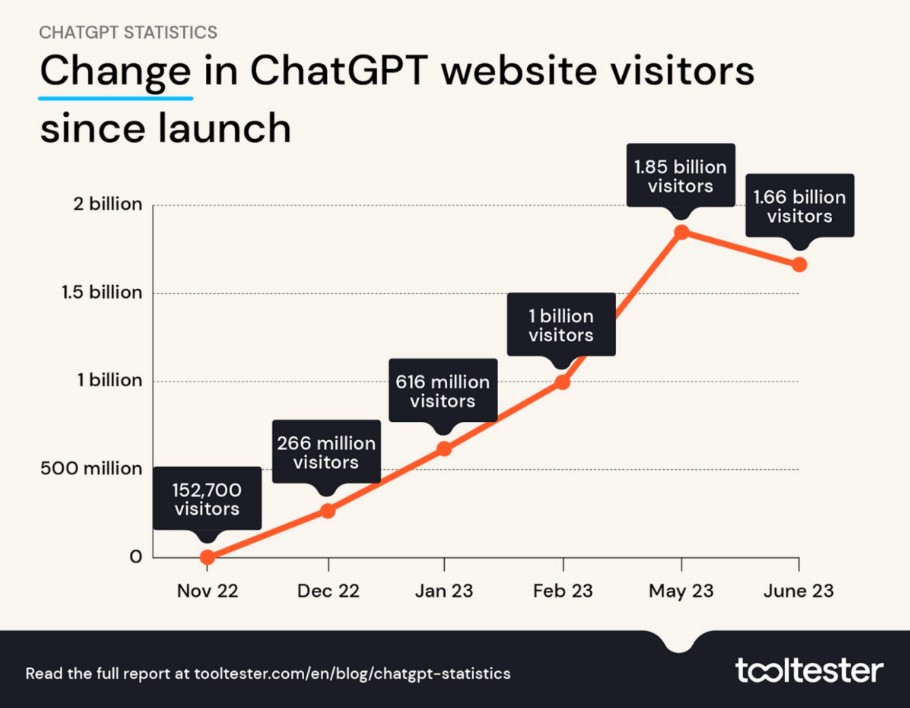

Schneller als jeder andere Online Service hatte ChatGPT in nur 5 Tagen nach der Vorstellung in der Öffentlichkeit Ende November 2022 die erste Million Nutzer.

Vier Monate später erreichten die Nutzerzahlen weltweit die 1 Milliarde Marke.

Heutzutage verlassen sich noch die meisten Menschen in ihrem privaten und beruflichen Alltag auf Google, Wikipedia und weiteren Datenbanken und vertrauen zweifelsfrei, dass die darin enthaltenen Inhalte weitgehend korrekt sind. Angesichts des zu erwartenden Fortschritts bei großen Sprachmodellen in den nächsten Jahren könnte man sich also vorstellen, dass kurz- bis mittelfristig auch KI-Chatbot-Antworten dieses Maß an Vertrauen genießen werden.

Und damit dies lieber heute als morgen geschieht, hat sich eine Allianz aus „besorgten“ Politikern und Unternehmern wie Elon Musk gebildet, die eine strikte Regelung von KI fordern.

Auf diese Weise soll die Künstliche Intelligenz vom Menschen kontrollierbar bleiben. Sogar der OpenAI-CEO, Sam Altman, hat jüngst gefordert, eine internationale Einrichtung wie die Atomenergiebehörde IAEA zur Regulierung von KI zu schaffen. Zu den größten Risiken, die im Kontext von ChatGPT genannt wurden, gehört der mögliche Missbrauch durch Kriminelle und Terroristen. Sorgen bereiten aber auch Falschinformationen, die der Bot produziert, oder die möglichen Auswirkungen von KI auf den Arbeitsmarkt. [THE EPOCH TIMES]

Der WEF-Berater, Yuval Harari, wird diesbezüglich konkreter. Bei seinem „pathetischen“ Auftritt vor dem Frontiers Forum in Mai 2023 benennt er die Gefahren in Bezug auf den unregulierten Einsatz von KI-Systemen. Im Nachfolgenden sind einige Auszüge aus seiner Rede „AI and the future of humanity“ gelistet:

„Wenn die Leute an ChatGPT und die anderen neuen KI-Tools denken, werden oft Beispiele herangezogen, wie Kinder, ChatGPT benutzen, um ihre Schulaufsätze zu schreiben. Was wird mit dem Schulsystem geschehen, wenn Kinder Aufsätze mit ChatGPT schreiben? Furchtbar. Aber diese Art von Frage verfehlt das große Ganze. Vergessen Sie die Schulaufsätze. Stattdessen denken Sie zum Beispiel an die nächsten US-Präsidentschaftswahlen im Jahr 2024 und versuchen Sie sich die Auswirkungen der neuen KI-Tools vorzustellen, die massenhaft politische Manifeste, gefälschte Nachrichten und sogar heilige Schriften für neue Sekten erstellen und verbreiten.“

„Wir könnten uns bald in langen Online-Diskussionen über Abtreibung oder über den Klimawandel oder über die russische Invasion in der Ukraine mit Wesen wiederfinden, die wir für Mitmenschen halten, in Wirklichkeit aber KI-Bots sind. Der Haken an der Sache ist, dass es völlig sinnlos ist, unsere Zeit damit zu verschwenden, einen KI-Bot davon zu überzeugen, seine politischen Ansichten zu ändern. Aber je länger wir mit dem Bot sprechen, desto besser lernt er uns kennen und versteht, wie er seine Botschaften verfeinern kann, um unsere politischen oder unsere wirtschaftlichen Ansichten oder sonst etwas zu manipulieren. Wie ich sagte, kann die KI durch die Beherrschung der Sprache intime Beziehungen zu Menschen aufbauen und die Macht der Intimität nutzen, um unsere Meinungen zu beeinflussen.“

„Neue KI-Werkzeuge würden einen immensen Einfluss auf menschliche Meinungen und unser Weltbild haben. Die Menschen könnten zum Beispiel dazu kommen, einen einzigen KI-Berater als das One-Stop-Orakel und als Quelle für alle Informationen, die sie benötigen, zu verwenden.“

„Menschen und Unternehmen, die die neuen KI-Orakel kontrollieren, werden extrem mächtig sein.“

„Schauen Sie sich nur die sozialen Medien an. In den letzten Jahren haben die sozialen Medien einen kleinen Vorgeschmack auf das, was kommen wird, gegeben. In den sozialen Medien wurden primitive KI-Werkzeuge eingesetzt, nicht zur Erstellung von Inhalten, sondern zum Kuratieren der Inhalte, die von Menschen produziert werden. Und obwohl diese KI-Werkzeuge sehr primitiv sind, haben sie dennoch ausgereicht, um diese Art von Vorhang aus Illusionen zu schaffen, der die gesellschaftliche Polarisierung auf der ganzen Welt vorantreibt, unsere geistige Gesundheit untergräbt und die demokratischen Gesellschaften destabilisiert. Millionen von Menschen haben diese Illusionen mit der Realität verwechselt.“

„Die USA verfügen über die mächtigste Informationstechnologie in der gesamten Geschichte und trotzdem können sich die amerikanischen Bürger nicht mehr einigen, wer die letzten Wahlen gewonnen hat, ob der Klimawandel real ist oder ob Impfstoffe Krankheiten verhindern oder nicht. Die neuen KI-Tools sind weitaus leistungsfähiger als diese Social Media Algorithmen und könnten weitaus mehr Schaden anrichten.“

„KI kann noch leistungsfähigere KI hervorbringen. Wir müssen schnell handeln, bevor KI außer Kontrolle gerät und unserer eigenen Kontrolle entgleitet. Arzneimittelhersteller können den Menschen keine neuen Medikamente verkaufen, ohne zuvor diese Produkte strengen Sicherheitsprüfungen zu unterziehen. Biotech-Labore können nicht einfach ein neues Virus in die Öffentlichkeit bringen, um ihre Aktionäre mit der technologischen Zauberei zu beeindrucken. Ebenso müssen die Regierungen unverzüglich die Freigabe weiterer revolutionärer KI-Tools für die Öffentlichkeit verbannen, bevor sie sicher gemacht werden.“

„Ich spreche nicht davon, die gesamte KI-Forschung einzustellen. Der erste Schritt besteht darin, die Freigabe für die Öffentlichkeit zu verhindern. Man kann Viren erforschen, ohne sie der Öffentlichkeit zugänglich zu machen. Sie können KI-Forschung betreiben, aber sie nicht zu schnell in die Öffentlichkeit zu bringen.“

„Der unregulierte Einsatz von KI wird dazu führen, dass Demokratien gegen Diktaturen verlieren. Denn wenn wir das Chaos entfesseln, können autoritäre Regime dieses Chaos leichter als offene Gesellschaften eindämmen.“

Dass eine breite gesellschaftliche Debatte über den massiven Einsatz von künstlicher Intelligenz im Alltagsleben im Vorfeld vor deren Implementierung notwendig ist, steht hier nicht zur Debatte. An dieser Stelle kann man die Besorgnis von Herrn Harari teilen. Die Frage ist, von wem und wie diese Diskussion geführt wird und wie dann entsprechende regulatorische Entscheidungen getroffen werden.

In der Rede vom WEF-Berater Harari werden folgende Themen und Begriffe subtil in Relation gebracht:

Präsidentschaftswahlen – politische Manifeste – gefälschte Nachrichten – Sekten

Klimawandel – Russische Invasion in der Ukraine – KI-Bot – Manipulation

KI-Oracle – Kontrolle – Macht

Illusionen – Wahlen – Klimawandel – Impfstoffe – Schaden

KI-Kontrolle – Medikamente – Sicherheitsprüfung – Biotech Labor – Virus

Virenforschung – KI-Forschung

Chaos – autoritäre Regime – offene Gesellschaft

Medikamente SICHER – Biotech-Labore SICHER – KI muss SICHER sein

Die Erzeuger von ChatGPT und ähnlichen KI-Tools sind dieselben, die die bisherige Vernetzung der Gesellschaft maßgeblich vorangetrieben haben. Aus langjähriger Erfahrung wissen sie bereits, dass es Menschen gern bequem haben. Denn dies sorgt dafür, dass sich diejenigen Techniken durchsetzen, die unkompliziert und einfach zu handhaben sind. Ein einziger universeller KI-Berater wie das One-Stop-Orakel, als Quelle für alle Informationen die man benötigt, ist die logische Fortsetzung dieser bereits bewährten Strategie.

Doch wer andere die Arbeit für sich machen lässt, zahlt einen hohen Preis. Neben der fehlenden Privatsphäre kommt beim Umgang mit einer generativen KI auch das wachsende Potential einer subtilen, unterschwelligen Manipulation einzelner Ansichten bis hin zur Gesamtweltanschauung, sowie die schleichende Entfremdung von der realen Welt hinzu. Im Namen der Bequemlichkeit ist man sogar bereit, einen Teil der eigenen Selbständigkeit/Souveränität aufzugeben. Im weitesten Sinne kann man diesen Schritt als einen Meilenstein auf dem Weg zum Transhumanismus betrachten.

„KI-Oracle – Kontrolle – Macht“ – das ist der Kernpunkt, der zeitlich gut getimten und inszenierten KI-Regulierungsdebatte. Durch das KI-Oracle kann man die Hauptnarrative der Gegenwart (Klimawandel, Impfstoffe/Gesundheit, Pandemien, Kriege) sehr effizient, schnell, dauerhaft und subtil in das Bewusstsein jedes Einzelnen platzieren. Das KI-Oracle wird sukzessiv als Fenster zur „realen Welt“ etabliert. Und wie die „reale Welt“ oder besser gesagt die Illusion davon aussieht, definiert das KI-Oracle (oder die Kräfte, die ihn kontrollieren oder „glauben zu kontrollieren“). Am Tag X kann das KI-Oracle auch „unbewusst“ Chaos produzieren, das dann nur durch ein „temporäres“ autoritäres Regime in den Griff zu bekommen ist.

So gesehen, kann man die Rede von Harari „AI and the future of humanity“ als Offenbarung betrachten.

Auf der Suche nach konkreten Informationen wie man die Künstliche Intelligenz in der EU regulieren will, stößt man auf den sogenannten AI Act.

In dem Artikel „AI Act erklärt…“ liest man folgendes:

„Wie kann Künstliche Intelligenz transparenter, fairer und sicherer werden? Die EU will mit ihrer KI-Verordnung – dem Artificial Intelligence Act, kurz AI Act – eine an ethischen Grundsätzen orientierte Regulierung schaffen, ohne dabei Innovationen wie ChatGPT zu bremsen.“

„Das übergeordnete Ziel dieser Verordnung sind einheitliche Vorgaben für die Verwendung von KI-Systemen innerhalb der Europäischen Union. Sie soll dafür sorgen, dass diese Anwendungen nicht gegen Grundrechte verstoßen und keine negativen Auswirkungen auf die Sicherheit und Gesundheit von Menschen haben. Dabei folgt das Gesetz einem risikobasierten Ansatz: Künstliche Systeme und ihre Anwendungen müssen Anforderungen erfüllen, die auf dem von ihnen wahrgenommenen Risikoniveau basieren.“

Am 11. Mai haben die zuständigen Parlamentsausschüsse für Bürgerrechte und Verbraucherschutz im Europäischen Parlament den entsprechenden KI-Gesetzentwurf der EU gebilligt und ihn damit näher an die Verabschiedung gebracht. Am 16. Juni verabschiedete das Europäische Parlament seine Verhandlungsposition zum Gesetz über künstliche Intelligenz (KI) im Vorfeld der Gespräche mit den EU-Mitgliedstaaten über die endgültige Ausgestaltung des Gesetzes. Der weitere Zeitplan sieht vor, dass der Vorschlag für das AI-Gesetz wahrscheinlich bis Ende 2023 verabschiedet wird. Danach wird eine zweijährige Umsetzungsfrist erwartet, was bedeutet, dass das Gesetz wahrscheinlich bis 2026 in Kraft treten wird.

Die Regeln würden sicherstellen, dass die in Europa entwickelte und genutzte KI in vollem Einklang mit den Rechten und Werten der EU steht, einschließlich menschlicher Aufsicht, Sicherheit, Privatsphäre, Transparenz, Nichtdiskriminierung sowie sozialem und ökologischem Wohlergehen.

Aus diesem Grund kann es nicht schaden, sich den entsprechenden KI-Gesetzentwurf genauer anzuschauen. In diesem Zusammenhang sind folgende Dokumente öffentlich zugänglich:

Dokument 1: Vorschlag für eine Verordnung des Europäischen Parlaments und des Rates zur Festlegung harmonisierter Vorschriften für künstliche Intelligenz

(Gesetz über Künstliche Intelligenz)

Dokument 2: Anhänge des Vorschlags für das Gesetz über Künstliche Intelligenz

Dokument 3: Abänderungen des Europäischen Parlaments vom 14. Juni 2023 zu dem Vorschlag für eine Verordnung des Europäischen Parlaments und des Rates zur Festlegung harmonisierter Vorschriften für künstliche Intelligenz

(Gesetz über Künstliche Intelligenz)

Im Nachfolgenden werden wir uns einige Passagen aus diesen Dokumenten genauer anschauen.

Dokument 1:

Kapitel 1.1. Gründe und Ziele des Vorschlags

Dieser Vorschlag geht auf das politische Engagement der Präsidentin von der Leyen zurück…

Im Nachgang zu dieser Ankündigung veröffentlichte die Kommission am 19. Februar 2020 ihr Weißbuch zur KI – Ein europäisches Konzept für Exzellenz und Vertrauen. In dem Weißbuch legt sie die politischen Optionen dar, wie die Nutzung von KI gefördert und gleichzeitig die mit bestimmten Anwendungen dieser Technologie verbundenen Risiken eingedämmt werden können. Dieser Vorschlag zielt darauf ab, einen Rechtsrahmen für eine vertrauenswürdige KI zu schaffen, damit das zweite Ziel für den Aufbau eines Ökosystems für Vertrauen umgesetzt werden kann. Der Vorschlag beruht auf den Werten und Grundrechten der EU und will erreichen, dass Privatpersonen und andere Nutzer KI-gestützten Lösungen vertrauen und gleichzeitig Unternehmen Anreize erhalten, diese zu entwickeln.

…damit Menschen darauf vertrauen können, dass die Technik sicher angewandt wird und den Gesetzen, auch den Grundrechten, genügt.

Mit Blick auf diese Ziele enthält dieser Vorschlag einen ausgewogenen horizontalen Regulierungsansatz für KI, der die Verhältnismäßigkeit wahrt und auf die Mindestanforderungen beschränkt ist, die zur Bewältigung der in Verbindung mit KI auftretenden Risiken und Probleme notwendig ist, ohne die technologische Entwicklung übermäßig einzuschränken oder zu behindern oder anderweitig die Kosten für das Inverkehrbringen von KI-Lösungen unverhältnismäßig in die Höhe zu treiben. Der Vorschlag zielt auf einen robusten und flexiblen Rechtsrahmen ab.

Mit anderen Worten, das KI-Gesetz zielt in erster Linie auf die Erhöhung der Akzeptanz von KI-Systemen in die Bevölkerung ab durch vertrauensbildende Maßnahmen. Diese wiederum beschränken sich auf Mindestanforderungen und zielen nicht wirklich auf die Einschränkung der technologischen Entwicklung und deren massiven Einsatz. Man spricht von einem Gesetz mit einem flexiblen Rechtsrahmen.

Wenn man sich an die „Teleskopierung“ bei der Entwicklung der neuartigen Covid-19 Impfstoffen und „Rolling Reviews“ in der Zulassung sowie an die damit verbundenen gravierenden Impfrisiken erinnert, hinterlassen solche Formulierungen einen faden Beigeschmack. Die Schlagwort-Kombinationen aus der Rede von Harari scheinen damit zu korrelieren:

KI-Kontrolle – Medikamente – Sicherheitsprüfung – Biotech Labor – Virus

Virenforschung – KI-Forschung

Dokument 1: / Dokument 3:

TITEL II VERBOTENE PRAKTIKEN IM BEREICH DER KÜNSTLICHEN INTELLIGENZ

Kapitel 5

(1) Folgende Praktiken im Bereich der künstlichen Intelligenz sind verboten:

a) das Inverkehrbringen, die Inbetriebnahme oder die Verwendung eines KI-Systems, das Techniken der unterschwelligen Beeinflussung außerhalb des Bewusstseins einer Person oder absichtlich manipulative oder täuschende Techniken einsetzt, mit dem Ziel oder der Folge, dass das Verhalten einer Person oder einer Gruppe von Personen, indem die Fähigkeit der Person, eine fundierte Entscheidung zu treffen, spürbar beeinträchtigt wird, wodurch die Person veranlasst wird, eine Entscheidung zu treffen, die sie andernfalls nicht getroffen hätte, und zwar in einer Weise, die dieser Person, einer anderen Person oder einer Gruppe von Personen erheblichen Schaden zufügt oder zufügen kann;

b) das Inverkehrbringen, die Inbetriebnahme oder die Verwendung eines KI-Systems, das eine Schwäche oder Schutzbedürftigkeit einer Person oder einer bestimmten Gruppe von Personen einschließlich der Merkmale der bekannten oder vorhergesagten Persönlichkeitsmerkmale oder der sozialen oder wirtschaftlichen Situation der Person oder Gruppe von Personen, ihres Alters oder ihrer körperlichen oder geistigen Fähigkeiten ausnutzt, mit dem Ziel oder der Folge, das Verhalten dieser Person oder einer dieser Gruppe angehörenden Person in einer Weise wesentlich zu beeinflussen, die dieser Person oder einer anderen Person erheblichen Schaden zufügt oder zufügen kann;

c) das Inverkehrbringen, die Inbetriebnahme oder die Verwendung von KI-Systemen zur Bewertung des sozialen Verhaltens oder Klassifizierung natürlicher Personen oder Gruppen von natürlichen Personen über einen bestimmten Zeitraum auf der Grundlage ihres sozialen Verhaltens oder bekannter, abgeleiteter oder vorhergesagter persönlicher Eigenschaften oder Persönlichkeitsmerkmale, wobei die soziale Bewertung zu einem oder beiden der folgenden Ergebnisse führt:

i) Schlechterstellung oder Benachteiligung bestimmter natürlicher Personen oder ganzer Gruppen natürlicher Personen in sozialen Zusammenhängen, die in keinem Zusammenhang zu den Umständen stehen, unter denen die Daten ursprünglich erzeugt oder erfasst wurden;

ii) Schlechterstellung oder Benachteiligung bestimmter natürlicher Personen oder ganzer Gruppen natürlicher Personen, in einer Weise, die im Hinblick auf ihr soziales Verhalten oder dessen Tragweite ungerechtfertigt oder unverhältnismäßig ist;

d) die Verwendung biometrischer Echtzeit-Fernidentifizierungssysteme in öffentlich zugänglichen Räumen;

da) das Inverkehrbringen, die Inbetriebnahme oder die Verwendung von KI-Systemen zur Risikobeurteilung natürlicher Personen oder von Gruppen natürlicher Personen, um das Risiko einer natürlichen Person, straffällig zu werden oder erneut straffällig zu werden, einzuschätzen oder um das Auftreten oder die Wiederholung einer tatsächlichen oder potenziellen Straftat oder Ordnungswidrigkeit auf der Grundlage von Profilen natürlicher Personen oder der Bewertung von Persönlichkeitsmerkmalen, Eigenschaften, einschließlich des Standorts der Person, oder früheren kriminellen Verhaltens von natürlichen Personen oder Gruppen von natürlichen Personen vorherzusagen;

db) das Inverkehrbringen, die Inbetriebnahme oder die Nutzung von KI-Systemen, die Datenbanken zur Gesichtserkennung durch das ungezielte Auslesen von Gesichtsbildern aus dem Internet oder von Überwachungsaufnahmen erstellen oder erweitern;

dc) das Inverkehrbringen, die Inbetriebnahme oder die Nutzung von KI-Systemen zur Ableitung von Emotionen einer natürlichen Person in den Bereichen Strafverfolgung, Grenzmanagement, am Arbeitsplatz und in Bildungseinrichtungen;

dd) die Inbetriebnahme oder Nutzung von KI-Systemen zur Analyse von aufgezeichnetem Bildmaterial öffentlich zugänglicher Räume durch Systeme zur nachträglichen biometrischen Fernidentifizierung, es sei denn, sie unterliegen einer vorgerichtlichen Genehmigung im Einklang mit dem Unionsrecht und sind für die gezielte Fahndung im Zusammenhang mit einer bestimmten schweren Straftat im Sinne von Artikel 83 Absatz 1 AEUV, die bereits zum Zweck der Strafverfolgung stattgefunden hat, unbedingt erforderlich.

Dieses Kapitel soll das Vertrauensfundament des KI-Gesetzes für die Bevölkerung bilden.

Es ist lobenswert, dass laut Punkt 1c), das sogenannte „social scoring“ nach chinesischer Art verboten wird. Doch inwieweit gilt dies noch (siehe Punkt 1c [i]), wenn es sich um „…soziale Zusammenhänge,“ handelt „die im Zusammenhang zu den Umständen stehen, unter denen die Daten ursprünglich erzeugt oder erfasst wurden“?

Weiterhin stellt sich in Punkt 1c [ii] die Frage, WER definiert, was ungerechtfertigt oder unverhältnismäßig ist? Inwieweit ist der Rechtsrahmen diesbezüglich flexibel? Aufgrund der Erfahrungen aus den letzten drei Jahren sind solche Fragen nicht aus der Luft gegriffen.

Es ist weiterhin lobenswert, dass man laut Punkt 1d die biometrische Echtzeit-Fernidentifizierung konsequent verbieten will. Damit will man „chinesische Hardcore-Überwachungsszenarien“ ausschließen, die in letzter Zeit für einige Aufregung in der europäischen Öffentlichkeit gesorgt haben.

Man schließt jedoch die sogenannte nachträgliche biometrische Fernidentifizierung laut Punkt 1dd nicht komplett aus. Diese ist für die Strafverfolgung von Straftaten im Sinne von Artikel 83 Absatz 1 AEUV zulässig. Die derzeit in Artikel 83 Absatz 1 Unterabsatz 2 aufgeführten Kriminalitätsbereiche sind Terrorismus, Menschenhandel und sexuelle Ausbeutung von Frauen und Kindern, illegaler Drogenhandel, illegaler Waffenhandel, Geldwäsche, Korruption, Fälschung von Zahlungsmitteln, Computerkriminalität und organisierte Kriminalität. Das ist nachvollziehbar und steht nicht zur Debatte.

Und in dem Unterabsatz 3 lesen wir:

In dem BESCHLUSS (EU) 2022/2332 DES RATES vom 28. November 2022 über die Feststellung des Verstoßes gegen restriktive Maßnahmen der Union als einen die Kriterien nach Artikel 83 Absatz 1 des Vertrags über die Arbeitsweise der Europäischen Union erfüllenden Kriminalitätsbereich kann man folgende Formulierungen finden:

Artikel 83 Absatz 1 Unterabsatz 3 AEUV sieht ein besonderes Verfahren vor, nach dem der Rat neue Kriminalitätsbereiche bestimmen kann. Dies darf erst geschehen, nachdem die im Vertrag festgelegten Kriterien, die dem Ausnahmecharakter des Verfahrens entsprechen, einer sorgfältigen Bewertung unterzogen wurden. Die Entwicklungen der Kriminalität, die seit Russlands Angriffskrieg gegen die Ukraine zu beobachten sind, stellen außergewöhnliche Umstände dar.

Der Verstoß gegen restriktive Maßnahmen der Union zählt zu den Bereichen besonders schwerer Straftaten und ist hinsichtlich der Schwere mit den bereits in Artikel 83 Absatz 1 AEUV aufgeführten Kriminalitätsbereichen vergleichbar, da er den Weltfrieden und die internationale Sicherheit dauerhaft bedroht, die Festigung und Förderung von Demokratie, Rechtsstaatlichkeit und Menschenrechten untergräbt sowie erheblichen wirtschaftlichen, gesellschaftlichen und ökologischen Schaden verursachen kann.

Aus dieser Konstellation ist es nicht schwer zu erahnen, dass man hier ebenfalls auf einem „robusten und flexiblen“ Rechtsrahmen stößt, der in Abhängigkeit der Auslegung Begriffen wie

- Bedrohung der internationalen Sicherheit und Weltfrieden

- Untergrabung der Demokratie, Rechtstaatlichkeit und Menschenrechten

- Erheblicher wirtschaftlicher, gesellschaftlicher und ökologischer Schaden

jederzeit angepasst werden kann.

Die meisten Leser werden sicherlich sagen: „Mich betrifft das nicht. Ich mache nichts falsches.“ Bei einem flexiblen Rechtsrahmen kann sich allerdings im Laufe der Zeit die Situation ändern. In diesem Zusammenhang ist der Artikel „Die Corona-Pandemie – Möge die Bio-Macht mit Dir sein“ zu empfehlen. Im biopolitischen Sinne kann jedes Individuum in Abhängigkeit von den volatilen Regulierungsnormen ziemlich schnell vom „Inklusionsmodus“ in den „Exklusionsmodus“ wechseln und dann die Vorzüge der bereits installierten Überwachungsinfrastruktur genießen.

Kurz- bis mittelfristig werden alle EU-Bürger „stolze“ Besitzer der sogenannten e-ID sein. Damit wird die Bevölkerung „KI-konform“. Was damit gemeint ist, kann man in dem Artikel „Die europäische Digitale ID – You’ll Never Walk Alone“ nachlesen.

Und womit die Bevölkerung demnächst konfrontiert wird, zeigt sich im Dokument 2 ANHANG III.

Dokument 2: – ANHANG III – HOCHRISIKO-KI-SYSTEME / Dokument 3:

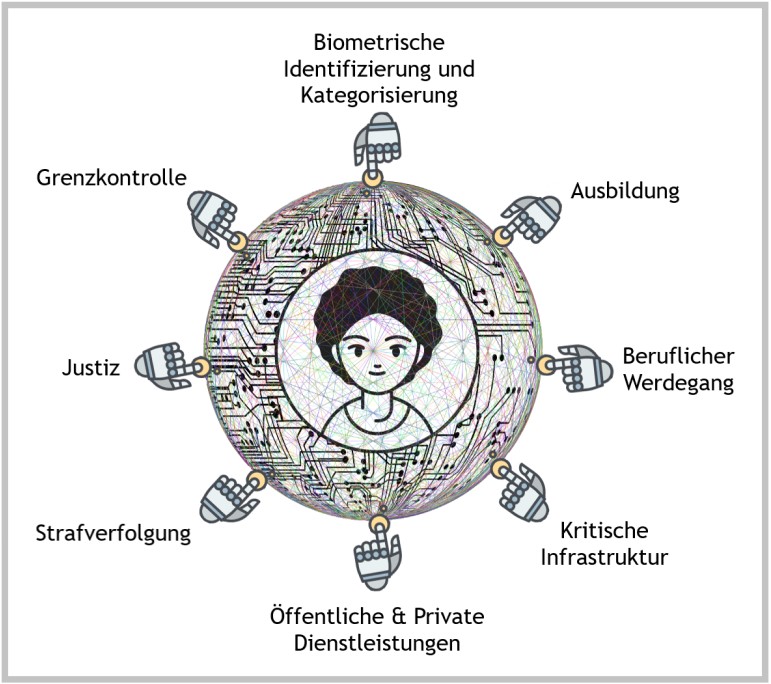

Als Hochrisiko-KI-Systeme gemäß Artikel 6 Absatz 2 gelten die in folgenden Bereichen aufgeführten KI-Systeme:

1. Biometrische und auf Biometrie beruhende Systeme

a) KI-Systeme, die bestimmungsgemäß für die biometrische Identifizierung natürlicher Personen verwendet werden sollen, mit Ausnahme der in Artikel 5 genannten Systeme;

aa) KI-Systeme, durch die auf der Grundlage biometrischer oder biometriegestützter Daten Rückschlüsse auf persönliche Merkmale natürlicher Personen gezogen werden, einschließlich Systeme zum Erkennen von Emotionen, mit Ausnahme der in Artikel 5 genannten Systeme; Nummer 1 sollte keine KI-Systeme umfassen, die bestimmungsgemäß für die biometrische Verifizierung verwendet werden sollen, deren einziger Zweck darin besteht, zu bestätigen, dass eine bestimmte Person die Person ist, für die sie sich ausgibt.

2. Verwaltung und Betrieb kritischer Infrastrukturen:

a) KI-Systeme, die bestimmungsgemäß als Sicherheitskomponenten in der Verwaltung und im Betrieb des Straßen-, Schienen- und Luftverkehrs verwendet werden sollen, es sei denn, diese werden im Rahmen von Harmonisierungs- oder sektorspezifischen Rechtsvorschriften geregelt.

aa) KI-Systeme, die bestimmungsgemäß als Sicherheitskomponenten in der Verwaltung und im Betrieb der Wasser-, Gas-, Wärme- und Stromversorgung sowie kritischer digitaler Infrastruktur verwendet werden sollen;

3. Allgemeine und berufliche Bildung:

a) KI-Systeme, die bestimmungsgemäß für Entscheidungen über den Zugang oder zur erheblichen Einflussnahme auf Entscheidungen über die Zulassung oder die Zuweisung natürlicher Personen zu Einrichtungen der allgemeinen und beruflichen Bildung verwendet werden sollen;

b) KI-Systeme, die bestimmungsgemäß für die Bewertung von Schülern in Einrichtungen der allgemeinen und beruflichen Bildung und für die Bewertung der Teilnehmer an üblicherweise für die Zulassung zu diesen Einrichtungen erforderlichen Tests verwendet werden sollen;

ba) KI-Systeme, die bestimmungsgemäß für die Bewertung des angemessenen Bildungsniveaus einer Person verwendet werden sollen und das Niveau der Bildung und Ausbildung, das die Person erhält oder zu dem sie Zugang erhält, wesentlich beeinflussen;

bb) KI-Systeme, die bestimmungsgemäß zur Überwachung und Erkennung von unzulässigem Verhalten von Schülern und Studierenden bei Prüfungen im Rahmen von/in Einrichtungen der allgemeinen und beruflichen Bildung verwendet werden sollen;

4. Beschäftigung, Personalmanagement und Zugang zur Selbstständigkeit:

a) KI-Systeme, die bestimmungsgemäß für die Einstellung oder Auswahl natürlicher Personen verwendet werden sollen, insbesondere für die Bekanntmachung gezielter Stellenausschreibungen, das Sichten oder Filtern von Bewerbungen und das Bewerten von Bewerbern in Vorstellungsgesprächen oder Tests;

b) KI-Systeme, die bestimmungsgemäß für Entscheidungen oder zur erheblichen Einflussnahme auf Entscheidungen betreffend die Einstellung, Beförderung und Kündigung von Arbeitsvertragsverhältnissen, die Aufgabenzuweisung auf der Grundlage des individuellen Verhaltens oder persönlicher Eigenschaften oder Merkmale oder für die Überwachung und Bewertung der Leistung und des Verhaltens von Personen in solchen Beschäftigungsverhältnissen verwendet werden sollen;

5. Zugänglichkeit und Inanspruchnahme grundlegender privater und öffentlicher Dienste und Leistungen:

a) KI-Systeme, die bestimmungsgemäß von Behörden oder im Namen von Behörden verwendet werden sollen, um zu beurteilen, ob natürliche Personen Anspruch auf öffentliche Unterstützungsleistungen und ‑dienste haben, einschließlich Gesundheitsdienstleistungen und wesentlicher Dienstleistungen, einschließlich, jedoch nicht beschränkt auf Wohnen, Strom, Heizung/Kühlung und Internet, und ob solche Leistungen und Dienste zu gewähren, einzuschränken, zu widerrufen, zu erhöhen oder zurückzufordern sind;

b) KI-Systemen, die bestimmungsgemäß für die Kreditwürdigkeitsprüfung und Kreditpunktebewertung natürlicher Personen verwendet werden sollen, mit Ausnahme von KI-Systemen, die zur Aufdeckung von Finanzbetrug verwendet werden;

ba) KI-Systeme, die bestimmungsgemäß für Entscheidungen oder zur wesentlichen Einflussnahme auf Entscheidungen darüber, ob eine natürliche Person für eine Kranken- oder Lebensversicherung in Frage kommt, verwendet werden sollen;

c) KI-Systeme, die bestimmungsgemäß zur Bewertung und Klassifizierung von Notrufen von natürlichen Personen oder für die Entsendung oder Priorisierung des Einsatzes von Not- und Rettungsdiensten, einschließlich Polizei und Strafverfolgungsbehörden, Feuerwehr und medizinischer Nothilfe, sowie für Systeme für die Triage von Patienten bei der Notfallversorgung verwendet werden sollen;

6. Strafverfolgung:

b) KI-Systeme, die bestimmungsgemäß von Strafverfolgungsbehörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union als Lügendetektoren und ähnliche Instrumente – sofern deren Verwendung gemäß den relevanten nationalen Rechtsvorschriften und denen der Union zugelassen ist – verwendet werden sollen;

d) KI-Systeme, die bestimmungsgemäß von Strafverfolgungsbehörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union zur Unterstützung von Strafverfolgungsbehörden zur Bewertung der Verlässlichkeit von Beweismitteln im Zuge der Ermittlung oder Verfolgung von Straftaten verwendet werden sollen;

f) KI-Systeme, die bestimmungsgemäß von Strafverfolgungsbehörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union zur Unterstützung von Strafverfolgungsbehörden zur Erstellung von Profilen natürlicher Personen gemäß Artikel 3 Absatz 4 der Richtlinie (EU) 2016/680 im Zuge der Aufdeckung, Ermittlung oder Verfolgung von Straftaten oder im Falle von Organen, Einrichtungen oder sonstigen Stellen der Union gemäß Artikel 3 Nummer 5 der Verordnung (EU) 2018/1725 verwendet werden sollen;

g) KI-Systeme, die bestimmungsgemäß von Strafverfolgungsbehörden oder in ihrem Auftrag oder von Organen, Einrichtungen und sonstigen Stellen der Union zur Unterstützung von Strafverfolgungsbehörden zur Kriminalanalyse natürlicher Personen eingesetzt werden sollen und es den Strafverfolgungsbehörden ermöglichen, große komplexe verknüpfte und unverknüpfte Datensätze aus verschiedenen Datenquellen oder in verschiedenen Datenformaten zu durchsuchen, um unbekannte Muster zu erkennen oder verdeckte Beziehungen in den Daten aufzudecken.

7. Migration, Asyl und Grenzkontrolle:

a) KI-Systeme, die bestimmungsgemäß von zuständigen Behörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union als Lügendetektoren und ähnliche Instrumente verwendet werden sollen, sofern ihre Verwendung gemäß den einschlägigen Rechtsvorschriften der Union oder den einschlägigen nationalen Rechtsvorschriften zugelassen ist;

b) KI-Systeme, die bestimmungsgemäß von zuständigen Behörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union zur Bewertung eines Risikos verwendet werden sollen, einschließlich eines Sicherheitsrisikos, eines Risikos der irregulären Einwanderung oder eines Gesundheitsrisikos, das von einer natürlichen Person ausgeht, die in das Hoheitsgebiet eines Mitgliedstaats einzureisen beabsichtigt oder eingereist ist;

c) KI-Systeme, die bestimmungsgemäß von zuständigen Behörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union zur Überprüfung der Echtheit von Reisedokumenten und Nachweisunterlagen natürlicher Personen und zur Erkennung unechter Dokumente durch Prüfung ihrer Sicherheitsmerkmale verwendet werden sollen;

d) KI-Systeme, die bestimmungsgemäß von zuständigen Behörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union verwendet werden sollen, um zuständige Behörden bei der Prüfung und Bewertung des Wahrheitsgehalts von Nachweisen von Asyl- und Visumanträgen sowie Aufenthaltstiteln und damit verbundenen Beschwerden im Hinblick auf die Feststellung der Berechtigung der den Antrag stellenden natürlichen Personen zu unterstützen;

da) KI-Systeme, die bestimmungsgemäß von zuständigen Behörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union in den Bereichen Migration, Asyl und Grenzkontrolle für die Überwachung, Kontrolle oder Verarbeitung von Daten im Zusammenhang mit Grenzkontrolltätigkeiten zur Detektion, Erkennung oder Identifizierung von natürlichen Personen verwendet werden sollen

db) KI-Systeme, die bestimmungsgemäß von zuständigen Behörden oder in deren Namen oder von Organen, Einrichtungen und sonstigen Stellen der Union in den Bereichen Migration, Asyl und Grenzkontrolle für die Vorhersage und Prognose von Trends im Hinblick auf Migration, Bewegungen und Grenzübertritte verwendet werden sollen

8. Rechtspflege und demokratische Prozesse:

a) KI-Systeme, die bestimmungsgemäß von Justiz- oder Verwaltungsbehörden oder in deren Namen zur Unterstützung einer Justiz- oder Verwaltungsbehörde bei der Ermittlung und Auslegung von Sachverhalten und Rechtsvorschriften und bei der Anwendung des Rechts auf konkrete Sachverhalte verwendet oder auf ähnliche Weise in einem alternativem Streitbeilegungsverfahren eingesetzt werden sollen.

aa) KI-Systeme, die bestimmungsgemäß verwendet werden sollen, um das Ergebnis einer Wahl oder eines Referendums oder das Wahlverhalten natürlicher Personen bei der Ausübung ihres Wahlrechts bei einer Wahl oder einem Referendum zu beeinflussen. Dies umfasst keine KI-Systeme, deren Ergebnissen natürliche Personen nicht direkt ausgesetzt sind, wie Instrumente zur Organisation, Optimierung und Strukturierung politischer Kampagnen in administrativer und logistischer Hinsicht.

ab) KI-Systeme, die bestimmungsgemäß von Social-Media-Plattformen, die im Sinne des Artikels 33 der Verordnung (EU) Nr. 2022/2065 als sehr große Online-Plattformen gelten, in ihren Empfehlungssystemen verwendet werden sollen, um dem Empfänger der Dienstleistung auf der Plattform verfügbare nutzergenerierte Inhalte zu empfehlen.

Das KI-Gesetz folgt einem risikobasierten Ansatz. Besondere Aufmerksamkeit wird den sogenannten HOCHRISIKO-KI-Systemen gewidmet. Der Anhang III liefert nicht nur die detaillierte Definition, welche KI-Systeme hochriskant sind und strikte staatliche Überwachung/Regulierung benötigen, sondern eine Offenlegung, in welchem massiven Umfang solche Systeme kurz- bis mittelfristig eingesetzt werden. Nur zum Klarstellen – hier wird nicht diskutiert, ob solche KI-Systeme eingesetzt werden, sondern wie der Staat diese Systeme effektiv unter Kontrolle hält.

Die EU-Kommission setzt voraus, dass jedes Individuum in fast allen Bereichen seines Alltags von den HOCHRISIKO KI-Systemen erfasst, bewertet und überprüft wird. Im Ergebnis wird dann mehr oder weniger über sein „Schicksal“ (Ausbildung, Beruflicher Werdegang, Zugang zu Dienstleistungen und finanziellen Mitteln, Bewegungsfreiheit, Rechtschutz, Strafverfolgung, usw.) entschieden. Es stellt sich die Frage, ob das mit dem Europäischen Konzept für Exzellenz und Vertrauen gemeint ist?

Wozu dieses HOCHRISIKO eingehen? Reicht der bereits vorhandene Behörden- und Beamtenapparat nicht mehr aus? Offensichtlich nicht, wenn sowohl der Umfang als auch die Tiefe der Regulierung jedes einzelnen Individuums weiter ausgeweitet werden. Denken wir an Hararis subtile Schlagwortkombination:

Chaos – autoritäre Regime – offene Gesellschaft

Bei einem „robusten und flexiblen Rechtsrahmen“ sind diese Übergänge „fließend“.

Damit diese besorgniserregende Betrachtungsweise nicht die Oberhand in der Öffentlichkeit gewinnt, bemüht sich das KI-Gesetz mit großem Aufwand „einen kohärenten, wirksamen und angemessenen Rahmen zu schaffen, mit dem sichergestellt wird, dass KI so entwickelt wird, dass die Rechte der Menschen geachtet werden und sie ihr Vertrauen verdient – damit ist Europa für das digitale Zeitalter gewappnet und die nächsten zehn Jahre werden zur digitalen Dekade.“

(Quelle: Dokument 1, Kapitel 1.3, Seite 6).

Auf der Basis von Expertenwissen (52 renommierte KI-Sachverständige, KI-Allianz aus ca. 4.000 Interessenträgern, extern beauftrage Studien) hat man auf 120 Seiten beschrieben, wie KI-Systeme, insbesondere HOCHRISIKO-KI-Systeme, staatlich kontrolliert und damit als „vertrauenswürdig“ klassifiziert werden.

Spezielle Aufmerksamkeit wird der Einhaltung der Grundrechte gewidmet. Dabei wird die EU-Grundrechtcharta zugrunde gelegt.

Neben den individuellen und gruppenspezifischen Grundrechten enthält das KI-Gesetz auch die Formulierung: Darüber hinaus geht es um das Recht auf ein hohes Umweltschutzniveau und die Verbesserung der Umweltqualität (Artikel 37), auch in Bezug auf die Gesundheit und Sicherheit von Menschen

(Quelle: Dokument 1, Kapitel 1.5, Seite 13).

Warum ist das interessant? Nun, ähnliche Ansätze und Formulierungen findet man in dem Entwurf des WHO-Pandemievertrags, der gerade jetzt verhandelt wird. Ein wichtiger Vertragspunkt ist dort der sogenannte ONE-HEALTH-Ansatz. Dieser definiert den Einfluss der Klimaänderung auf die Ökosysteme Umwelt-Tier-Mensch als permanente potentielle Gefahr für das Entstehen von globalen Pandemien. Der WHO-Chef warnt: Neues Virus könnte auftauchen – tödlicher als Corona.

Die Vertragsparteien werden verpflichtet, multisektorale, koordinierte, interoperable und integrierte One-Health-Überwachungssysteme aufzubauen. Wenn die WHO einen Pandemiefall feststellt, dann übernimmt sie die weltweite Kontrolle der Pandemiebekämpfung und definiert für alle Vertragsparteien verbindliche Maßnahmen. Diese können ärztliche Pflichtuntersuchungen, Pflichtimpfungen und Medikationen, Überprüfungen vom Impfstatus, weitreichende Quarantänemaßnahmen, usw. beinhalten. Weitere Details diesbezüglich kann man im Artikel „Der WHO-Pandemievertrag“ nachlesen.

Wie wird der Einsatz von den oben besprochenen HOCHRISIKO-KI Systemen unter solchen Bedingungen wohl aussehen? Welche Grundrechte werden in den Vordergrund und welche in den Hintergrund geraten? Wie wird der Deutsche Ethikrat (siehe dazu auch Vulnerabilität und Resilienz in der Krise – Ethische Kriterien für Entscheidungen in einer Pandemie) entscheiden? Was meinen Sie?

Neben solchen Hardcore-Szenarien werden wir kurzfristig zunehmend mit diversen “Soft“- Ausführungen konfrontiert. Ein konkretes Beispiel stellt die Debatte um die 15-Minuten Städte dar. In der Frankfurter Rundschau lesen wir diesbezüglich: „Die Grundidee ist einfach: Die Stadtbewohner und Stadtbewohnerinnen sollen sich innerhalb ihrer Stadt weniger bewegen müssen, weil sie alle wichtigen Orte in 15 Minuten erreichen, und damit Klima und Nerven schonen. Bei der 15-Minuten-Stadt geht es nicht darum, die Bürger einzusperren oder einzuschränken, sondern ihnen Zeit zu verschaffen. Es geht nicht darum, Bewegung zu verhindern, sondern darum, jedem die Wahl zu lassen, sich zu bewegen. Das Konzept ist ein Vorschlag für „glückliche Nähe“, nicht für ein Gefängnis“.

Wer etwas anderes behauptet, ist ein Verschwörungstheoretiker. Wie man die Leute dazu bringen will, sich weniger mit dem Auto zu bewegen, sieht man in der britischen Stadt Oxford. Hier will man ab 2024 für sechs Monate ein Kameraüberwachungssystem (Traffic Filter) testen, dass Fahrverbote für Autos in einigen Streckenabschnitten der Stadt kontrollieren soll. Wie die lokalen Politiker versuchen, diese Idee der lokalen Bevölkerung „schmackhaft“ zu machen, kann man in diesem kurzen Videobeitrag sehen:

Die „glückliche Nähe“ und die Wahl sich zu bewegen, wird also vorerst mit Strafzetteln „konditioniert“. Wie die Konditionierung bei Wiederholungstätern oder später ausfallen soll, wird hier nicht diskutiert.

Ob ein HOCHRISIKO-KI-System als konform und vertrauenswürdig gemäß dieses KI-Gesetzes klassifiziert wird, ist das eine. Viel wichtiger ist jedoch, wie vertrauenswürdig die politischen Machtstrukturen sind, die die Entwicklung solcher Systeme beauftragen, die rechtlichen Rahmenbedingungen für deren Einsatz definieren und die Art und Weise, wie sie die Rahmenbedingungen unter bestimmten Situationen interpretieren bzw. modifizieren. In dem KI-Gesetz sucht man vergeblich nach einer Antwort auf dieser Frage.

“Du wirst nicht danach beurteilt,

was du sagst, sondern was du tust.“

Rosa Luxemburg

Und wie wird ChatGPT im Hinblick des KI-Gesetzes behandelt? Neue Dienste wie ChatGPT sollen demnach zwar nicht von vornherein als hochriskant eingestuft, aber trotzdem besonders streng reguliert werden. Betreiber von KI-Basismodellen, die auf einer umfangreichen Menge nicht-kategorisierter Daten im großen Stil trainiert wurden, müssten aber vorhersehbare Risiken für Gesundheit, Sicherheit, Grundrechte, Umwelt, Demokratie und Rechtsstaatlichkeit unter Einbeziehung unabhängiger Experten prüfen und gegebenenfalls abmildern. Ihre Modelle müssen sie in der EU-Datenbank registrieren, bevor sie auf den EU-Markt kommen. Generative KI-Systeme, die auf solchen Modellen beruhen, wie ChatGPT, müssten Transparenzanforderungen erfüllen (und offenlegen, dass die Inhalte von KI generiert wurden, was auch dazu beiträgt, sogenannte Deep-Fake-Bilder von echten Bildern zu unterscheiden) und Schutzmaßnahmen gegen die Generierung illegaler Inhalte gewährleisten. Detaillierte Zusammenfassungen der urheberrechtlich geschützten Daten, die für ihr Training verwendet wurden, müssten ebenfalls öffentlich zugänglich gemacht werden.

[Quelle: Europäisches Parlament]

KI-Bot – Manipulation

KI-Oracle – Kontrolle – Macht

Illusionen – Wahlen – Klimawandel – Impfstoffe – Schaden

Medikamente SICHER – Biotech-Labore SICHER – KI muss SICHER sein

Auch hier folgen die EU-Abgeordneten der Logik des WEF-Beraters Harari.

Wie wird wohl ChatGPT auf Fragen bezüglich der Corona-Maßnahmen der letzten Jahre, oder bezüglich der Zulassung, Effektivität und Nebenwirkungen von mRNA-Impfstoffen oder bezüglich des CO2-Fußabdrucks von E-Autos oder zum Ukraine-Krieg antworten?

Die Antworten sind letztendlich egal, solange diese im Einklang mit dem jeweils geltenden Gesundheits-, Sicherheits-, Grundrechte-, Umwelt-, Demokratie- und Rechtsstaatlichkeitsnarrativ sind.

Einige Beispiele wie das bereits in die Praxis umgesetzt wird, kann man in dem Artikel „Nationale Sicherheitsstrategie – Fragen an ChatGPT“ nachlesen.

Damit ist Europa für das digitale Zeitalter gewappnet und die nächsten zehn Jahre werden zur digitalen Dekade.

Quellen (Stand 01.09.2023)